吉客云数据集成到MySQL的技术案例分享

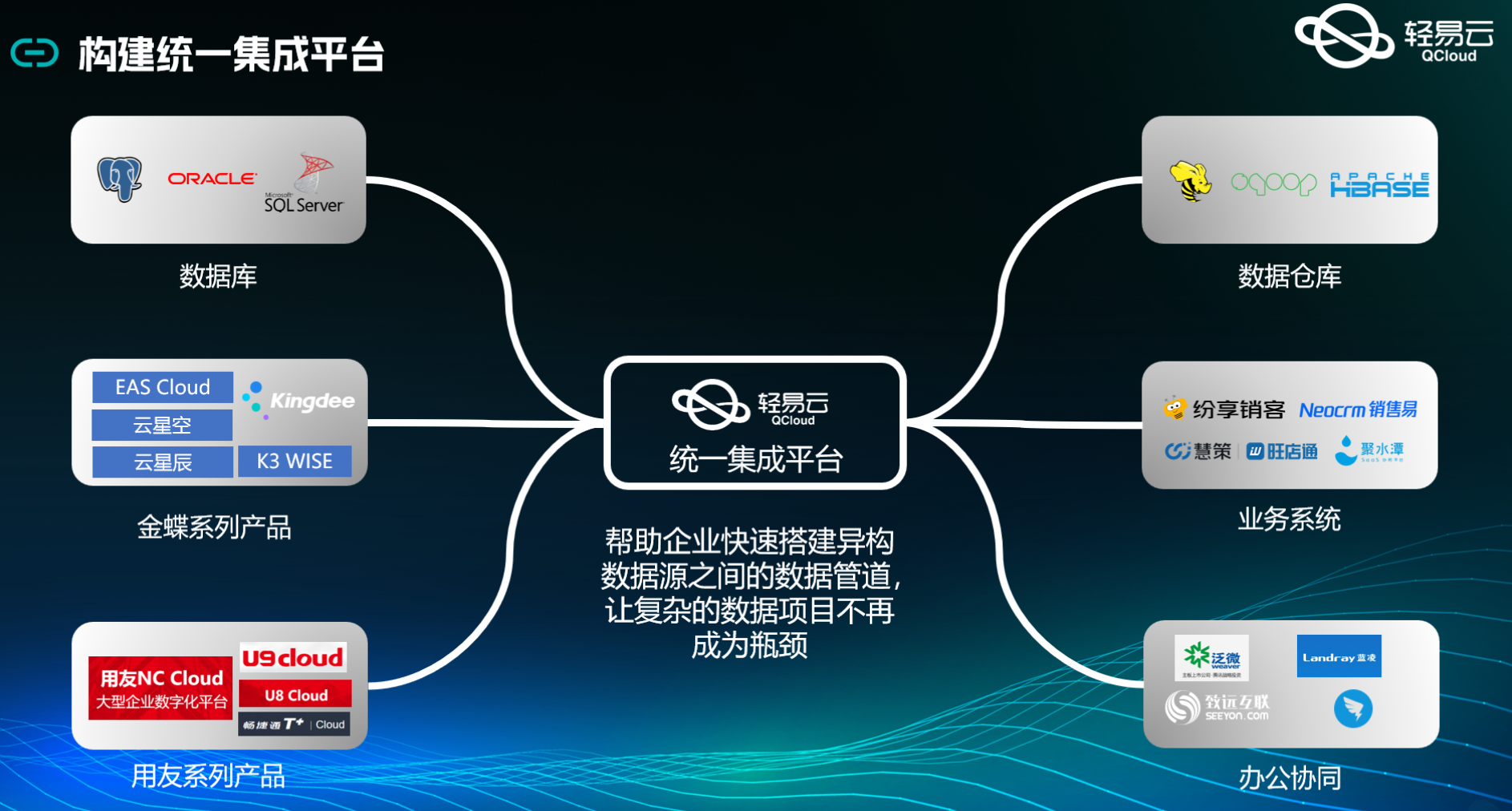

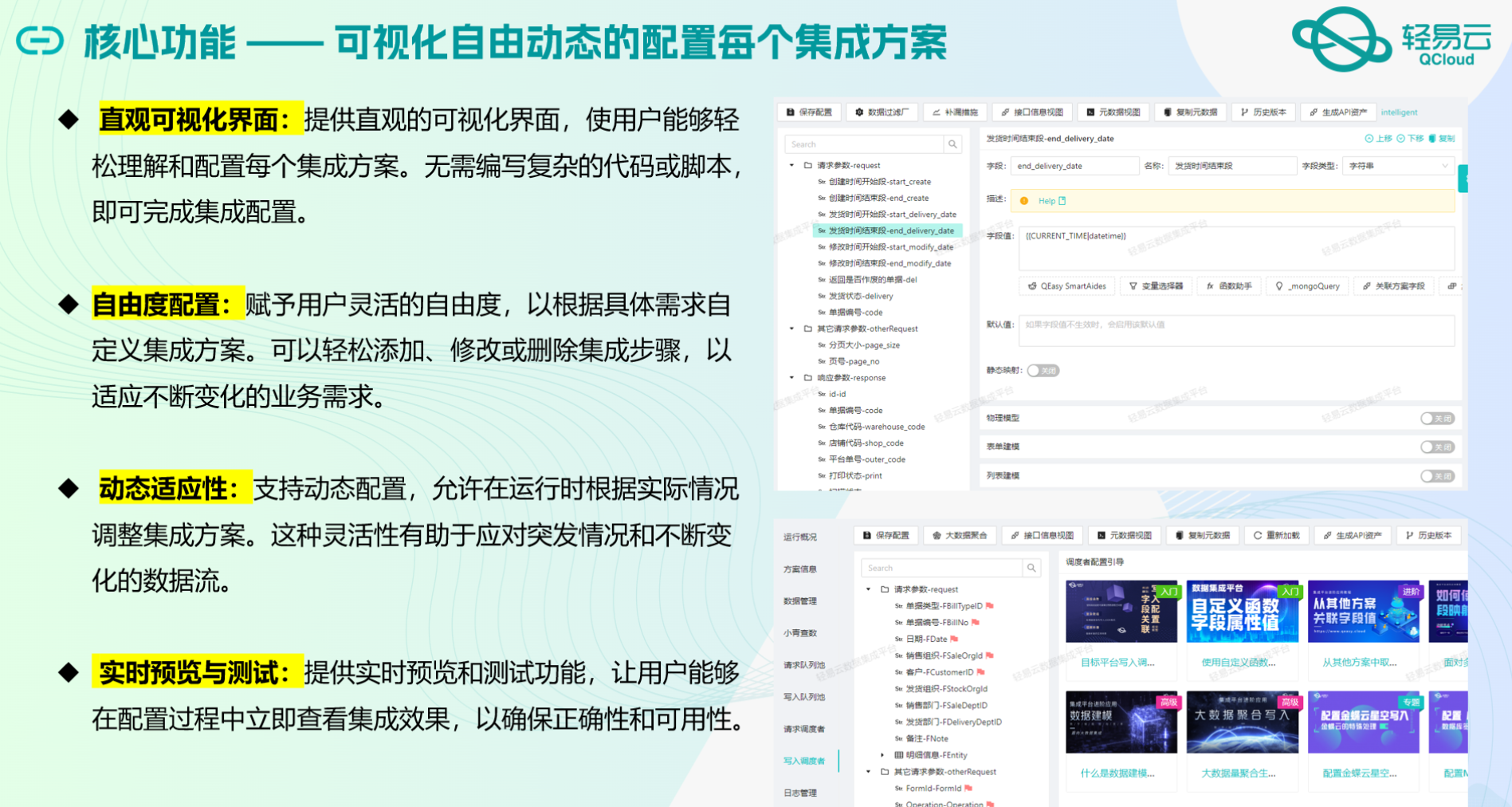

在现代企业的数据管理中,系统间的数据集成是一个关键环节。本文将分享一个具体的技术案例,展示如何通过轻易云数据集成平台,将吉客云中的货品数据高效、安全地集成到MySQL数据库中。

在本次案例中,我们主要利用了吉客云提供的API接口erp.storage.goodslist来获取货品数据,并通过MySQL的insert操作实现数据写入。整个过程不仅需要处理大量数据的快速写入,还要确保数据质量和实时监控。

首先,为了保证高吞吐量的数据写入能力,我们采用了批量处理的方法,将从吉客云获取的大量货品数据分批次写入MySQL。这种方式不仅提升了数据处理的时效性,还有效避免了单次大规模写入可能带来的性能瓶颈问题。

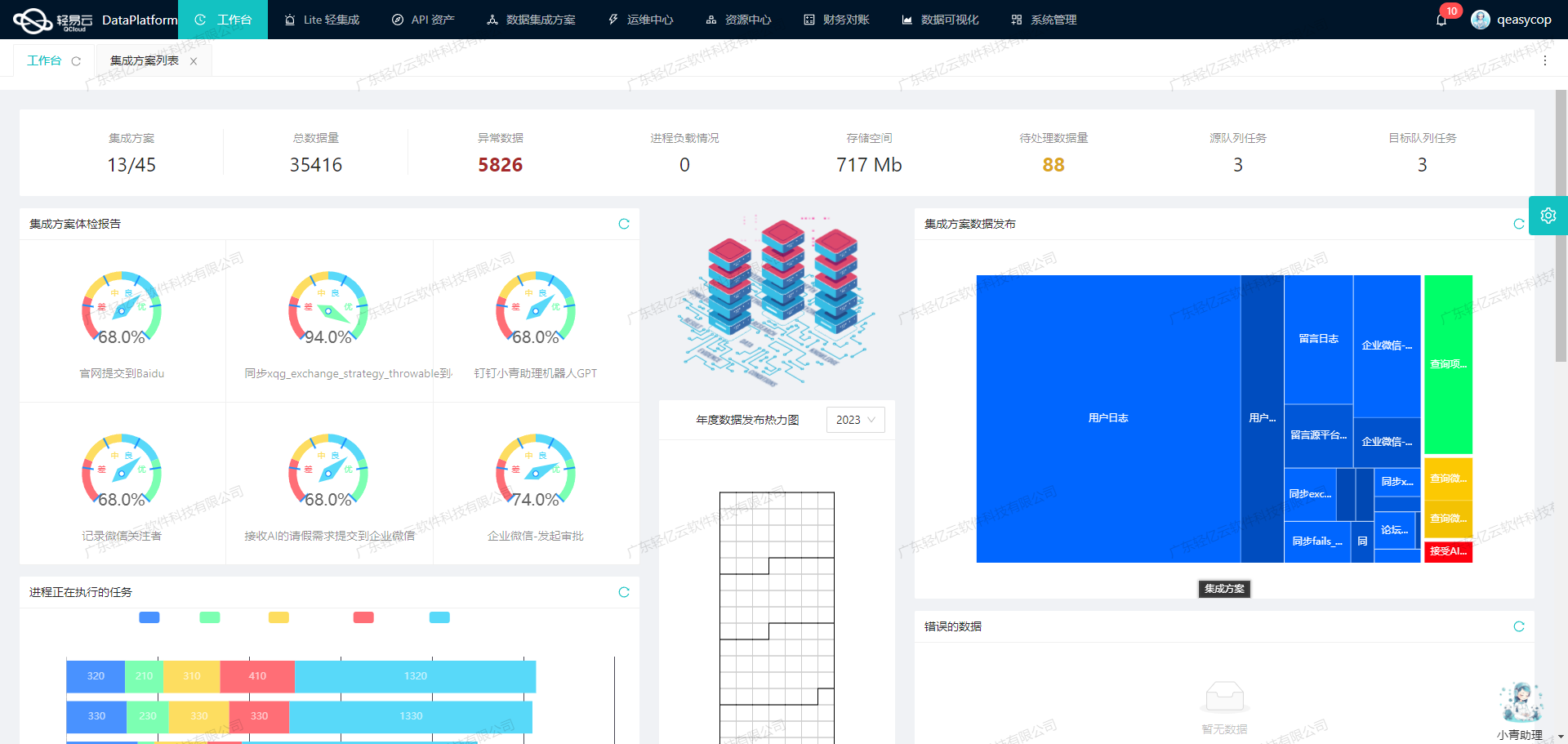

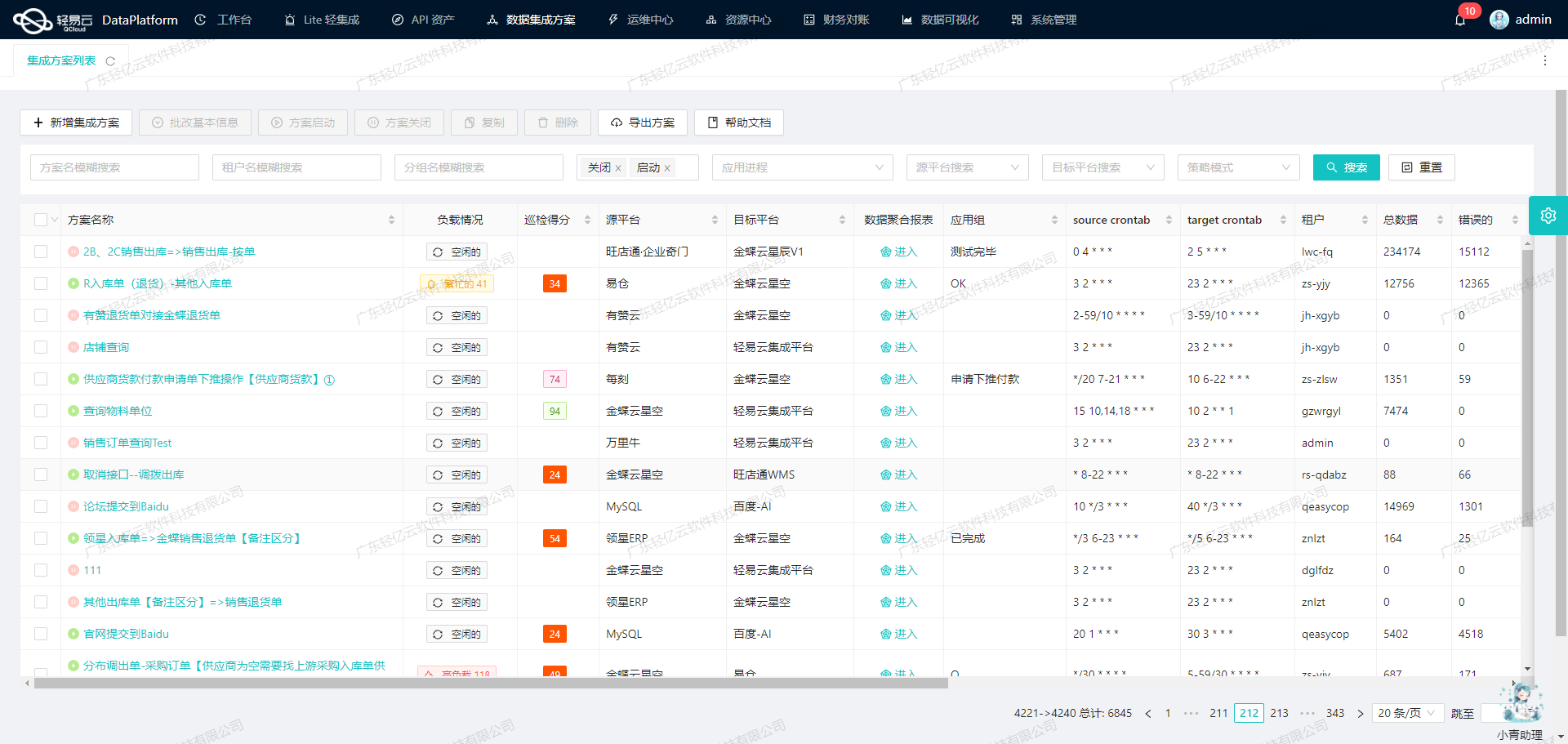

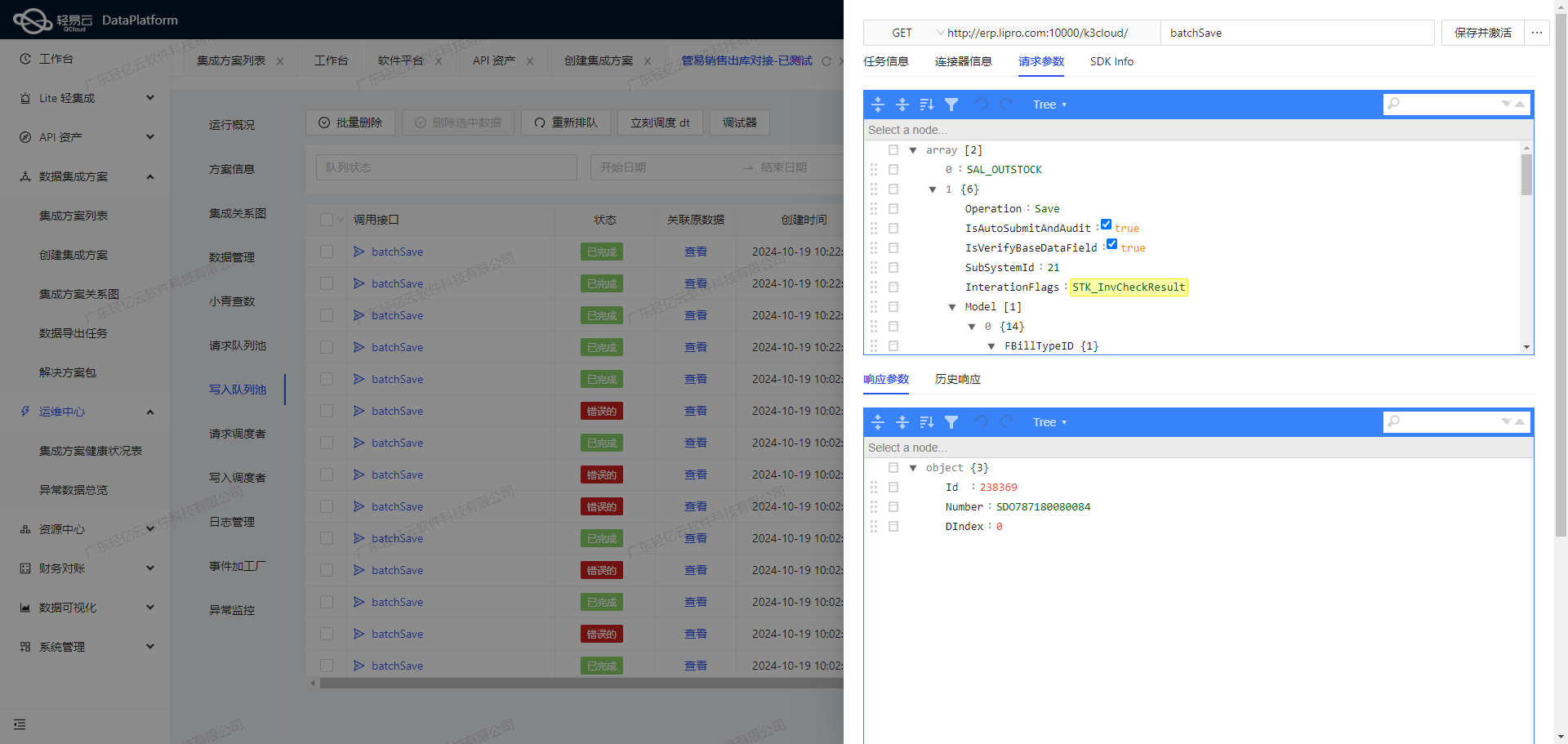

其次,通过轻易云平台提供的集中监控和告警系统,我们能够实时跟踪每个数据集成任务的状态和性能。一旦出现异常情况,系统会立即发出告警通知,使得我们可以及时采取措施进行处理,从而保障整个集成过程的稳定性和可靠性。

此外,在实际操作过程中,我们还需要应对吉客云接口分页和限流的问题。为此,我们设计了一套可靠的抓取机制,定时调用吉客云API接口erp.storage.goodslist,并根据返回结果进行分页处理,以确保所有货品数据都能被完整、准确地获取并传输到MySQL数据库中。

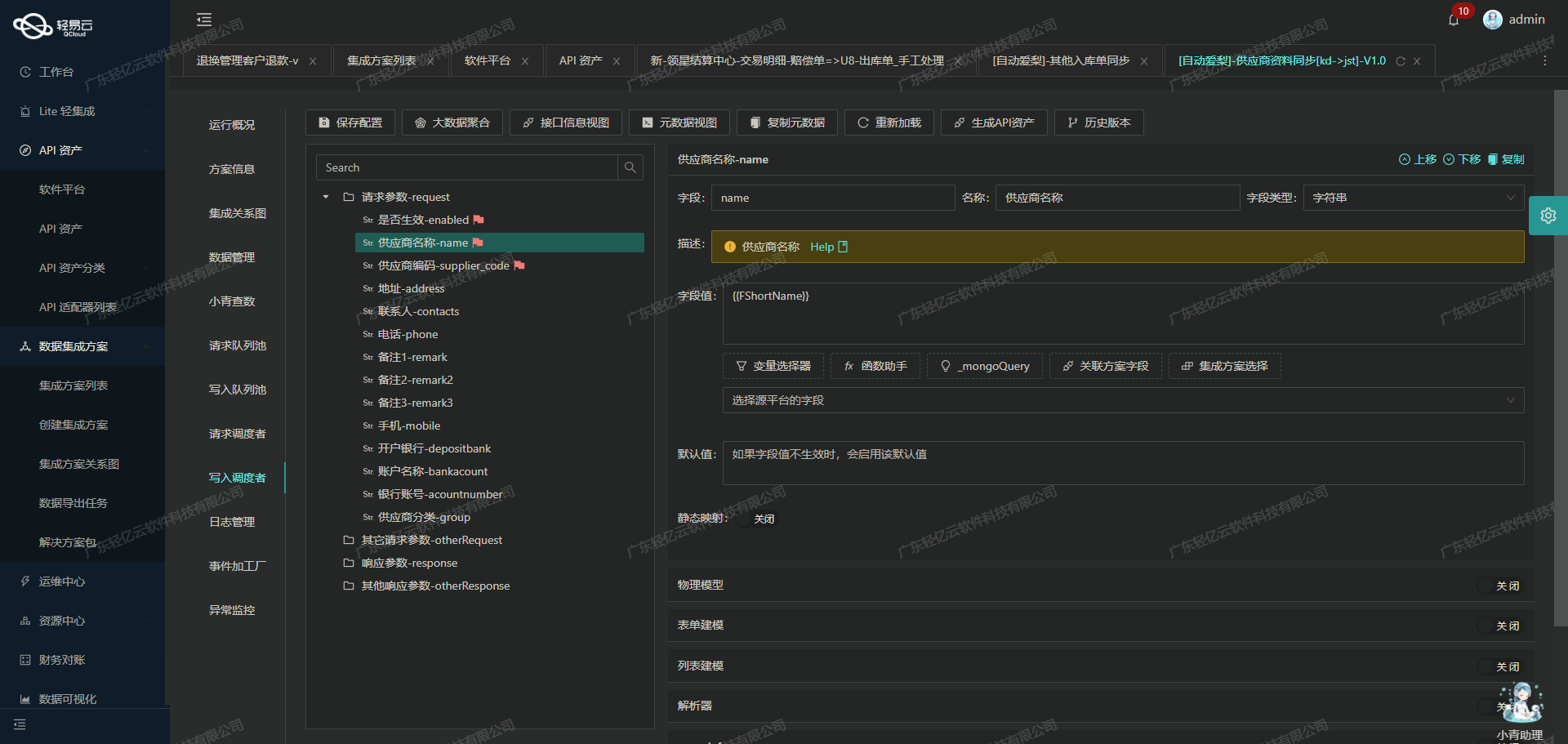

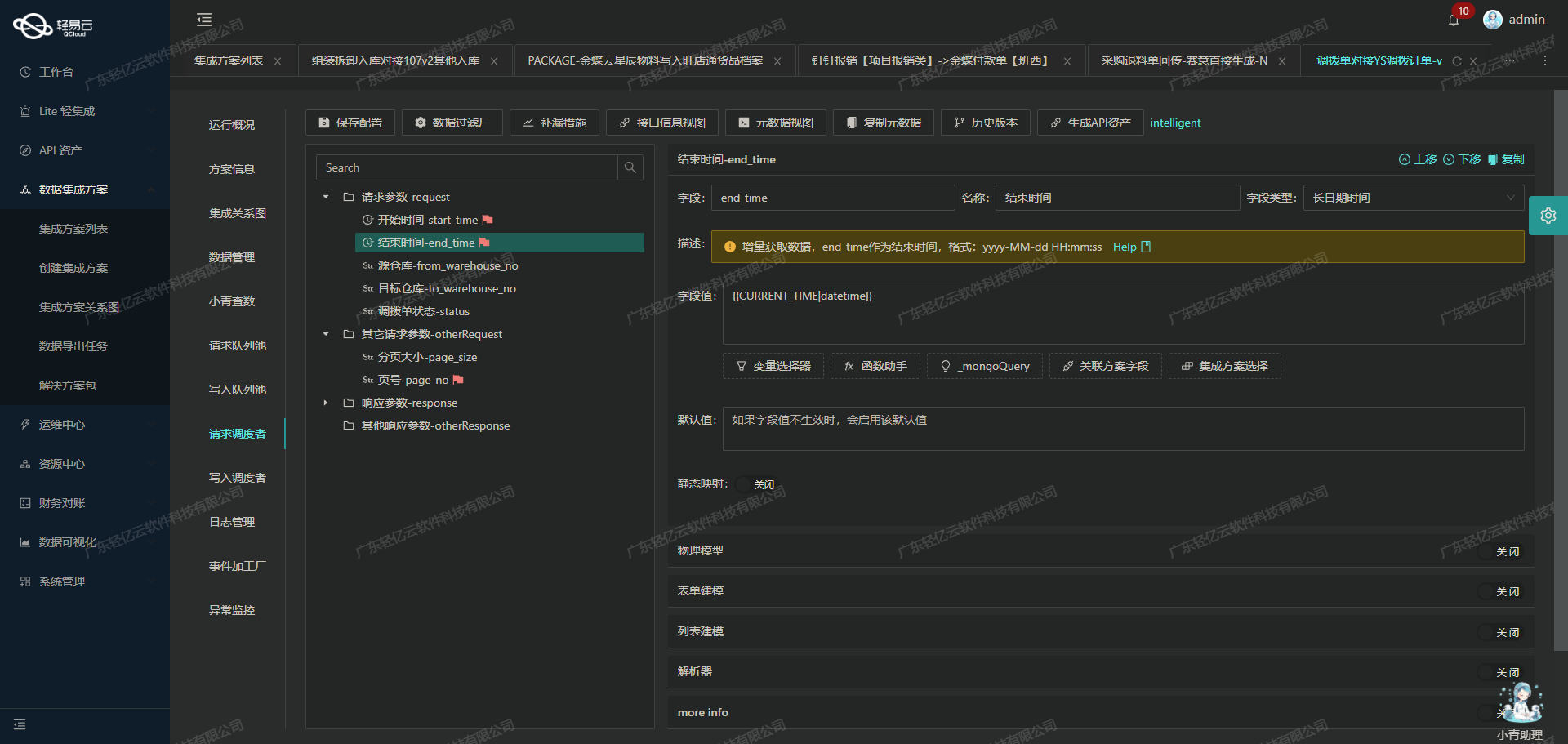

最后,为了解决吉客云与MySQL之间的数据格式差异问题,我们使用了自定义的数据转换逻辑。在轻易云平台上,通过可视化的数据流设计工具,对不同格式的数据进行映射和转换,使其符合目标数据库的结构要求。这一过程不仅简化了复杂的数据转换操作,也提高了整体集成效率。

通过上述方法,本次“货品”方案成功实现了吉客云与MySQL之间的数据无缝对接,不仅提升了业务透明度,还显著提高了企业的数据管理效率。后续章节将详细介绍具体实施步骤及技术细节。

调用吉客云接口erp.storage.goodslist获取并加工数据

在轻易云数据集成平台的生命周期中,调用源系统接口是至关重要的一步。本文将重点探讨如何通过调用吉客云接口erp.storage.goodslist来获取货品数据,并进行相应的数据处理。

配置元数据

首先,我们需要配置元数据,以便正确地调用吉客云的API接口。根据提供的元数据配置,以下是主要字段及其含义:

- api:

erp.storage.goodslist - method:

POST - number:

goodsNo - id:

goodsId - pagination: 每页50条记录

- idCheck: 启用ID检查

- request参数:

pageIndex: 分页页码pageSize: 分页页数goodsNo: 货品编号skuBarcode: 条码goodsName: 货品名称skuName: 规格名称abcCate: ABC分类(A类, B类, C类)startDate: 创建起始时间endDate: 创建结束时间

调用API接口

为了高效地从吉客云获取货品数据,我们需要实现分页请求。每次请求返回的数据量由pageSize控制,这里设置为50条记录。通过循环递增pageIndex,可以逐页获取所有符合条件的数据。

def fetch_goods_data(page_index):

payload = {

"pageIndex": page_index,

"pageSize": metadata["pagination"]["pageSize"],

# 可以根据实际需求添加其他过滤条件,如 goodsNo, startDate 等。

}

response = requests.post(api_url, json=payload)

return response.json()数据清洗与转换

在获取到原始数据后,需要对其进行清洗和转换,以适应目标系统的要求。这一步通常包括字段映射、格式转换和异常处理等操作。例如,将日期格式统一为ISO标准,将分类代码转换为业务系统中的对应值等。

def clean_and_transform(data):

cleaned_data = []

for item in data:

transformed_item = {

"商品编号": item["goodsNo"],

"商品名称": item["goodsName"],

"条码": item["skuBarcode"],

"规格名称": item["skuName"],

"分类": transform_category(item["abcCate"]),

"创建时间": convert_date_format(item["createTime"])

}

cleaned_data.append(transformed_item)

return cleaned_data

def transform_category(category_code):

category_mapping = {"A": "一级", "B": "二级", "C": "三级"}

return category_mapping.get(category_code, "未知")

def convert_date_format(date_str):

# 假设输入日期格式为 'YYYY-MM-DD HH:mm:ss'

return datetime.strptime(date_str, '%Y-%m-%d %H:%M:%S').isoformat()异常处理与重试机制

在实际操作中,网络波动或API限流可能导致请求失败。因此,需要设计合理的异常处理与重试机制,以确保数据不漏单。例如,可以在捕获异常后等待一段时间再重试,并设置最大重试次数以避免无限循环。

import time

MAX_RETRIES = 3

def fetch_with_retries(page_index):

retries = 0

while retries < MAX_RETRIES:

try:

data = fetch_goods_data(page_index)

return data

except Exception as e:

retries += 1

time.sleep(2 ** retries) # 指数退避策略

raise RuntimeError("Failed to fetch data after multiple attempts")实时监控与日志记录

为了确保整个过程透明可控,轻易云平台提供了实时监控和日志记录功能。通过这些工具,可以实时跟踪每个请求的状态和性能,并及时发现和解决潜在问题。

import logging

logging.basicConfig(level=logging.INFO)

def log_request_status(page_index, status):

logging.info(f"Page {page_index}: {status}")

# 在每次请求完成后记录状态:

log_request_status(page_index, 'Success')以上步骤涵盖了从调用吉客云接口获取货品数据,到清洗、转换、异常处理以及监控的全过程。在实际应用中,根据具体业务需求,还可以进一步优化和定制化这些流程。

集成数据写入MySQL的ETL转换

在数据集成的生命周期中,第二步是将已经从源平台集成的数据进行ETL(抽取、转换、加载)转换,以确保数据能够顺利写入目标平台MySQL。在此过程中,我们需要特别关注数据格式的转换、数据质量的监控以及接口调用的优化。

数据抽取与清洗

首先,从源平台获取的数据需要进行初步的清洗和验证。比如,确保每条记录都有唯一标识(ID),并且所有必需字段都存在且符合预期格式。这一步骤至关重要,因为它决定了后续转换和写入操作的稳定性。

{

"api": "insert",

"method": "POST",

"idCheck": true,

"request": [

{

"label": "主表参数",

"field": "main_params",

"type": "object",

...

}

]

}数据转换逻辑

接下来是数据转换阶段。我们需要根据目标平台MySQLAPI接口的要求,将源平台的数据映射到相应的字段,并进行必要的数据类型转换。例如,将源平台中的商品编码goodsNo映射到MySQL中的code字段,同时处理其他相关字段如备注remark。

{

"parent": "main_params",

"label": "编码",

"field": "code",

"type": "string",

"value": "{goodsNo}"

}这种映射关系通过配置元数据来实现,使得整个过程高度自动化和可配置化。对于复杂的数据结构,可以使用自定义的数据转换逻辑,以适应特定业务需求。

数据写入MySQL

完成数据转换后,即可将数据写入MySQL。这里我们采用批量插入的方法,提高数据处理效率和吞吐量。例如,主表插入语句如下:

INSERT INTO `main_goods`

(`id`, `code`, `name`, `status`, `bar_code`, `model`, `category_id`, `class_id`,

`gross_weight`, `net_weight`, `length`, `width`, `height`, `volume`,

`default_tax_rate`, `unit_id`, `default_owner_org_id`)

VALUES

(<{id: }>, <{code: }>, <{name: }>, <{status: 1}>, <{bar_code: }>, <{model: }>,

<{category_id: }>, <{class_id: }>, <{gross_weight: 0.00000}>, <{net_weight: 0.00000}>,

<{length: 0.00000}>, <{width: 0.00000}>, <{height: 0.00000}>, <{volume: 0.00000}>,

<{default_tax_rate: 0.13000}>, <{unit_id: }>, <{default_owner_org_id: }>);此外,还需处理扩展表的数据插入,如商品控制表:

INSERT INTO `lehua_test`.`main_goods_control`

(`goods_id`, `is_purchase`, `is_sale`, `is_inventory`,

`is_production`, `is_entrusted`, `is_assets`)

VALUES

(<{lastInsertId: }>, <{is_purchase: 1}>, <{is_sale: 1}>,

<{is_inventory: 1}>, <{is_production: 1}>, <{is_entrusted: 1}>,

<{is_assets: 1}>);这种方式不仅保证了数据的一致性,还能有效利用数据库的批量操作能力,提升整体性能。

实时监控与异常处理

在整个ETL过程中,实时监控和异常处理同样不可或缺。通过集中的监控系统,我们可以及时发现并处理数据问题,确保数据集成过程顺利进行。同时,针对可能出现的接口调用异常,我们设计了错误重试机制,以提高系统的可靠性。

最后,通过日志记录和告警系统,我们能够全面掌握每个数据集成任务的状态和性能,及时响应任何潜在问题。这些措施共同保障了高效、可靠的数据集成体验。

总之,通过合理配置元数据及优化ETL流程,我们能够高效地将源平台的数据转化为目标平台MySQLAPI接口所能接受的格式,并顺利写入目标数据库,从而实现不同系统间的数据无缝对接。