钉钉数据集成到SQL Server的技术案例分享

在现代企业的数据管理中,如何高效地将钉钉平台上的数据集成到SQL Server中,是一个极具挑战性的任务。本文将通过具体的技术方案1122131,详细探讨这一过程中的关键技术点和解决方案。

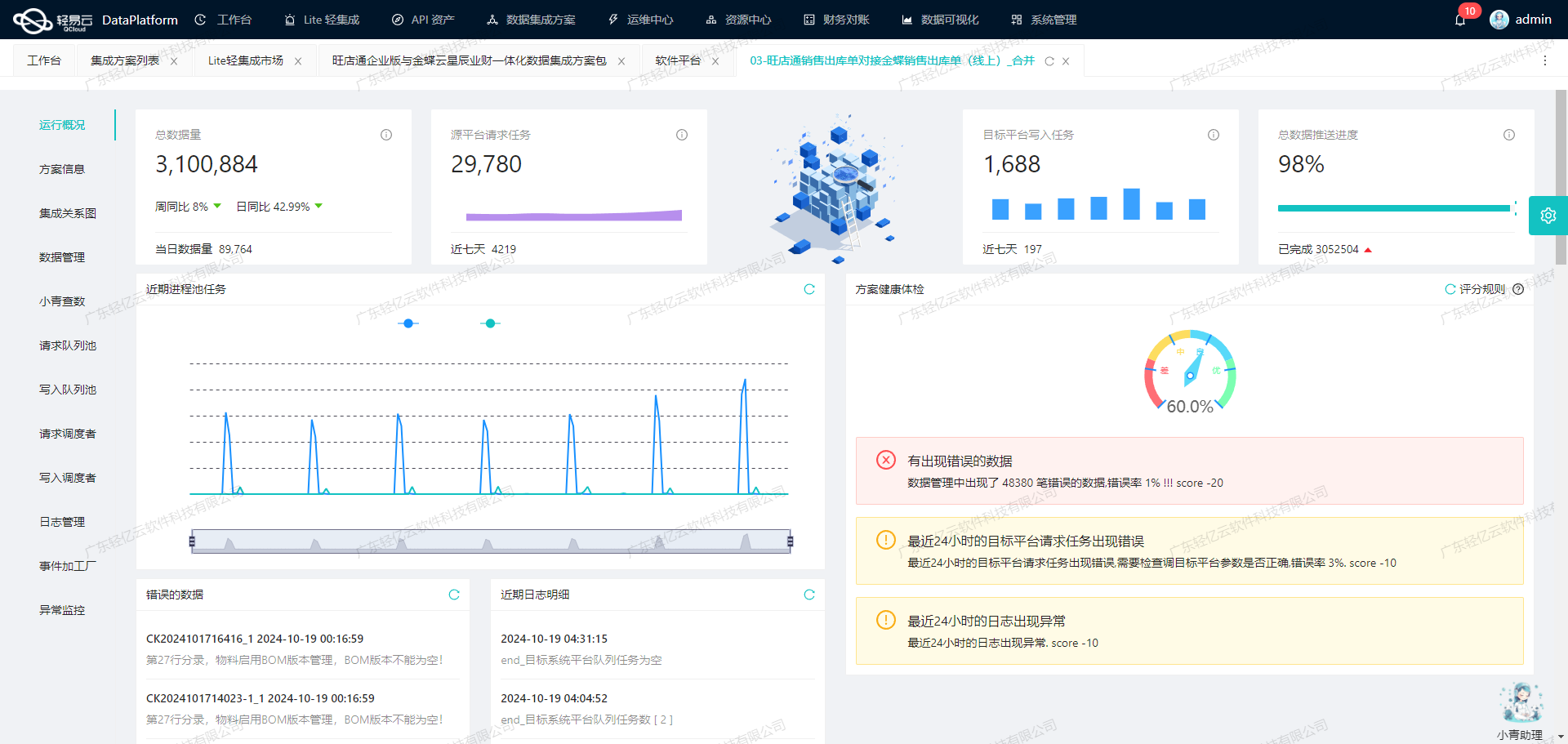

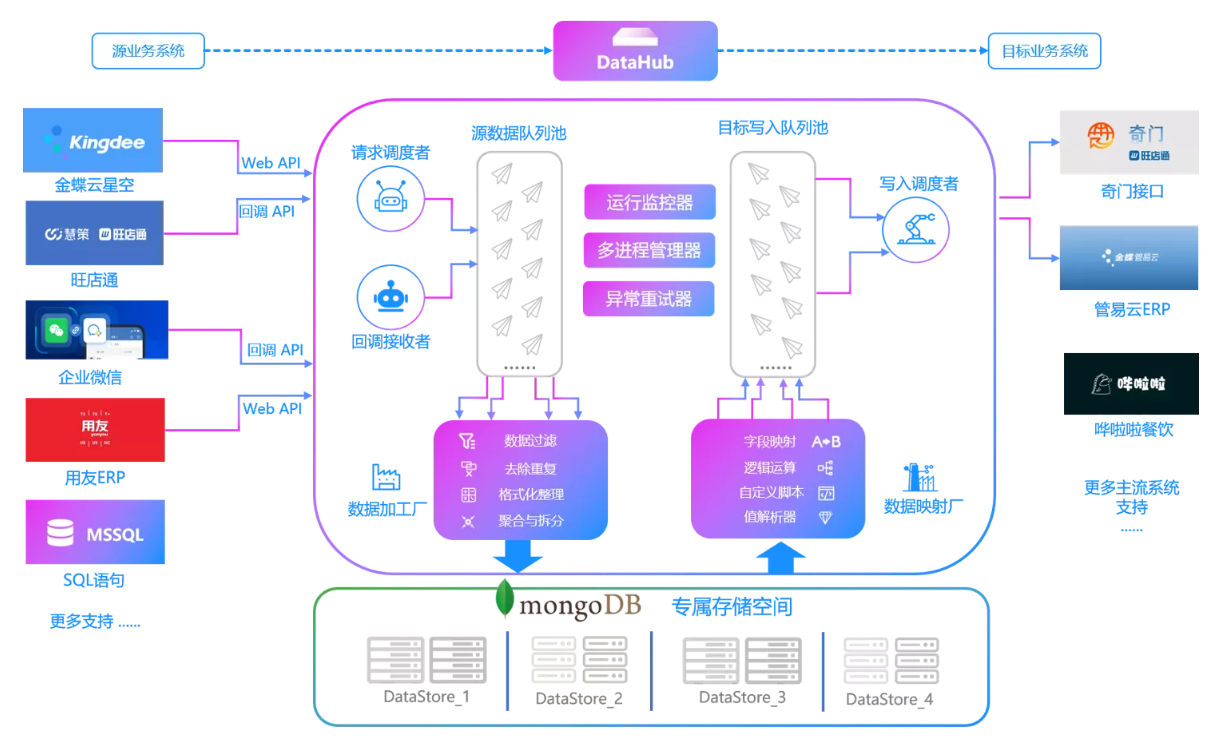

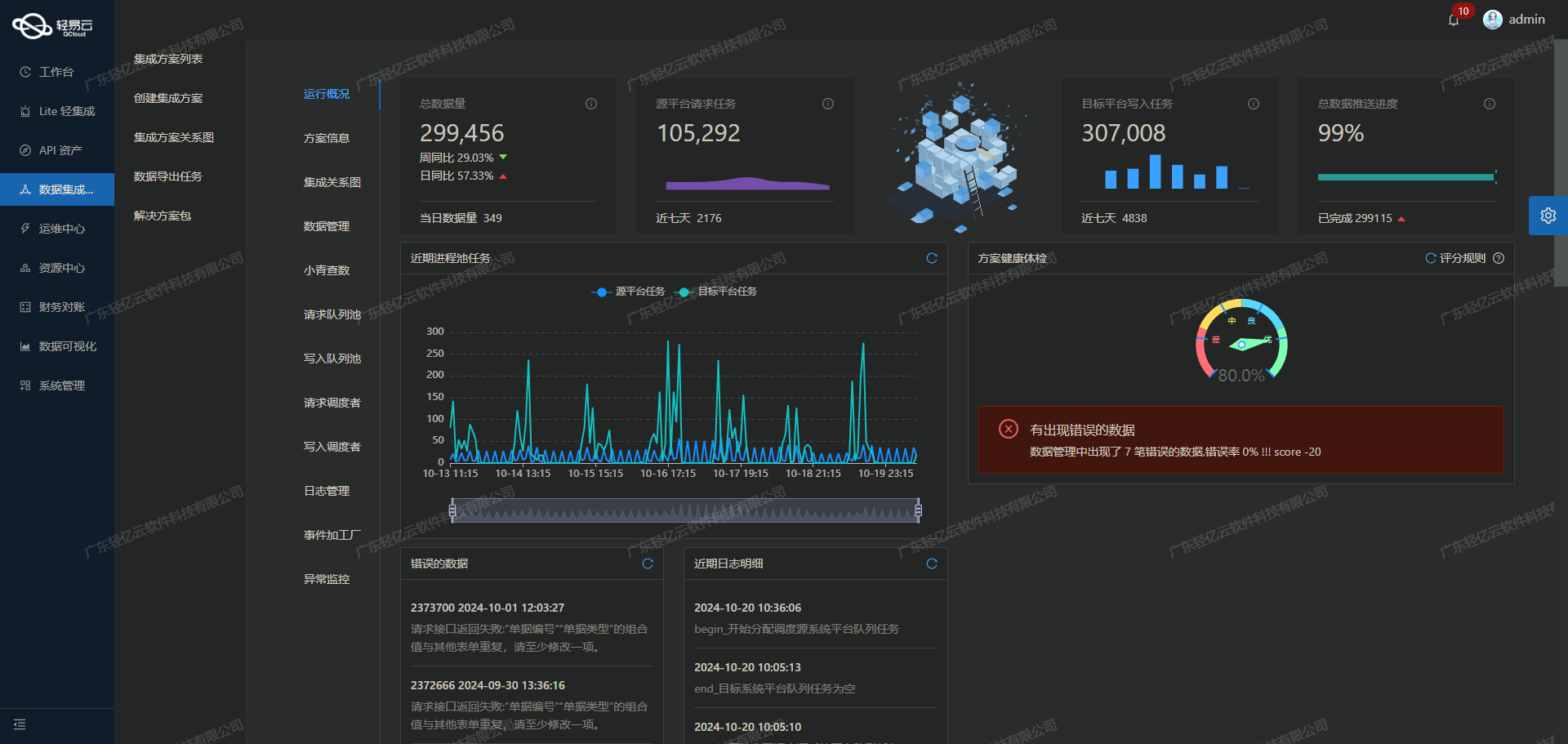

首先,我们需要明确的是,通过轻易云数据集成平台,可以实现对钉钉数据的高效抓取和可靠写入。该平台提供了强大的高吞吐量数据写入能力,使得大量数据能够快速被集成到SQL Server中,从而大幅提升了数据处理的时效性。

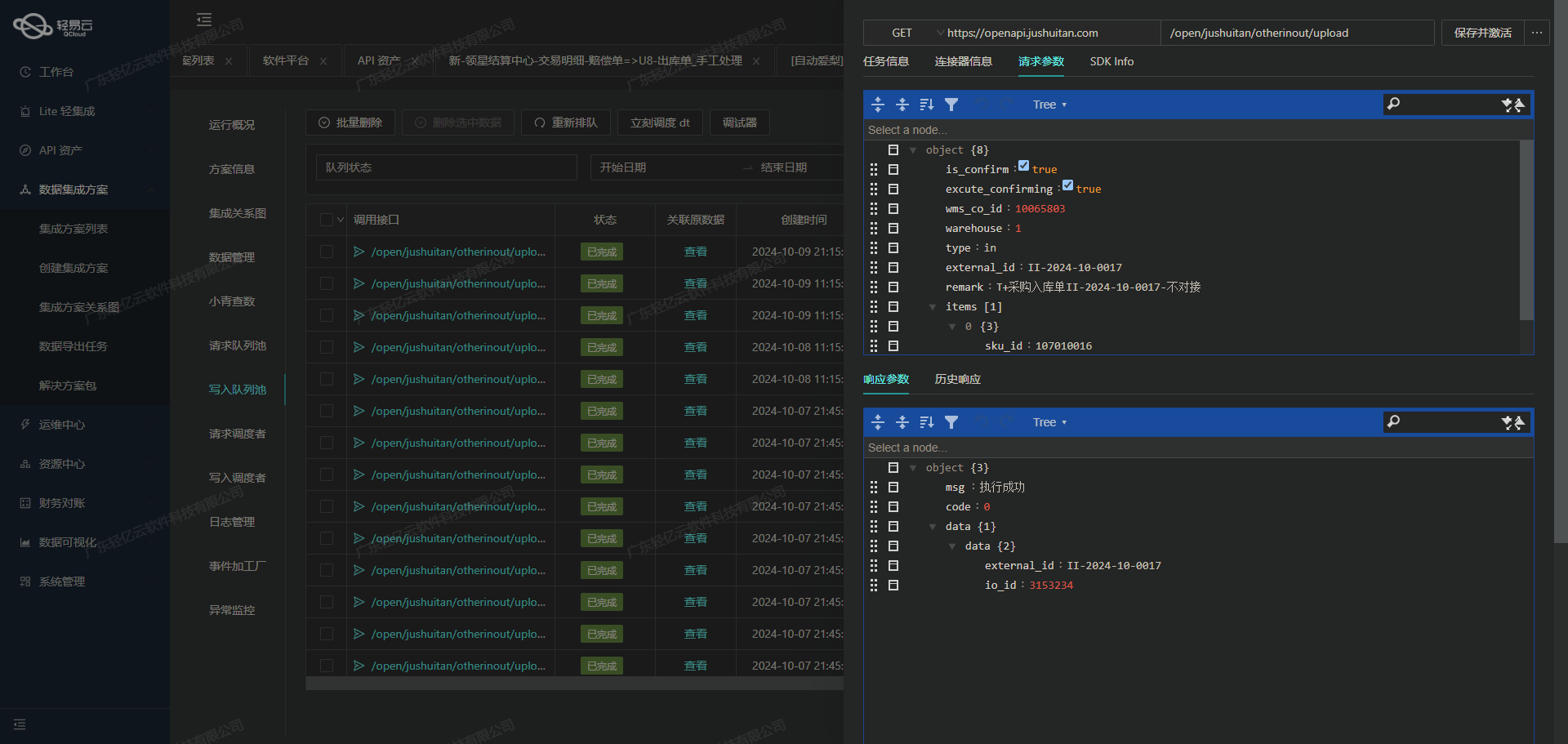

在本次集成过程中,我们主要使用了钉钉API接口topapi/processinstance/get来获取所需的数据,并通过SQL Server的API接口exec进行数据写入。在这个过程中,确保每一条数据不漏单是至关重要的。因此,我们利用轻易云平台提供的数据质量监控和异常检测功能,及时发现并处理任何可能出现的数据问题。

此外,为了应对钉钉接口的分页和限流问题,我们设计了一套定时可靠的抓取机制。这不仅保证了数据获取过程中的稳定性,还有效避免了因接口调用频率过高而导致的限流情况。同时,通过自定义的数据转换逻辑,我们能够灵活适应特定业务需求和不同的数据结构,实现精准的数据映射对接。

在实际操作中,实时监控与日志记录也是不可或缺的一部分。轻易云平台提供集中监控和告警系统,使我们可以实时跟踪整个数据集成任务的状态和性能。一旦出现异常情况,系统会立即发出告警通知,以便我们迅速采取措施进行处理。

总之,通过合理利用轻易云平台提供的一系列功能,本次1122131方案成功实现了从钉钉到SQL Server的数据无缝对接。接下来,将详细介绍具体实施步骤及其背后的技术细节。

调用钉钉接口topapi/processinstance/get获取并加工数据

在轻易云数据集成平台中,调用钉钉接口topapi/processinstance/get是数据生命周期管理的第一步。该步骤主要涉及从钉钉系统中获取审批实例的数据,并对其进行初步加工处理。以下将详细探讨这一过程的技术细节。

API接口配置与调用

根据提供的元数据配置,我们需要通过POST请求调用topapi/processinstance/get接口。该接口用于查询审批实例,具体参数如下:

process_code: 审批流的唯一码,用于指定要查询的表单ID。start_time: 审批实例开始时间,Unix时间戳,单位毫秒。end_time: 审批实例结束时间,Unix时间戳,单位毫秒。size: 分页参数,每页大小,最多传20。cursor: 分页查询的游标,最开始传0,后续传返回参数中的next_cursor值。

这些参数确保了我们能够精确地控制查询范围和分页处理,从而高效地获取所需数据。

数据请求与清洗

在实际操作中,我们首先需要确定合适的时间范围,这通常通过设置start_time和end_time来实现。例如,可以使用上次同步时间(LAST_SYNC_TIME)和当前时间(CURRENT_TIME)来动态生成这些参数:

{

"start_time": "_function {LAST_SYNC_TIME}*1000",

"end_time": "_function {CURRENT_TIME}*1000"

}这种方式确保了每次调用都能获取到最新的数据,而不会重复或遗漏。

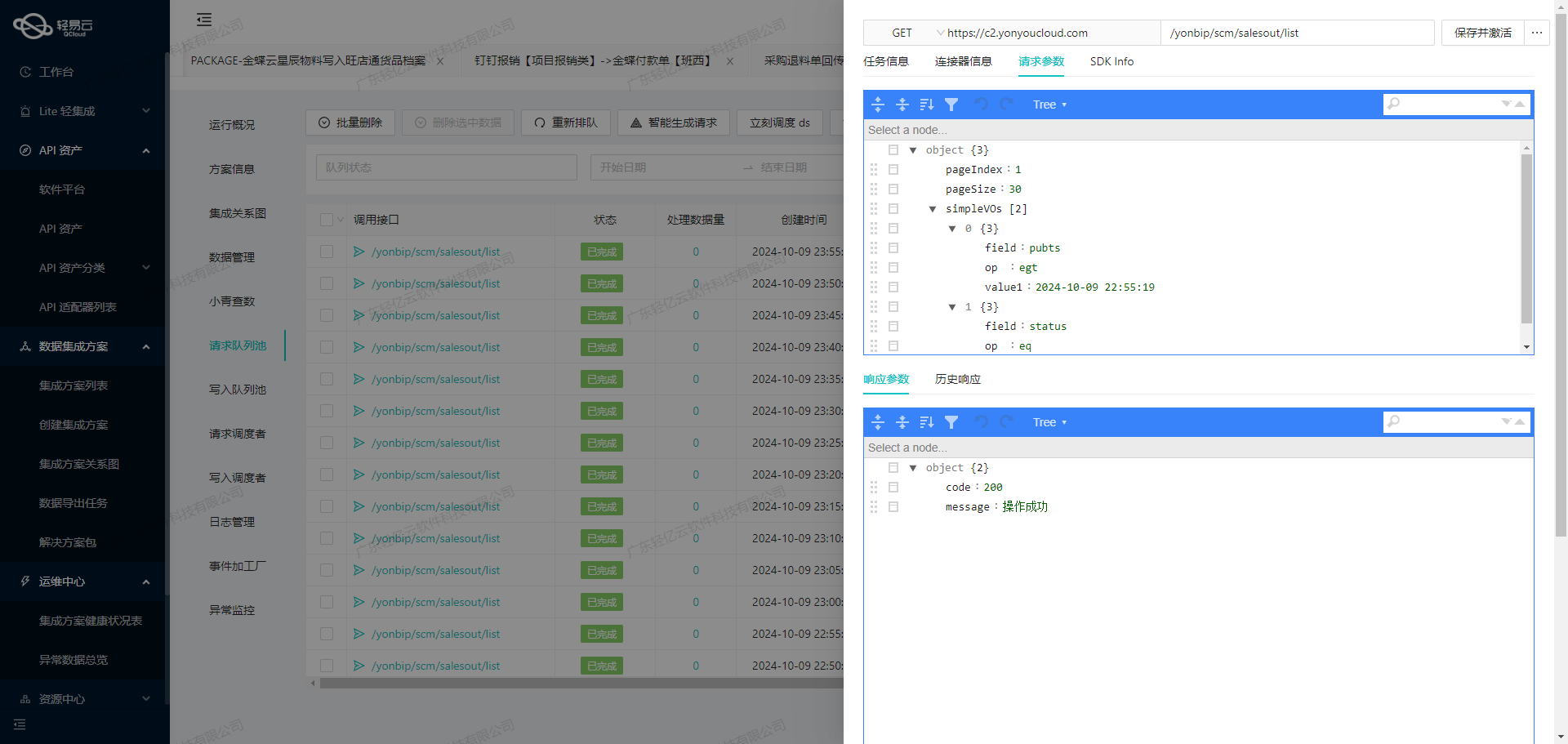

接下来,通过分页机制控制每次请求的数据量。设置合理的分页大小(如20),并使用游标(cursor)进行多次请求,以确保完整性:

{

"size": "20",

"cursor": "0"

}当返回结果包含大量记录时,通过检查返回值中的next_cursor字段判断是否需要继续请求下一页数据。这种方式有效避免了单次请求过大导致超时或失败的问题。

数据转换与写入

在成功获取到原始数据后,需要对其进行初步清洗和转换,以便后续处理。例如,将Unix时间戳转换为标准日期格式、过滤掉无关字段等。这些操作可以通过自定义脚本或内置函数实现。

对于特定业务需求,还可能需要进一步转换数据结构,使之符合目标系统(如SQL Server)的要求。例如,将JSON对象映射为数据库表中的列:

{

"field_mappings": {

"审批流ID": "process_code",

"开始时间": "start_time",

...

}

}这种映射关系可以通过轻易云平台提供的可视化工具直观地配置,大大简化了复杂的数据转换过程。

异常处理与重试机制

在调用API过程中,不可避免会遇到网络波动、限流等问题。因此,需要设计健壮的异常处理和重试机制。例如,当检测到API限流错误时,可以采用指数退避算法延迟重试;对于其他类型错误,则记录日志并通知相关人员及时处理。

此外,通过实时监控和告警系统,可以随时掌握任务执行状态,一旦出现异常立即响应。这种集中监控机制极大提升了整体系统的可靠性和稳定性。

数据质量监控与优化

为了保证集成数据的一致性和准确性,需要对整个流程进行严格的数据质量监控。例如,在每个步骤完成后,对比源数据与目标数据的一致性;定期检查日志记录中的异常情况,并根据分析结果优化流程配置。

总之,通过合理配置API接口、精细化控制请求参数、灵活应用分页机制以及完善的异常处理策略,可以高效、安全地完成从钉钉系统获取审批实例并进行初步加工,为后续的数据集成奠定坚实基础。

数据ETL转换与写入SQL Server的实现

在数据集成过程中,ETL(Extract, Transform, Load)是将数据从源系统提取、转换为目标格式并加载到目标系统的关键步骤。本文将重点探讨如何利用轻易云数据集成平台,将已经集成的源平台数据进行ETL转换,并转为SQL Server API接口所能够接收的格式,最终写入目标平台。

数据请求与清洗

在ETL流程中,首先需要从源平台提取数据并进行必要的清洗。这一步骤确保了数据的准确性和一致性,为后续的数据转换打下基础。轻易云数据集成平台提供了强大的数据请求功能,可以通过调用钉钉接口topapi/processinstance/get来获取所需的数据,并进行初步清洗和过滤。

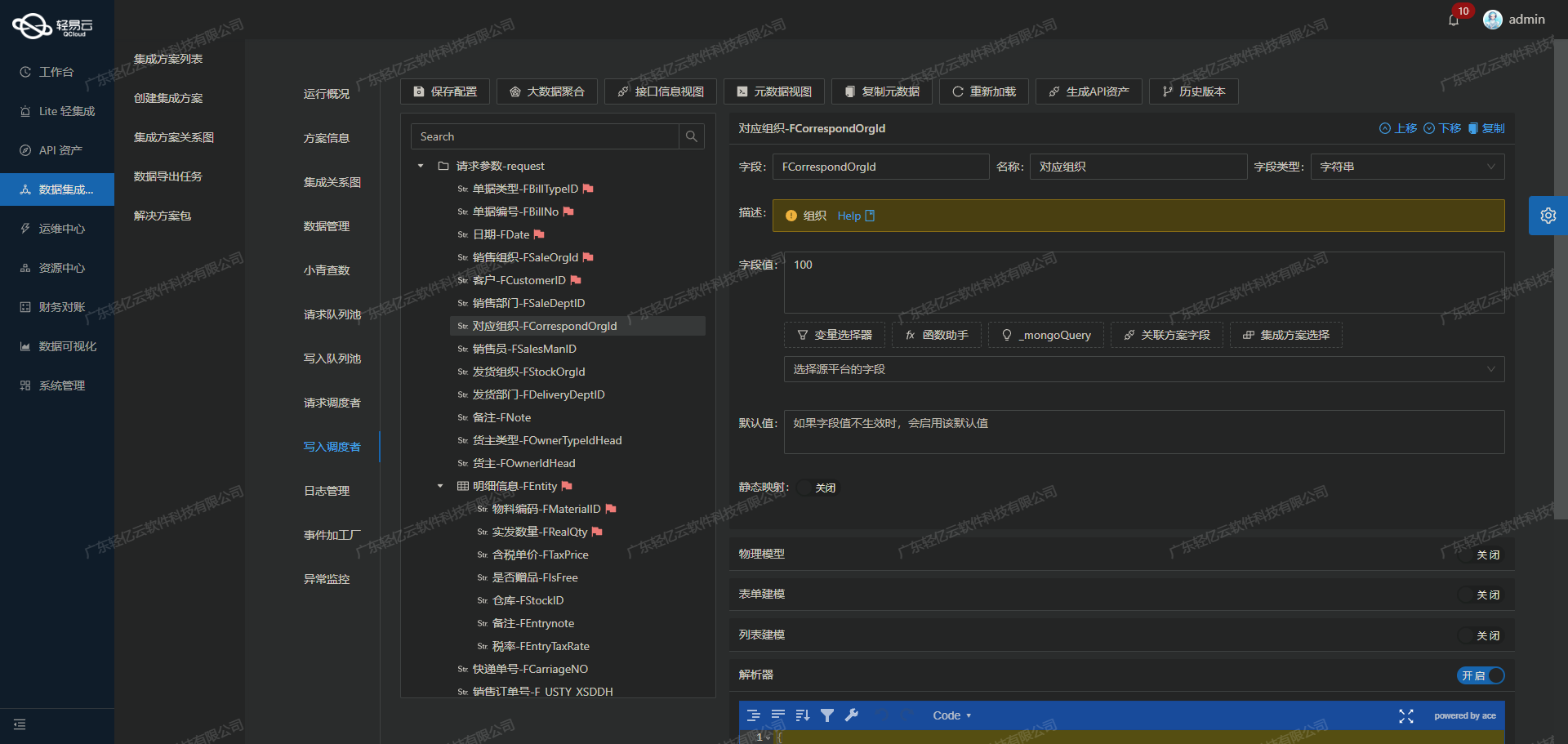

数据转换与映射

一旦数据被成功提取并清洗完毕,接下来就是将这些数据转换为SQL Server API接口能够接受的格式。这里我们将详细介绍如何利用轻易云平台提供的元数据配置,实现这一过程。

主参数配置

{

"field": "main_params",

"label": "主参数",

"type": "object",

"children": [

{"field": "Date", "label": "日期", "type": "string", "value": "_function DATE_FORMAT('{{extend.finish_time}}', '%Y-%m-%d')"},

{"field": "Year", "label": "年度", "type": "int", "value": "_function YEAR('{{extend.finish_time}}')"},

{"field": "period", "label": "期间", "type": "int", "value": "_function MONTH('{{extend.finish_time}}')"},

{"field": "Group", "label": "凭证字", "type": "string", "value":"记"},

{"field":"Amount","label":"凭证总金额","type":"string","value":"{{金额(元)}}"}

]

}上述配置中,通过定义主参数字段,将源数据中的日期、年度、期间等信息,经过格式化函数转换后映射到SQL Server所需的字段中。这些映射关系确保了源数据能够正确转换为目标系统所需的格式。

扩展参数配置

{

"field":"extend_params_1",

"label":"1:1扩展参数",

...

}扩展参数部分则定义了更详细的数据字段,包括借方和贷方的数据明细。通过对每个字段进行精确映射,确保所有财务数据都能正确传递到SQL Server中。

数据写入SQL Server

在完成所有必要的数据转换之后,最后一步是将这些处理好的数据写入到SQL Server中。轻易云平台支持高吞吐量的数据写入能力,使得大量数据能够快速被集成到SQL Server中。

主语句执行

{

"field":"main_sql",

...

}主语句exec sp_AddVoucher :Date,:Year,:period,:Group,:entryCount,:Amount,:Note,:BillUser,:detailNumbers用于插入主要财务凭证信息,这一语句通过调用存储过程,将前面定义好的主参数依次传递给SQL Server执行。

扩展语句执行

{

...

}扩展语句exec sp_AddVoucherEntry :lastInsertId,:FEntryID,:FNote,:AccountNumber,:AccountNumber1,...则用于插入财务分录明细信息,每个字段都对应前面定义好的扩展参数,确保所有明细信息都能正确写入。

实现高效与可靠性

为了保证整个ETL过程的高效与可靠性,轻易云平台提供了集中监控和告警系统,可以实时跟踪每个数据集成任务的状态和性能。一旦发现异常情况,可以及时处理,确保数据集成过程不间断。此外,通过自定义数据转换逻辑,可以灵活适应不同业务需求和复杂的数据结构。

总结

通过上述步骤,我们实现了从源平台提取、清洗、转换并最终写入SQL Server的数据集成流程。通过精确的元数据配置和高效的数据处理能力,确保了整个流程的顺利进行,为企业提供了可靠的数据对接方案。