吉客云·奇门数据集成到MySQL技术案例分享

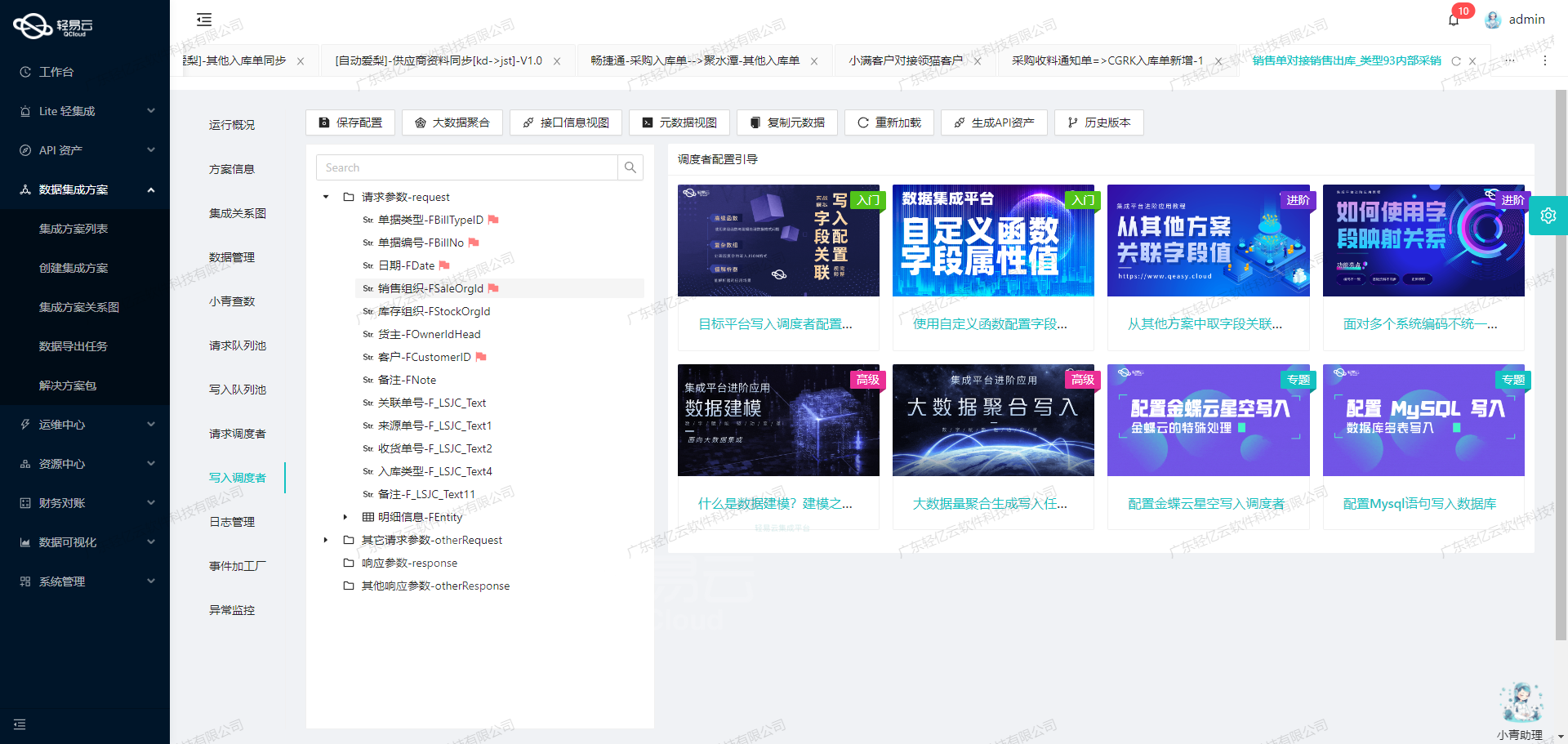

在现代业务环境中,高效的数据集成和处理是确保企业运营顺畅的关键因素。本文将着重探讨如何通过轻易云数据集成平台,实现吉客云·奇门系统与MySQL数据库之间的无缝对接,以及具体运行方案“BDS对账系统-查询吉客云退换货单(有退有发,发货)回写”的详细过程。

此次集成任务主要包括以下几个关键步骤:

- 调用吉客云·奇门API接口:使用

jackyun.tradenotsensitiveinfos.list.get获取实时的订单信息,这些信息涵盖了退换货单以及相关的发货记录。 - 数据质量监控和转换:针对提取的数据进行质量监控,利用自定义转换逻辑适应特定业务需求,确保每条订单数据准确无误地映射到MySQL对应字段。

- 批量写入MySQL:优化高吞吐量的数据写入能力,通过批量操作快速将大规模数据载入MySQL,提高整体处理时效性。

- 异常检测与错误重试机制:设计可靠的异常检测机制,处理诸如分页限流、网络超时等问题,并实现自动重试功能以保证任务稳定执行。

整个流程都在一个集中式的平台上完成,其中包括高级可视化工具辅助下设计清晰的数据流路线,并提供全面监控和告警系统来跟踪各环节状态,从而减少人工干预,使得整个解决方案高效且可靠。

使用轻易云数据集成平台调用吉客云·奇门接口获取并加工数据

在数据集成的生命周期中,第一步是调用源系统接口获取数据。本文将深入探讨如何使用轻易云数据集成平台调用吉客云·奇门接口jackyun.tradenotsensitiveinfos.list.get,并对获取的数据进行初步加工。

接口调用配置

吉客云·奇门接口jackyun.tradenotsensitiveinfos.list.get是一个POST请求,用于查询销售单的非敏感信息。以下是该接口的主要配置参数:

- api:

jackyun.tradenotsensitiveinfos.list.get - method:

POST - number:

tradeNo - id:

tradeId - name:

tradeNo - idCheck:

true

请求参数包括但不限于以下字段:

- modified_begin 和 modified_end:修改时间的起始和结束时间,必须同时存在,时间间隔不能超过七天。

- startModified 和 endModified:最后修改时间的起始和截止。

- tradeNo:销售单号,多个用半角逗号分隔。

- pageSize:每页记录数,默认50,最大1000。

- pageIndex:页码,0为第1页。

- hasTotal:首次调用时可以传1获取总记录数。

- startCreated 和 endCreated:创建时间的起始和截止。

- startAuditTime 和 endAuditTime:审核时间的起始和截止。

- startConsignTime 和 endConsignTime:发货时间的起始和截止,默认值分别为

from_unixtime(({LAST_SYNC_TIME}-86400),'%Y-%m-%d %H:%i:%s')和from_unixtime(({CURRENT_TIME}-86400),'%Y-%m-%d %H:%i:%s')。 - tradeStatus:订单状态,默认值为

6000,9090。 - tradeType:订单类型,默认值为

92。 - sourceTradeNos:网店订单号。

- fields:需要返回字段列表逗号分隔。

请求参数示例

为了实现对账系统查询退换货单(有退有发,发货)并回写,我们需要设置具体的请求参数。以下是一个示例配置:

{

"modified_begin": "2023-01-01 00:00:00",

"modified_end": "2023-01-07 23:59:59",

"pageSize": "100",

"pageIndex": "0",

"hasTotal": "1",

"startConsignTime": "_function from_unixtime(({LAST_SYNC_TIME}-86400),'%Y-%m-%d %H:%i:%s')",

"endConsignTime": "_function from_unixtime(({CURRENT_TIME}-86400),'%Y-%m-%d %H:%i:%s')",

"tradeStatus": "6000,9090",

"tradeType": "92"

}数据处理与清洗

在获取到原始数据后,需要对数据进行清洗和初步加工。轻易云平台提供了自动填充响应(autoFillResponse)的功能,可以根据预设条件自动处理响应数据。

例如,我们可以根据订单状态(tradeStatus)过滤出特定状态的订单,并对其进行进一步处理。以下是一个简单的数据处理逻辑示例:

{

"condition_bk": [

[

{

"field": "tradeStatus",

"logic": "in",

"value": "6000,9090"

}

]

],

"condition": [

[

{

"field": "tradeStatus",

"logic": "in",

"value": "6000,9090"

}

]

]

}数据转换与写入

在完成数据清洗后,需要将数据转换为目标系统所需的格式,并写入目标系统。这一步通常涉及到字段映射、格式转换等操作。在轻易云平台上,可以通过可视化界面方便地完成这些操作。

例如,将吉客云返回的数据字段映射到BDS对账系统所需的字段,并进行格式转换:

{

// 映射规则示例

// 吉客云字段 -> BDS字段

"sourceField1": {

"targetField1": "$.sourceField1"

},

...

}通过上述步骤,我们可以高效地实现从吉客云·奇门接口获取数据、清洗加工并写入目标系统的全过程。这不仅提高了数据处理效率,还确保了业务流程的透明性和可追溯性。

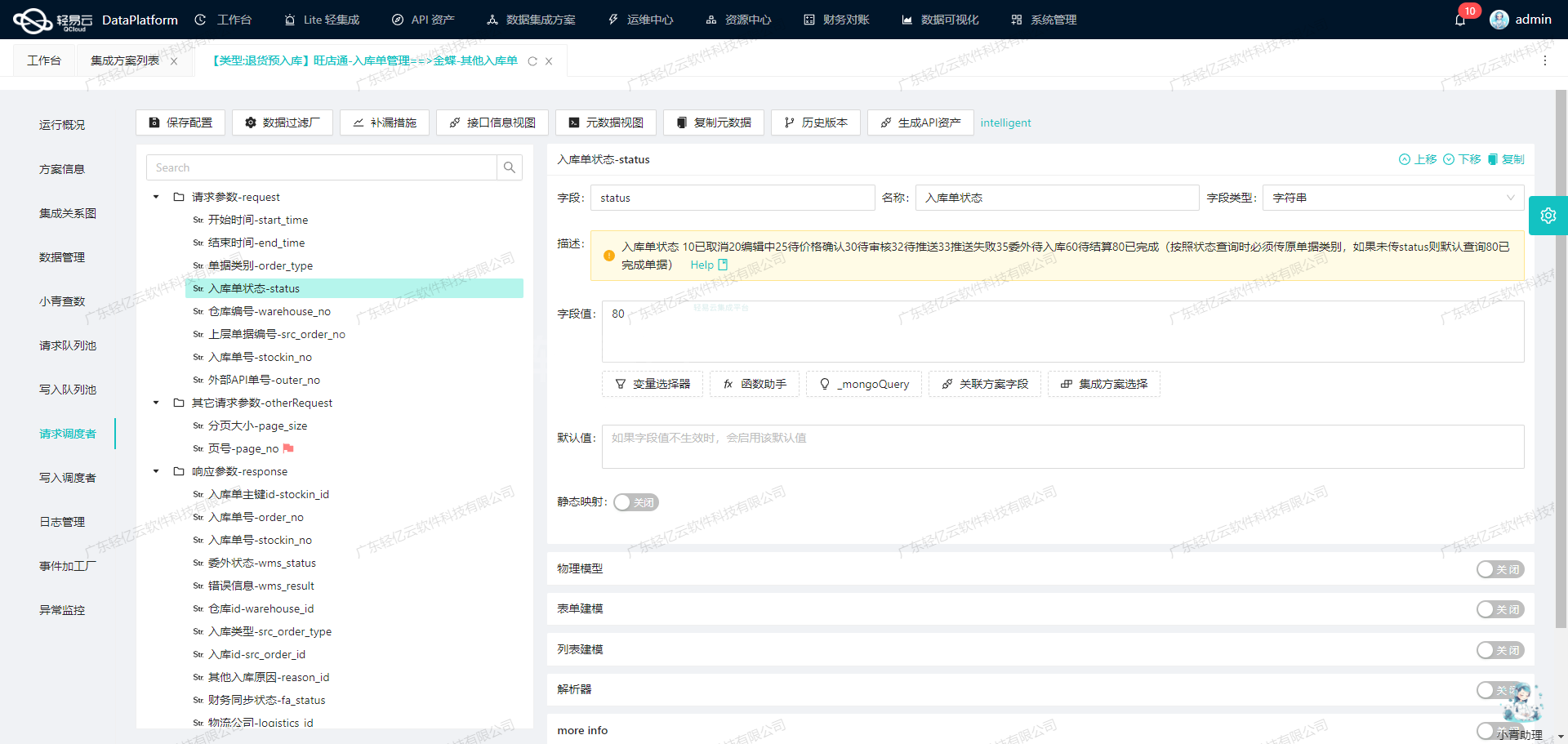

使用轻易云数据集成平台进行ETL转换并写入MySQLAPI接口

在数据集成生命周期的第二步,我们需要将已经集成的源平台数据进行ETL(提取、转换、加载)转换,最终写入目标平台MySQL。本文将详细探讨如何通过轻易云数据集成平台实现这一过程,特别是如何配置和使用元数据来完成这一任务。

配置元数据

在本案例中,我们需要将BDS对账系统中的退换货单数据,通过ETL转换后写入MySQL数据库。以下是我们需要配置的元数据:

{

"api": "update",

"effect": "EXECUTE",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "main_params",

"label": "主参数",

"type": "object",

"children": [

{"field": "send_logistic_name", "label": "发货物流公司", "type": "string", "value": "{logisticName}"},

{"field": "send_main_post_id", "label": "发货物流单号", "type": "string", "value": "{mainPostid}"},

{"field": "consign_time", "label": "发货时间", "type": "datetime", "value": "{consignTime}"},

{"field": "source_after_no", "label": "售后来源单号", "type": "string", "value": "{sourceAfterNo}"},

{"field": "send_warehouse_code", "label": "发货仓库编码", "type":"string","value":"{warehouseCode}"},

{"field":"send_warehouse_name","label":"发货仓库名称","type":"string","value":"{warehouseName}"}

]

}

],

``otherRequest``: [

{

``field``: ``main_sql``,

``label``: ``主语句``,

``type``: ``string``,

``value``: ``UPDATE `lhhy_srm`.`supplier_return_change` SET `send_logistic_name` = <{send_logistic_name: }>,`send_main_post_id` = <{send_main_post_id: }>,`consign_time` = <{consign_time: }> ,`send_warehouse_code` = <{send_warehouse_code: }>,`send_warehouse_name` = <{send_warehouse_name: }> WHERE `bill_no` = <{source_after_no:}>;`

}

],

``buildModel``: true

}数据请求与清洗

在ETL过程中,首先要从源平台提取数据并进行清洗。清洗步骤包括去除冗余信息、修正错误数据和标准化字段格式。在这个案例中,我们假设已经完成了这些步骤,并且得到了如下清洗后的数据:

{

logisticName: '顺丰快递',

mainPostid: 'SF123456789',

consignTime: '2023-10-01T10:00:00Z',

sourceAfterNo: 'RET20231001',

warehouseCode: 'WH001',

warehouseName: '上海仓库'

}数据转换与写入

接下来,我们需要根据上述元数据配置,将清洗后的数据转换为目标格式,并通过API接口写入MySQL数据库。

-

构建请求参数: 根据元数据中的配置,我们构建出如下请求参数:

{ main_params: { send_logistic_name: '顺丰快递', send_main_post_id: 'SF123456789', consign_time: '2023-10-01T10:00:00Z', source_after_no: 'RET20231001', send_warehouse_code: 'WH001', send_warehouse_name: '上海仓库' } } -

生成SQL语句: 根据元数据中的SQL模板,生成具体的SQL语句:

UPDATE `lhhy_srm`.`supplier_return_change` SET `send_logistic_name` = '顺丰快递', `send_main_post_id` = 'SF123456789', `consign_time` = '2023-10-01T10:00:00Z', `send_warehouse_code` = 'WH001', `send_warehouse_name` = '上海仓库' WHERE `bill_no` = 'RET20231001'; -

执行API调用: 最后,通过POST方法调用API接口,将生成的SQL语句发送到目标MySQL数据库执行。

POST /update HTTP/1.1 Host: api.targetplatform.com Content-Type: application/json { sql_statement : " UPDATE `lhhy_srm`.`supplier_return_change` SET `send_logistic_name` = '顺丰快递', `send_main_post_id` = 'SF123456789', `consign_time` = '2023-10-01T10:00:00Z', `send_warehouse_code` = 'WH001', `send_warehouse_name` = '上海仓库' WHERE `bill_no` = 'RET20231001'; " }

实时监控与验证

在执行完上述操作后,轻易云平台会实时监控整个过程,并提供详细的日志记录和状态报告,以确保每一步都执行成功。如果出现任何错误,可以根据日志信息进行排查和修正。

通过以上步骤,我们成功地将BDS对账系统中的退换货单信息,通过ETL转换后写入了目标MySQL数据库,实现了不同系统间的数据无缝对接。这一过程不仅提高了业务效率,也确保了数据处理的透明性和准确性。