道一云数据集成到畅捷通T+的技术案例分享:报销服务费(天水)

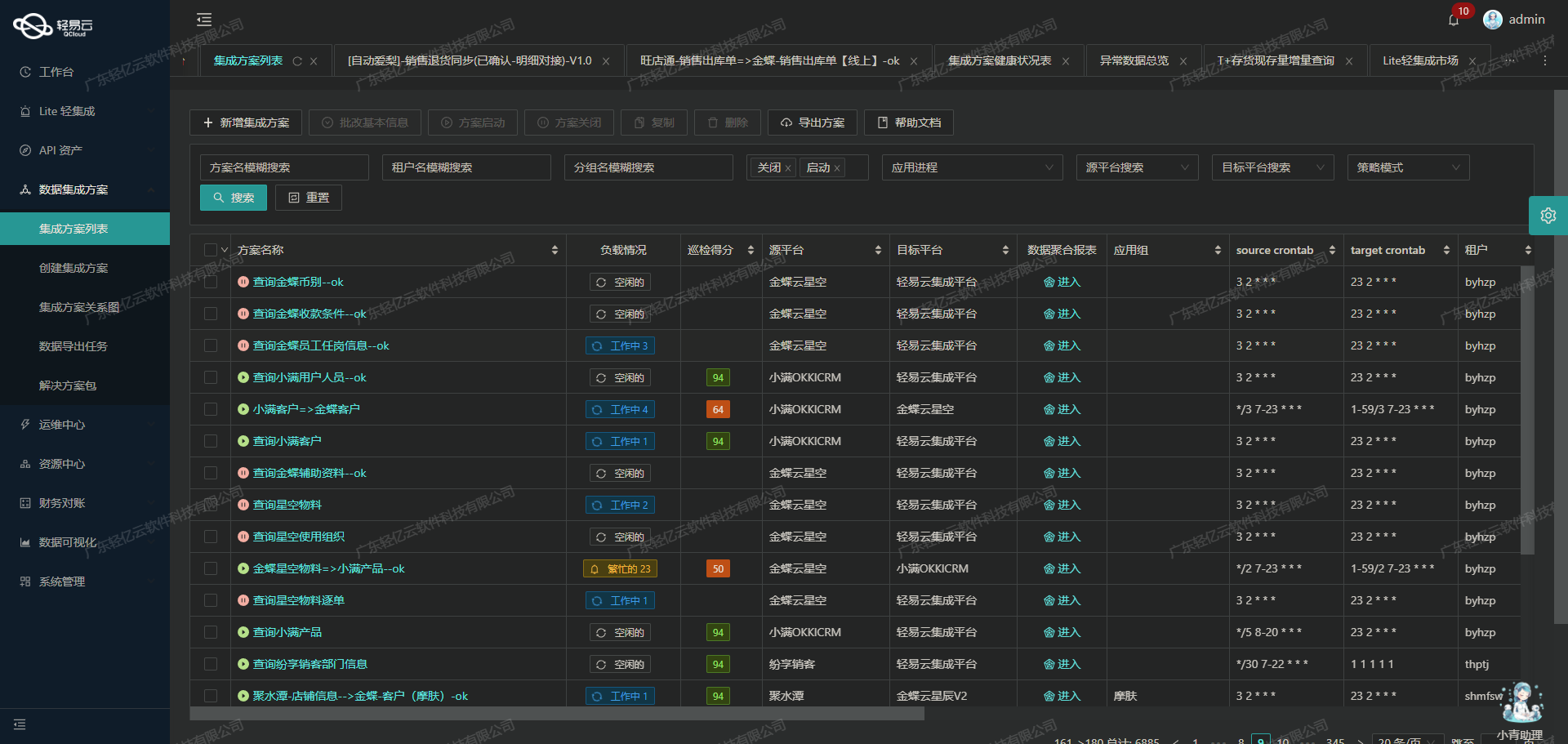

在企业信息化建设中,数据集成是实现业务流程自动化和优化的重要环节。本案例将聚焦于道一云与畅捷通T+之间的数据对接,通过具体的技术方案“报销服务费(天水)”来展示如何高效、可靠地完成这一任务。

首先,我们需要从道一云获取报销服务费相关的数据。道一云提供了丰富的API接口,其中qwcgi/api/reimApiCtl/getReimList.do是我们此次集成的关键接口。为了确保数据不漏单,我们采用定时可靠的抓取机制,实时监控接口调用状态,并处理分页和限流问题,以保证数据完整性和准确性。

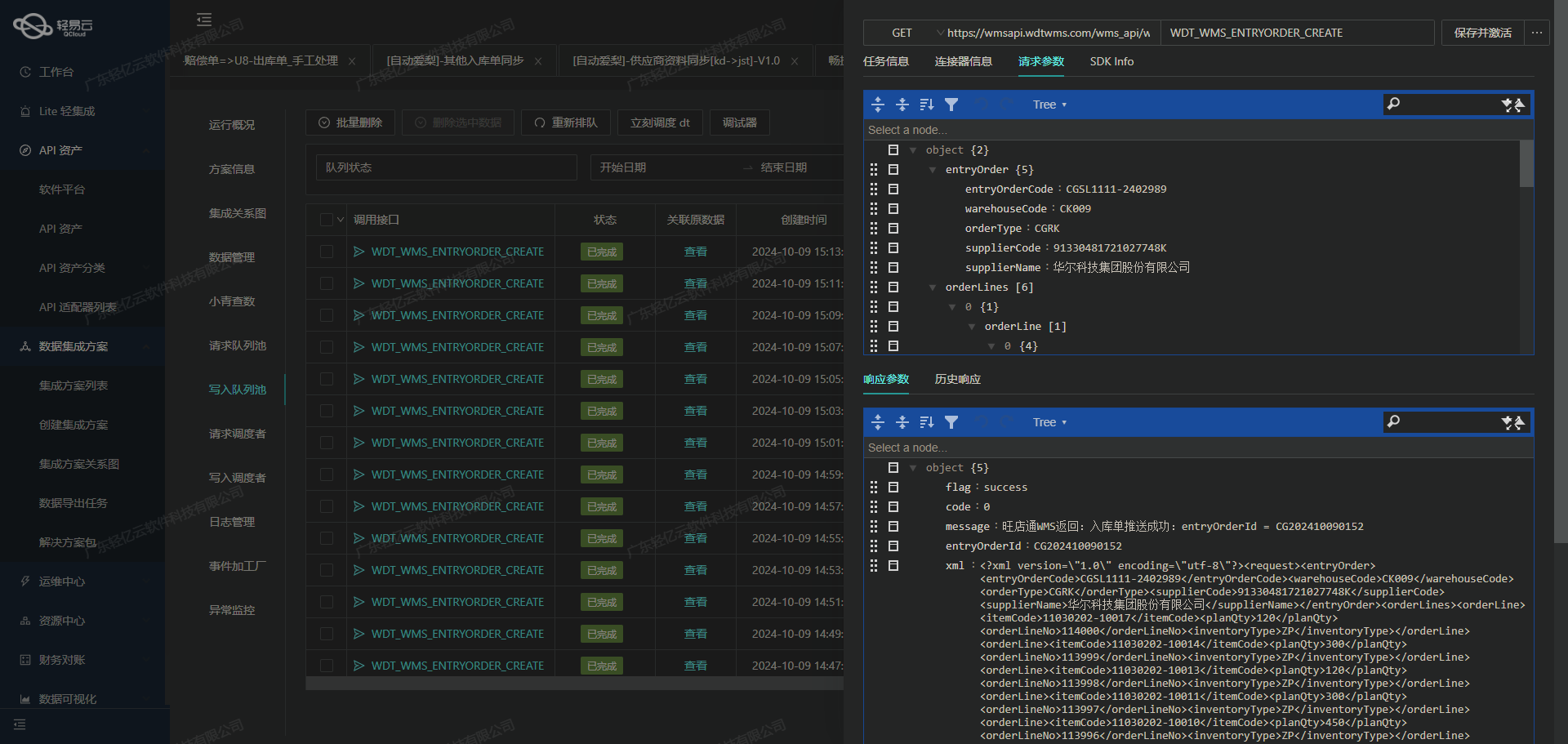

在获取到所需数据后,下一步是将这些数据批量写入到畅捷通T+系统中。畅捷通T+提供了强大的API支持,其中/tplus/api/v2/doc/Create用于创建新的文档记录。通过高吞吐量的数据写入能力,我们能够快速、高效地将大量数据导入到目标系统中,极大提升了数据处理的时效性。

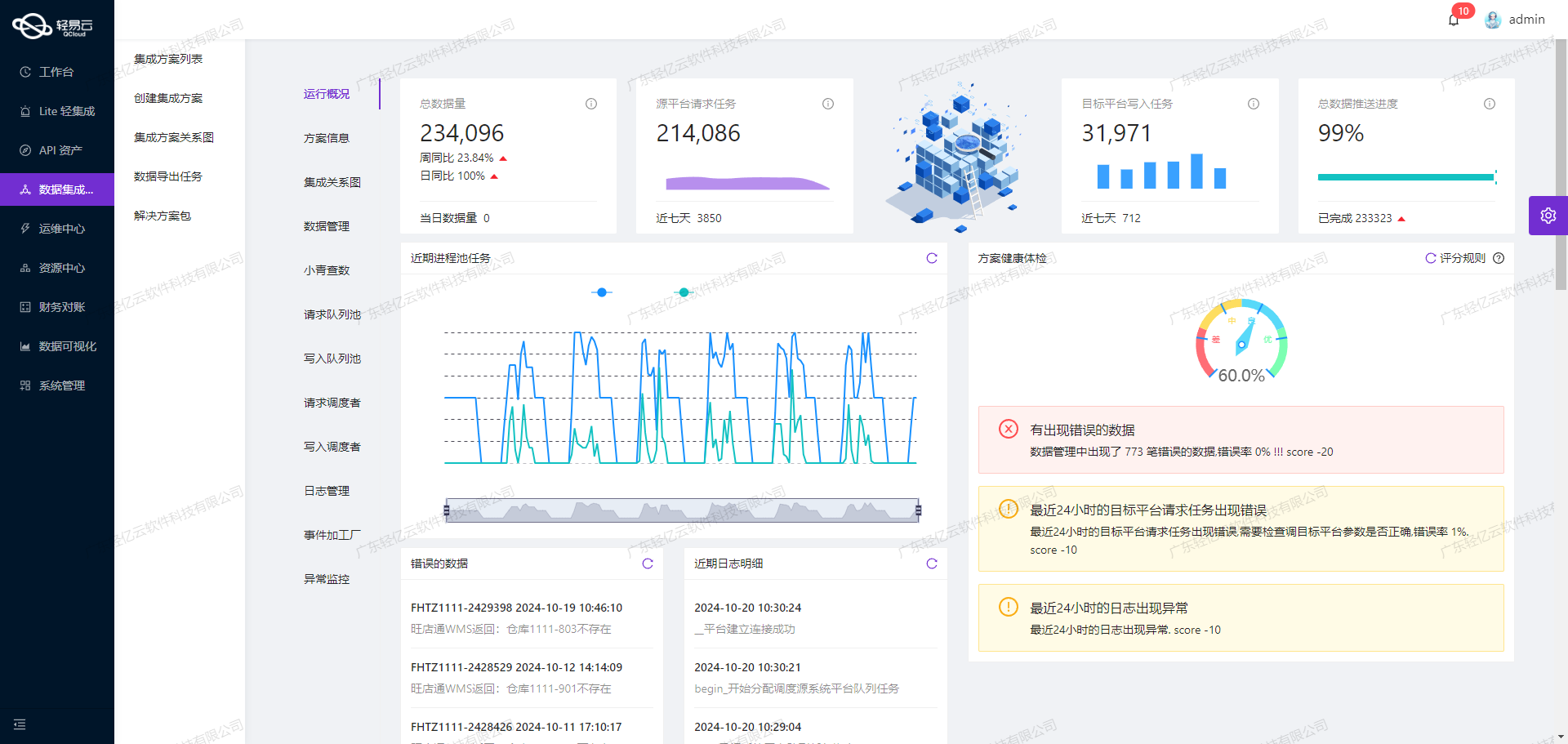

为了应对两者之间的数据格式差异,我们利用自定义数据转换逻辑,对道一云的数据进行必要的转换和映射,使其符合畅捷通T+的要求。同时,为了确保整个集成过程透明可控,我们使用集中监控和告警系统,实时跟踪每个任务的状态和性能,一旦发现异常情况,可以及时处理并重试,从而保证系统稳定运行。

本次集成方案不仅实现了道一云与畅捷通T+之间的数据无缝对接,还通过可视化的数据流设计工具,使得整个过程更加直观易于管理。这些技术手段共同保障了“报销服务费(天水)”方案的顺利实施,为企业带来了显著的效率提升和资源优化。

调用道一云接口qwcgi/api/reimApiCtl/getReimList.do获取并加工数据

在轻易云数据集成平台的生命周期中,第一步是调用源系统道一云接口qwcgi/api/reimApiCtl/getReimList.do来获取数据,并对其进行初步加工处理。本文将详细探讨如何配置和使用该接口,以确保数据的准确性和完整性。

接口配置与调用

首先,我们需要配置API接口的元数据。根据提供的metadata,可以看到该接口采用POST方法,通过传递特定参数来获取报销服务费相关的数据。

{

"api": "qwcgi/api/reimApiCtl/getReimList.do",

"method": "POST",

"number": "reimNo",

"id": "reimNo",

"idCheck": true,

...

}在实际调用过程中,需要特别注意以下几个关键参数:

startTime和endTime: 用于指定查询时间范围。currentPage和pageSize: 用于分页控制,确保每次请求的数据量适中。dataKey: 指定返回数据包的键名。

这些参数可以通过动态变量(如{{LAST_SYNC_TIME|datetime}}和{{CURRENT_TIME|datetime}})来实现自动化配置,确保每次请求都能获取最新的数据。

数据过滤与条件设置

为了精准地获取所需数据,我们需要设置相应的过滤条件。在本案例中,我们关注的是“天水格瑞丽家母婴用品有限公司”的服务费报销记录,因此需要在请求中添加以下条件:

[

{

"field": "detailList.subjName",

"logic": "like",

"value": "服务"

},

{

"field": "detailList.reimCustomFieldDataList_0_value",

"logic": "like",

"value": "天水格瑞丽家母婴用品有限公司"

},

{

"field": "state",

"logic": ">=",

"value": 4

}

]这些条件确保了我们只提取符合业务需求的数据,从而提高了数据处理效率和准确性。

分页与限流处理

由于接口返回的数据量可能较大,为避免超时或性能问题,需要对请求进行分页处理。默认情况下,每页大小为100条记录,但不超过1000条。通过设置currentPage和pageSize参数,可以有效控制每次请求的数据量,并逐页获取所有符合条件的数据。

此外,还需考虑限流问题。如果道一云接口有访问频率限制,应在集成平台上实现重试机制和限流策略,以避免因频繁访问导致的封禁或其他异常情况。

异常处理与重试机制

在实际操作过程中,难免会遇到网络波动、服务器响应超时等异常情况。因此,需要设计健壮的异常处理机制。例如,当某次请求失败时,可以通过日志记录详细错误信息,并触发重试逻辑,以保证数据抓取过程不中断。同时,可结合轻易云平台提供的实时监控功能,及时发现并解决潜在问题,提高整体稳定性。

数据质量监控与自定义转换

为了确保集成到目标系统中的数据质量,需要对抓取到的数据进行严格监控和清洗。例如,可以通过自定义转换逻辑,将原始数据格式调整为目标系统所需格式,并对关键字段进行校验,剔除无效或重复记录。这一步骤不仅提升了数据的一致性,还为后续写入畅捷通T+系统奠定了基础。

综上所述,通过合理配置道一云接口、精确设置过滤条件、有效管理分页与限流、设计健壮的异常处理机制,以及实施严格的数据质量监控,我们能够高效、安全地完成轻易云数据集成平台生命周期中的第一步,为后续的数据转换与写入打下坚实基础。

集成平台生命周期的第二步:ETL转换与数据写入畅捷通T+

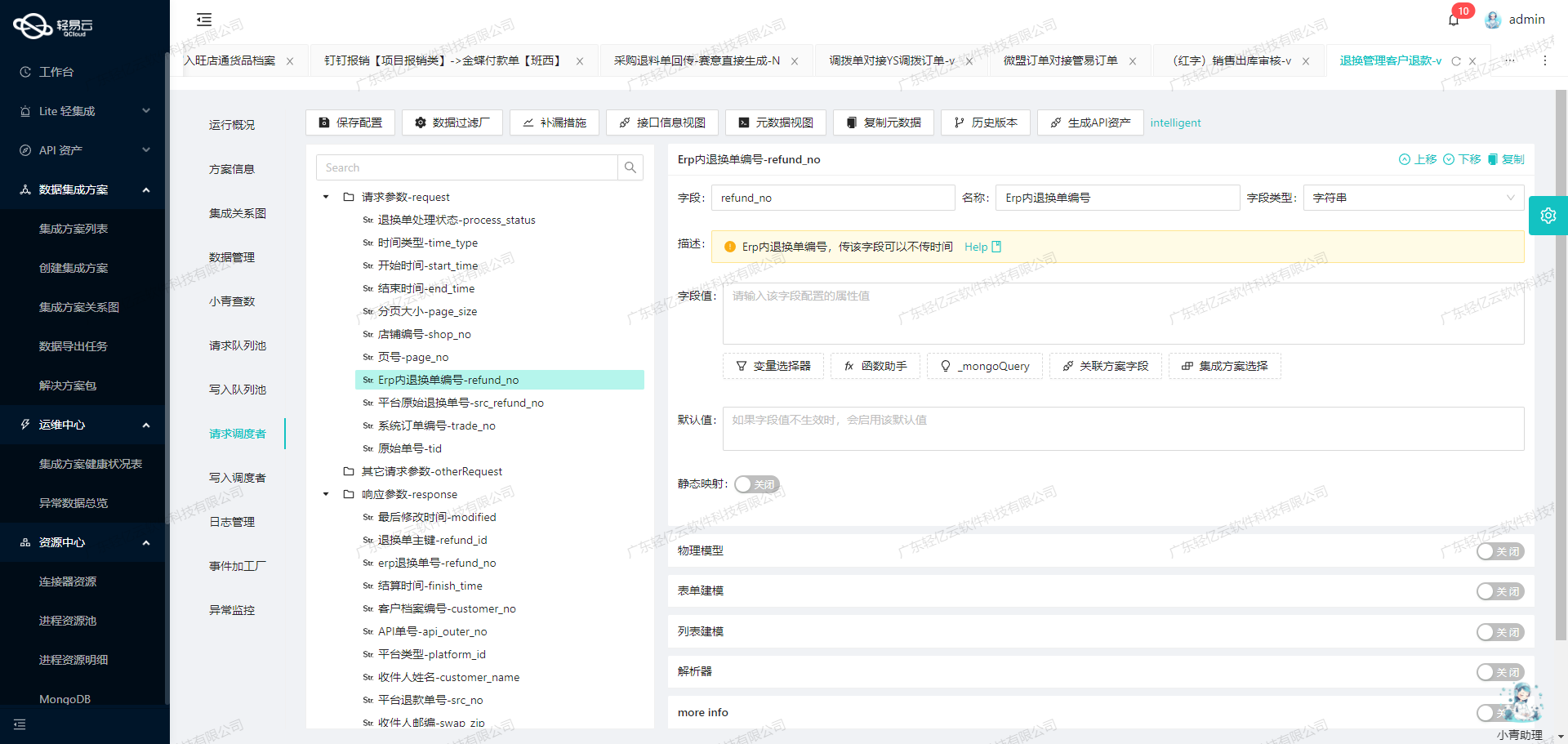

在数据集成过程中,ETL(提取、转换、加载)是一个关键步骤。本文将重点探讨如何将已经集成的源平台数据进行ETL转换,转为畅捷通T+API接口所能够接收的格式,并最终写入目标平台。

数据提取与清洗

首先,我们需要从源系统中提取相关的数据,并进行必要的数据清洗。这一过程包括对数据进行校验、去重和标准化处理,以确保数据的准确性和一致性。

数据转换

在完成数据清洗后,我们需要将数据转换为畅捷通T+API接口所能接收的格式。以下是一些关键字段及其转换逻辑:

-

外部编码 (ExternalCode):

{"field":"ExternalCode","label":"外部编码","type":"string","describe":"字符串长度<50","value":"{reimNo}{{detailList.subjName}}"}这里使用了

reimNo和subjName来生成唯一的外部编码,以确保每个凭证都有唯一标识。 -

凭证字 (DocType):

{"field":"DocType","label":"凭证字","type":"string","parser":{"name":"ConvertObjectParser","params":"Code"},"value":"记"}凭证字通常是固定值,这里直接设定为“记”。

-

制单日期 (VoucherDate):

{"field":"VoucherDate","label":"制单日期","type":"string","value":"{closeTime}"}使用

closeTime字段来指定制单日期。 -

借方摘要 (Summary-1):

{"field":"Summary-1","label":"借方摘要","type":"string","describe":"字符串长度<200","value":"{projName}{personName}报{endTimes}{subjFullName}"}借方摘要由多个字段组合而成,包括项目名称、人员名称、结束时间和科目全名。

-

借方科目档案 (Account-1):

{"field":"Account-1","label":"借方科目档案","type":"string","describe":"必须是末级科目","parser":{"name":"ConvertObjectParser","params":"Code"},"value":"_function case when '{{detailList.projName}}' in ('营运部','设计部','财务部','市场部','人资行政部') then '660217' else '660125' end"}根据项目名称动态选择科目档案,确保其为末级科目。

-

借方本币金额 (AmountDr-1):

{"field":"AmountDr-1","label":"借方本币金额","type":"string","value": "_function sum({{detailList.invoices.0.amount}}-{{detailList.invoices.0.taxAmount}})"}借方金额通过计算发票金额减去税额得出。

数据写入

在完成数据转换后,将转换后的数据通过畅捷通T+API接口写入目标平台。以下是API调用的一些关键配置:

{

"api": "/tplus/api/v2/doc/Create",

"method": "POST",

"idCheck": true,

"request": [

{

"field": "ExternalCode",

"label": "外部编码",

"type": "string",

"value": "{reimNo}{{detailList.subjName}}"

},

{

"field": "DocType",

"label": "凭证字",

"type": "string",

"parser": {

"name": "ConvertObjectParser",

"params": "Code"

},

"value": "记"

},

{

// Other fields...

}

]

}异常处理与重试机制

在调用API时,可能会遇到网络问题或接口限制等异常情况。为了保证数据写入的可靠性,需要实现异常处理与重试机制。例如:

import requests

from time import sleep

def call_api_with_retry(api_url, payload, max_retries=3):

retries = 0

while retries < max_retries:

try:

response = requests.post(api_url, json=payload)

if response.status_code == 200:

return response.json()

else:

raise Exception(f"API call failed with status code {response.status_code}")

except Exception as e:

retries += 1

print(f"Error: {e}, retrying {retries}/{max_retries}")

sleep(2)

raise Exception("Max retries exceeded")

# Example usage

api_url = "/tplus/api/v2/doc/Create"

payload = {...}

result = call_api_with_retry(api_url, payload)该示例展示了如何实现带有重试机制的API调用,在最大重试次数内,如果遇到异常则等待一段时间后重新尝试调用API。

数据质量监控

为了确保集成过程中的数据质量,可以启用实时监控和日志记录功能。在发现异常数据时,及时告警并采取相应措施。例如:

import logging

logging.basicConfig(level=logging.INFO)

def log_data_quality_issues(data):

if not data.get("ExternalCode"):

logging.warning("Missing ExternalCode")

# Other checks...

# Example usage

data = {...}

log_data_quality_issues(data)通过这种方式,可以及时发现并处理潜在的数据质量问题,确保集成过程顺利进行。

总结

通过上述步骤,我们实现了将已经集成的源平台数据进行ETL转换,并成功写入畅捷通T+目标平台。在整个过程中,重点关注了关键字段的转换逻辑、异常处理与重试机制以及数据质量监控等方面。