KIS-物料——>聚水潭-商品:高效数据集成方案分享

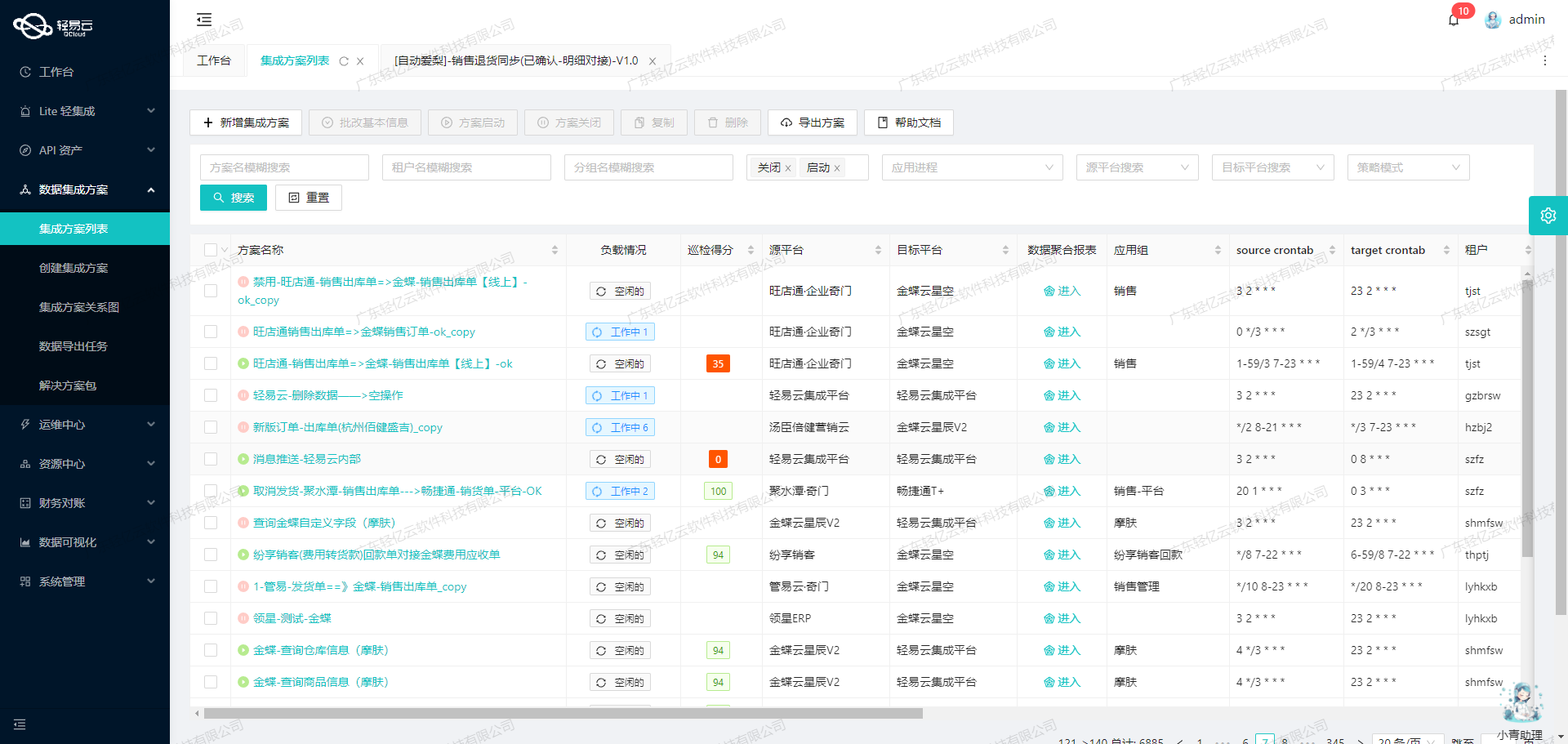

在企业信息化系统中,数据的高效流动和准确对接是确保业务顺畅运行的关键。本文将重点探讨如何通过轻易云数据集成平台,实现KIS私有云中的物料数据与聚水潭系统中的商品数据无缝对接。

背景概述

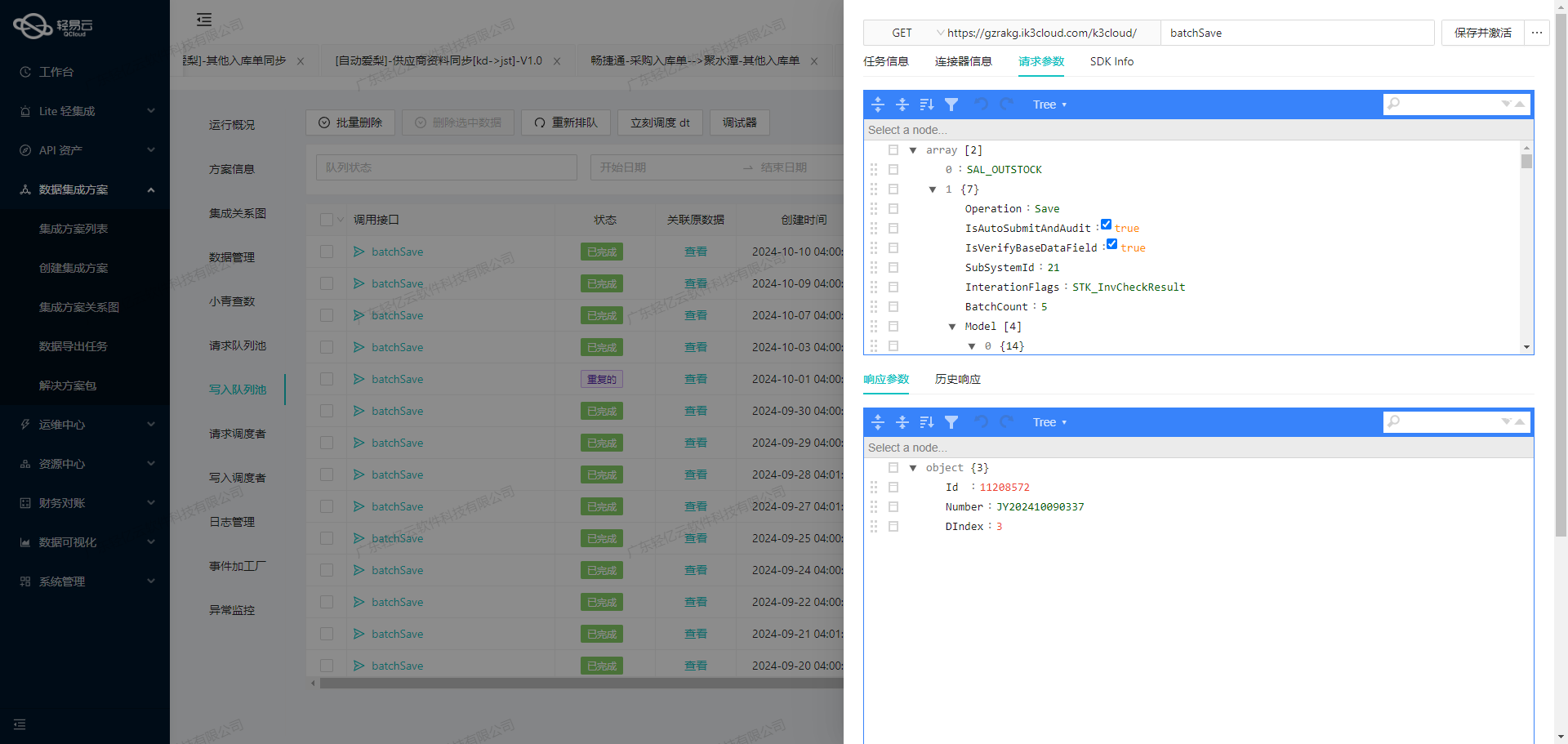

在本案例中,我们需要将KIS私有云中的物料数据,通过API接口 /koas/APP006992/api/Material/List,集成到聚水潭系统中的商品模块,目标API为 /open/jushuitan/itemsku/upload。这一过程不仅要求高吞吐量的数据写入能力,还需实时监控和处理可能出现的数据质量问题。

解决方案概述

为了实现这一目标,我们采用了以下几个关键技术特性:

- 高吞吐量的数据写入能力:确保大量物料数据能够快速、稳定地被写入到聚水潭系统中。

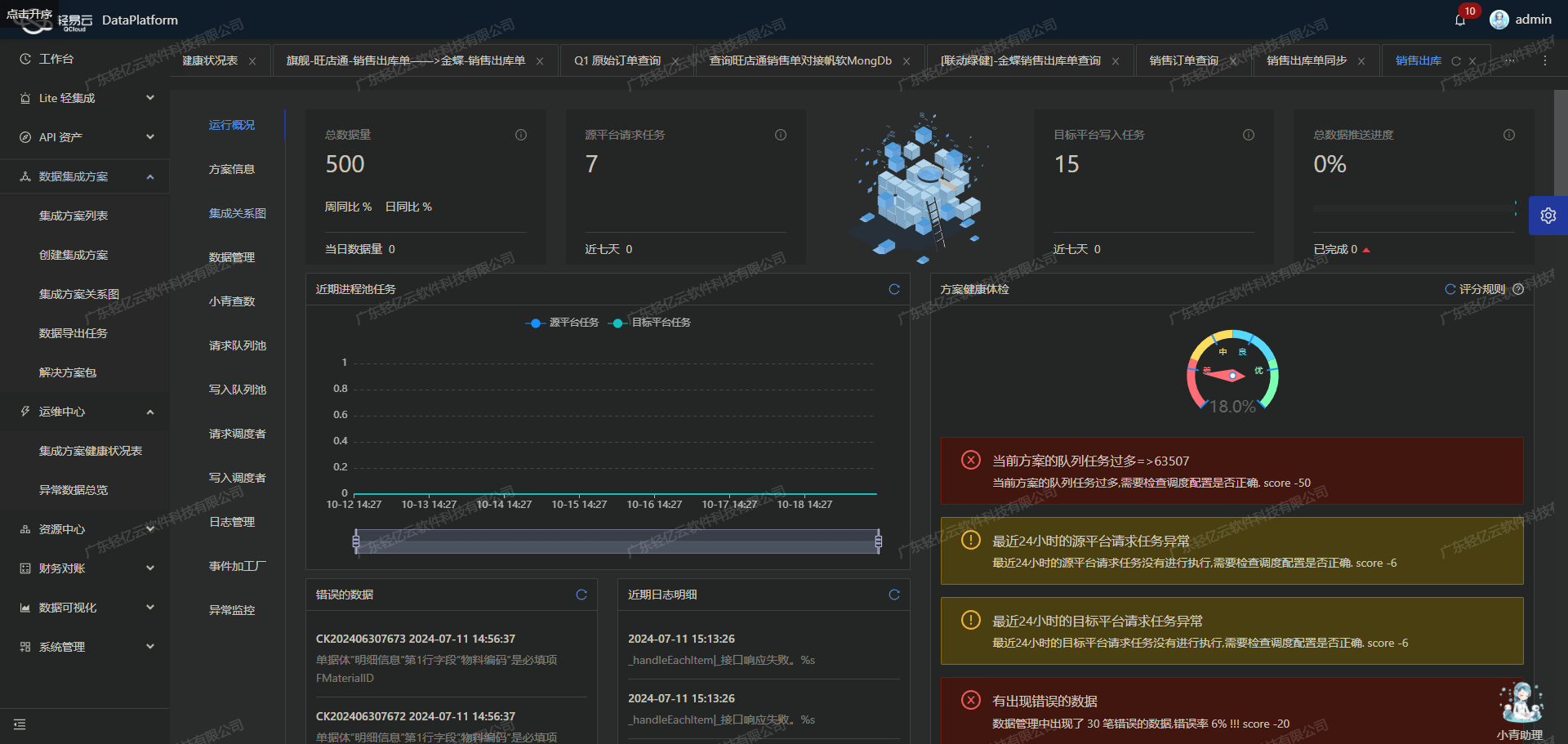

- 集中监控和告警系统:实时跟踪每个数据集成任务的状态和性能,及时发现并处理异常情况。

- 自定义数据转换逻辑:适应不同业务需求和数据结构差异,实现精准的数据映射。

- 分页与限流处理机制:有效应对KIS私有云接口的分页限制和请求频率控制,保证数据抓取的完整性与可靠性。

- 异常处理与错误重试机制:在对接过程中,如果遇到错误或异常情况,可以自动进行重试,确保任务最终成功完成。

技术要点解析

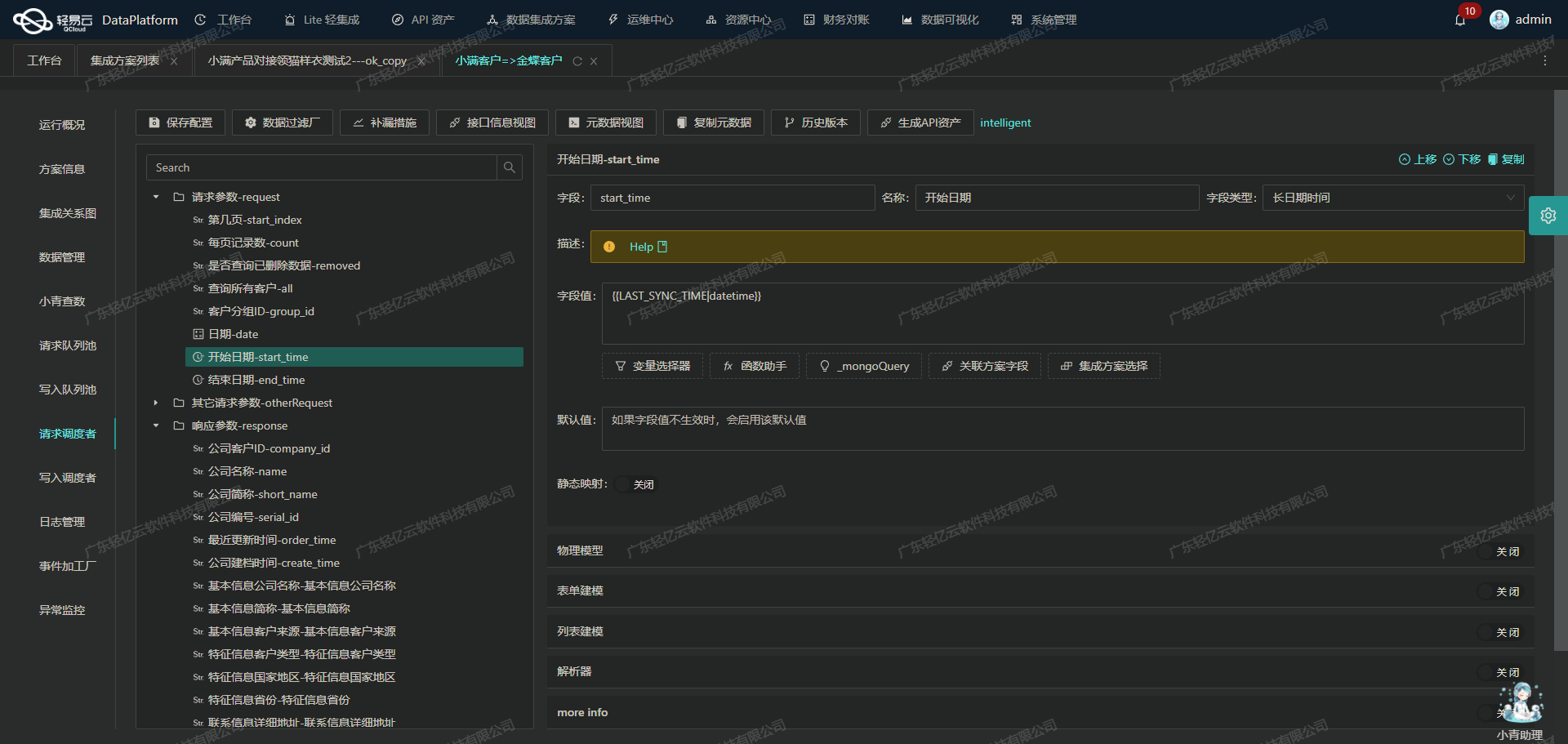

首先,通过轻易云平台提供的可视化操作界面,我们设计了一条从KIS私有云到聚水潭的数据流。在这个过程中,每一步都可以清晰地看到当前的数据状态,并且可以根据实际需求进行调整。例如,在抓取KIS私有云接口数据时,我们设置了定时任务,以确保能够定期获取最新的物料信息。同时,为了避免漏单现象,我们还配置了详细的日志记录功能,对每次抓取操作进行记录和追溯。

其次,在处理两者之间的数据格式差异时,我们利用自定义转换逻辑,将KIS私有云中的物料字段映射到聚水潭商品字段上。这不仅提高了数据对接的一致性,也减少了人工干预的工作量。

最后,通过集中监控系统,我们能够实时掌握整个集成过程中的各项指标,如任务执行时间、成功率等。一旦发现异常情况,系统会立即发出告警,并触发相应的错误重试机制,从而保障整个流程的稳定运行。

以上就是本次技术案例开头部分内容。在后续章节中,我们将详细介绍具体实施步骤及相关配置细节。

调用KIS私有云接口获取并加工数据

在集成KIS私有云与聚水潭的过程中,第一步是调用KIS私有云接口/koas/APP006992/api/Material/List以获取物料数据,并进行必要的数据加工处理。以下将详细探讨这一过程中的关键技术点和实现方法。

接口调用配置

首先,需要配置元数据以便正确调用KIS私有云的API。根据提供的元数据配置,我们需要发送一个POST请求到/koas/APP006992/api/Material/List,请求参数包括:

AccountDB: 数据库账号ItemsOfPage: 每页项目数CurrentPage: 当前页码StartDate: 开始日期(通过函数替换为上次同步时间)EndDate: 结束日期(通过函数替换为当前时间)

这些参数确保了我们能够分页获取物料列表,同时支持按时间段过滤。

分页与限流处理

由于物料数据可能非常庞大,分页处理显得尤为重要。每次请求返回100条记录,通过调整CurrentPage参数逐页获取所有数据。同时,为了避免接口限流问题,可以在每次请求之间加入适当的延时或使用异步并发请求机制。

{

"field": "ItemsOfPage",

"label": "ItemsOfPage",

"type": "string",

"value": "100"

}数据清洗与转换

从接口返回的数据需要进行清洗和转换,以符合目标系统聚水潭的要求。例如,将日期格式从ISO标准转换为目标系统所需的格式,或者对字段名称进行映射。此外,还需要处理一些特定业务逻辑,如过滤掉无效或重复的数据。

{

"field": "StartDate",

"label": "StartDate",

"type": "string",

"value": "_function REPLACE ('{{LAST_SYNC_TIME|datetime}}',' ','T')"

}实时监控与日志记录

为了确保整个数据集成过程透明且可追溯,实时监控和日志记录是必不可少的。轻易云平台提供了集中监控和告警系统,可以实时跟踪每个数据集成任务的状态和性能。一旦出现异常情况,例如网络超时或数据格式错误,系统会及时发出告警,并记录详细日志供后续分析。

异常处理与重试机制

在实际操作中,不可避免地会遇到各种异常情况,如网络波动、接口响应超时等。因此,需要设计健壮的异常处理和重试机制。例如,当某次请求失败时,可以自动重试几次,如果仍然失败,则记录错误信息并跳过该批次,以免影响整体流程。

{

"condition_bk": [

[

{

"field": "F_103",

"logic": "notnull"

}

]

]

}数据质量监控

为了保证最终写入聚水潭的数据质量,需要在数据清洗阶段引入质量监控措施。例如,对关键字段进行非空检查、值域校验等。一旦发现不合格的数据,应立即标记并隔离,以防止污染目标数据库。

通过上述步骤,我们可以高效地从KIS私有云中提取物料数据,并经过一系列清洗、转换后,将其安全可靠地传输至聚水潭。这不仅提高了数据集成效率,也确保了最终业务应用的数据质量和一致性。

将KIS私有云物料数据转换并写入聚水潭商品接口

在数据集成生命周期的第二步中,关键任务是将已经从KIS私有云系统提取的物料数据进行ETL(提取、转换和加载)处理,并将其转换为聚水潭API接口所能接收的格式,最终写入目标平台。以下将详细探讨这一过程中的技术细节和实现方法。

数据提取与清洗

首先,从KIS私有云系统中提取物料数据。假设我们调用了KIS私有云接口 /koas/APP006992/api/Material/List 获取到原始物料数据。为了确保数据完整性和准确性,需要对提取的数据进行清洗和预处理,包括处理分页、限流以及数据质量监控等问题。

数据转换

在数据转换阶段,需要将KIS私有云的物料数据映射到聚水潭API接口所需的数据结构。根据提供的元数据配置,聚水潭API /open/jushuitan/itemsku/upload 需要以下字段:

sku_id:商品编码,对应KIS系统中的{F_103}i_id:款式编码,同样对应{F_103}name:商品名称,对应{FName}

此外,还需要一个额外的字段 dataKey,其值为 items。

数据映射示例

假设从KIS私有云获取到以下物料数据:

{

"F_103": "12345",

"FName": "Sample Product"

}根据元数据配置,需要将其转换为如下格式:

{

"sku_id": "12345",

"i_id": "12345",

"name": "Sample Product",

"dataKey": "items"

}数据加载

完成数据转换后,将其通过POST请求写入到聚水潭API接口。此时需要注意以下几点:

- 高吞吐量:确保大量数据能够快速写入聚水潭,以提升处理时效性。

- 异常处理:实现错误重试机制,确保在网络异常或其他错误情况下能够重新尝试提交。

- 实时监控与日志记录:监控整个ETL过程,记录每个步骤的日志,以便于追踪和排查问题。

请求示例

通过HTTP POST请求,将上述转换后的数据发送至聚水潭API:

POST /open/jushuitan/itemsku/upload HTTP/1.1

Host: api.jushuitan.com

Content-Type: application/json

{

"sku_id": "12345",

"i_id": "12345",

"name": "Sample Product",

"dataKey": "items"

}实现细节

- 批量处理:为了提高效率,可以将多个物料记录批量处理并一次性提交给聚水潭API。

- 定时抓取:通过定时任务定期从KIS私有云接口抓取最新的物料信息,确保聚水潭中的商品信息始终最新。

- 自定义逻辑:根据业务需求,自定义转换逻辑以适应特定的数据结构和格式要求。

实践建议

- 分页与限流:针对KIS私有云接口的分页和限流问题,可以实现自动分页抓取机制,并设置合理的限流策略,避免因请求过多导致服务不可用。

- 错误重试机制:在对接过程中,如果遇到异常情况(如网络超时、服务器错误等),应实现自动重试机制,并记录错误日志,以便后续分析和优化。

- 实时监控:利用平台提供的集中监控和告警系统,实时跟踪ETL任务状态,及时发现并解决潜在问题。

通过上述步骤,可以有效地将KIS私有云的物料数据转换并写入到聚水潭商品接口,实现两个系统之间的数据无缝对接。在实际应用中,根据具体业务需求,可以进一步优化和调整ETL流程,提高整体效率和稳定性。