SQL Server数据集成到MySQL的技术案例分享

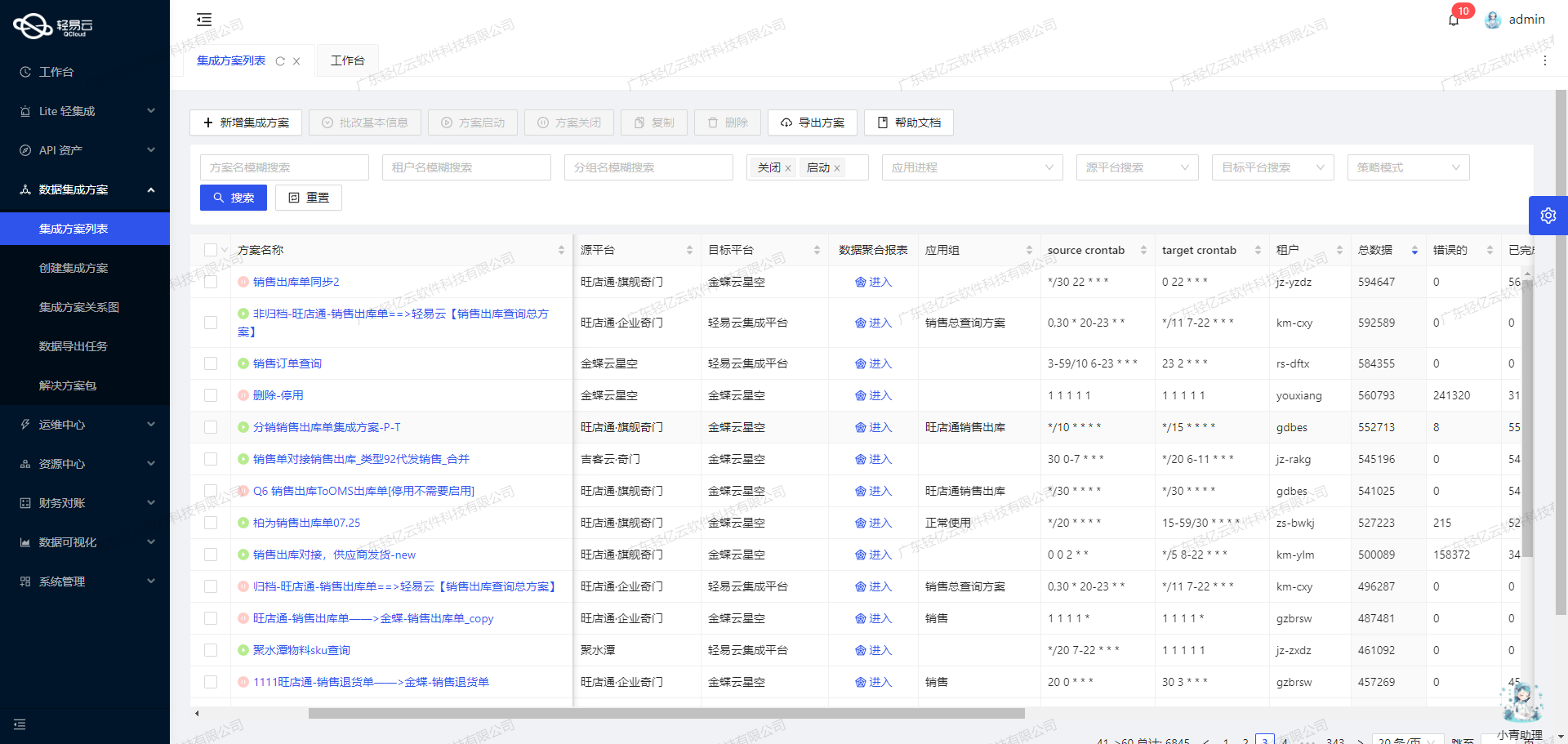

在企业信息化系统中,数据的高效流转和准确对接是确保业务顺畅运行的关键。本文将聚焦于一个具体的系统对接集成案例:将SQL Server中的采购明细单表数据集成到MySQL数据库中。该方案名称为“9--巨益OMS-采购明细单表-->Mysql-采购明细单表-purchaseorderdetail_z”。

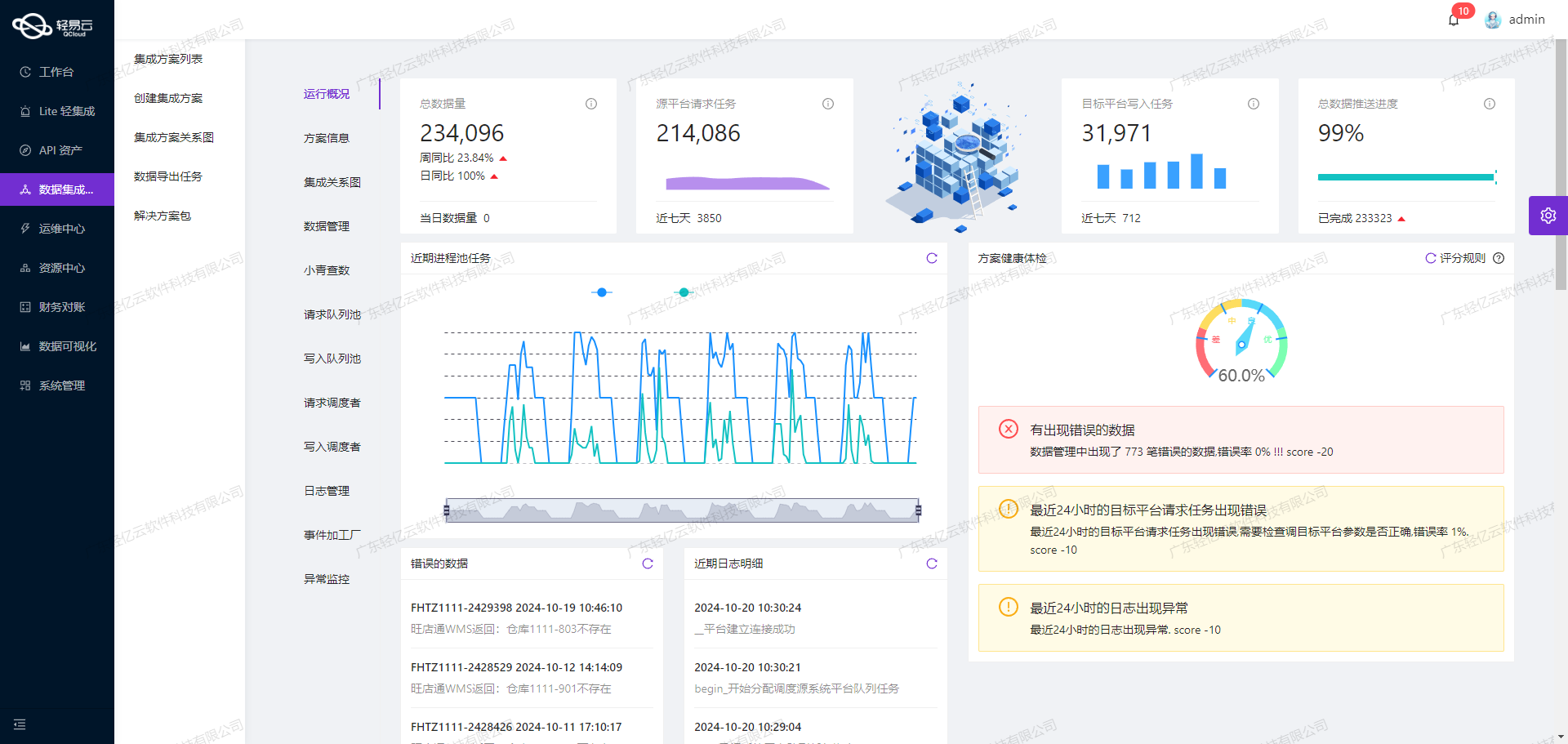

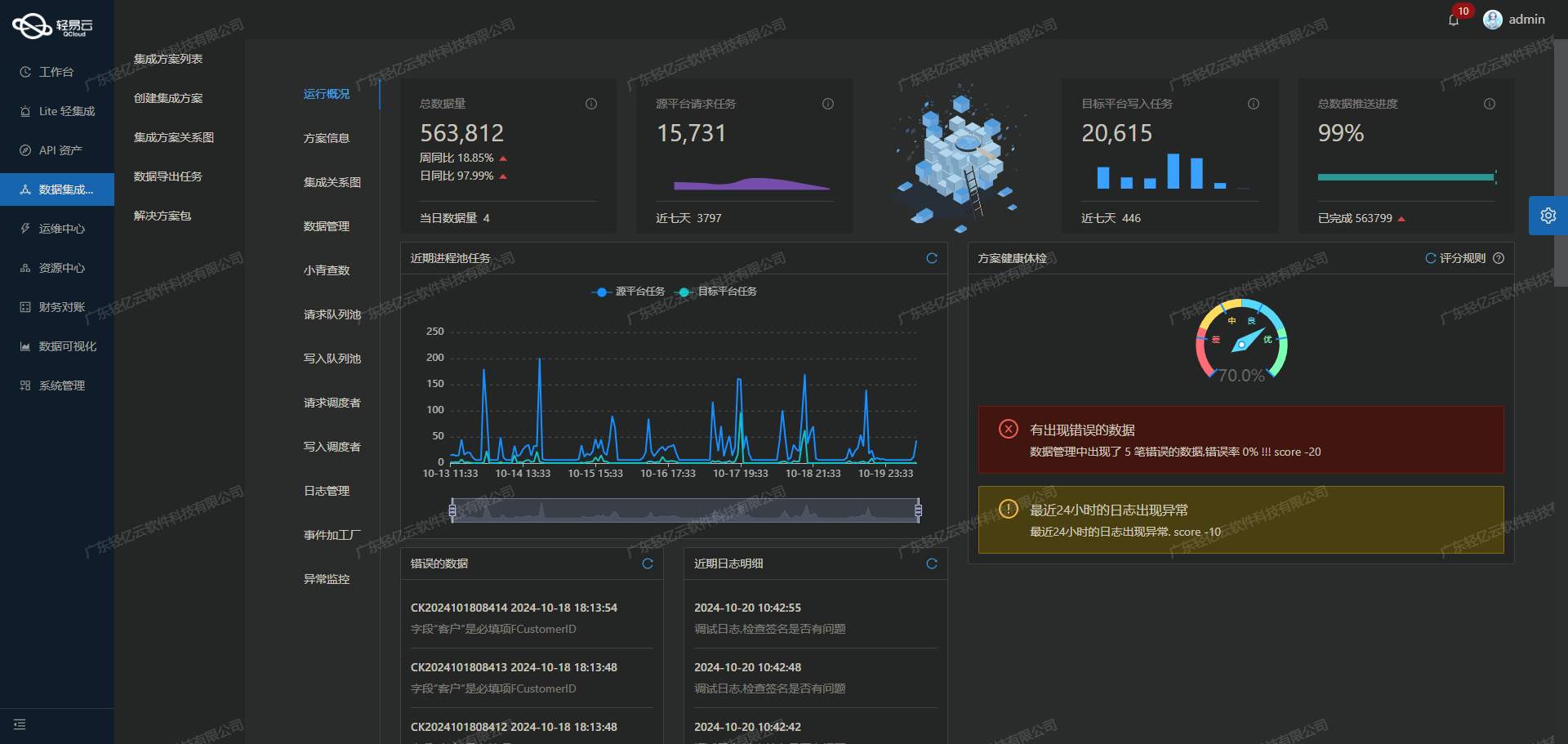

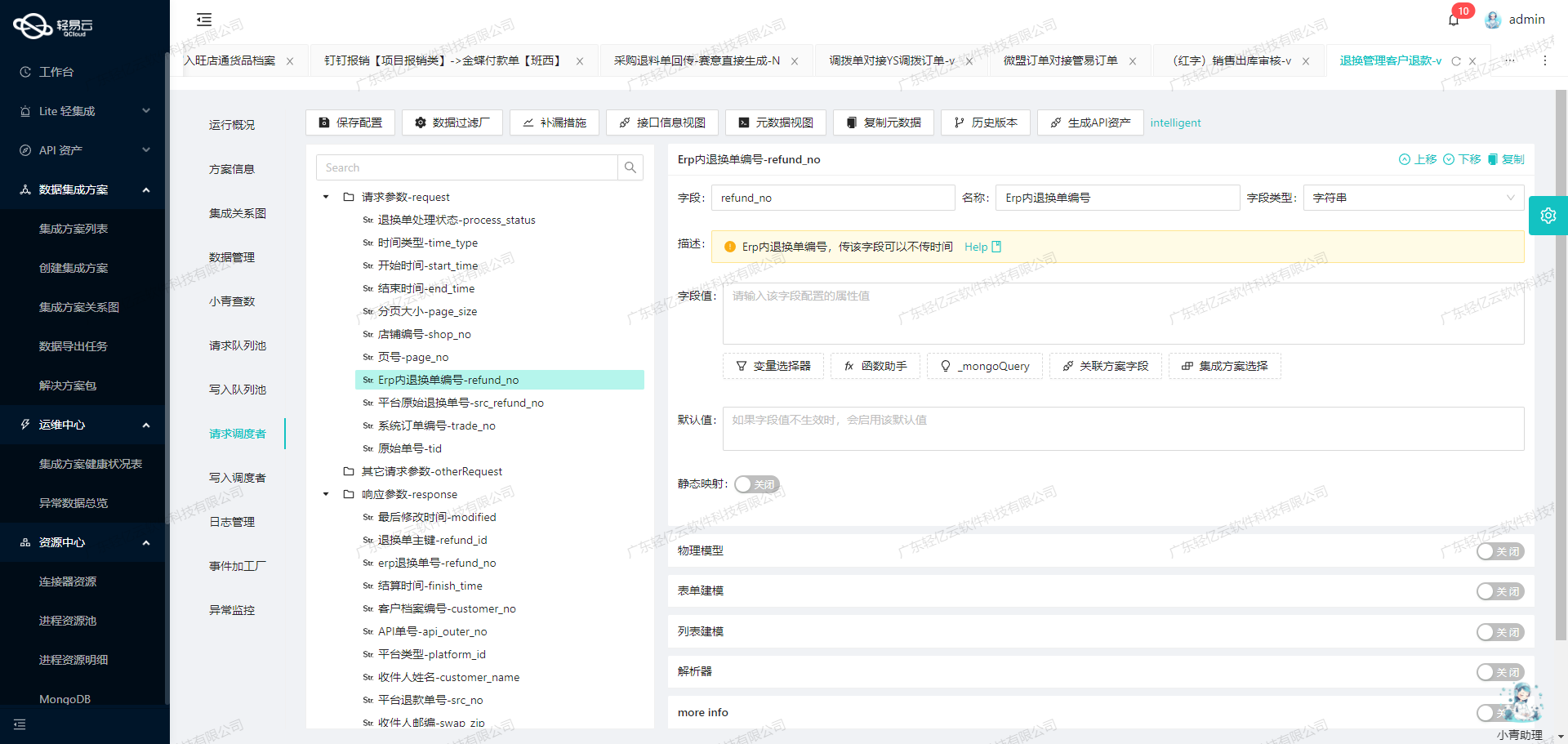

为了实现这一目标,我们利用了轻易云数据集成平台提供的一系列强大功能,包括高吞吐量的数据写入能力、实时监控与告警系统、自定义数据转换逻辑以及可视化的数据流设计工具。

首先,通过SQL Server获取采购明细单表的数据,我们使用了select API接口。这一过程不仅需要确保数据的完整性和准确性,还要处理分页和限流问题,以避免对源数据库造成过大的负载。同时,定时可靠地抓取SQL Server接口数据也是至关重要的一环。

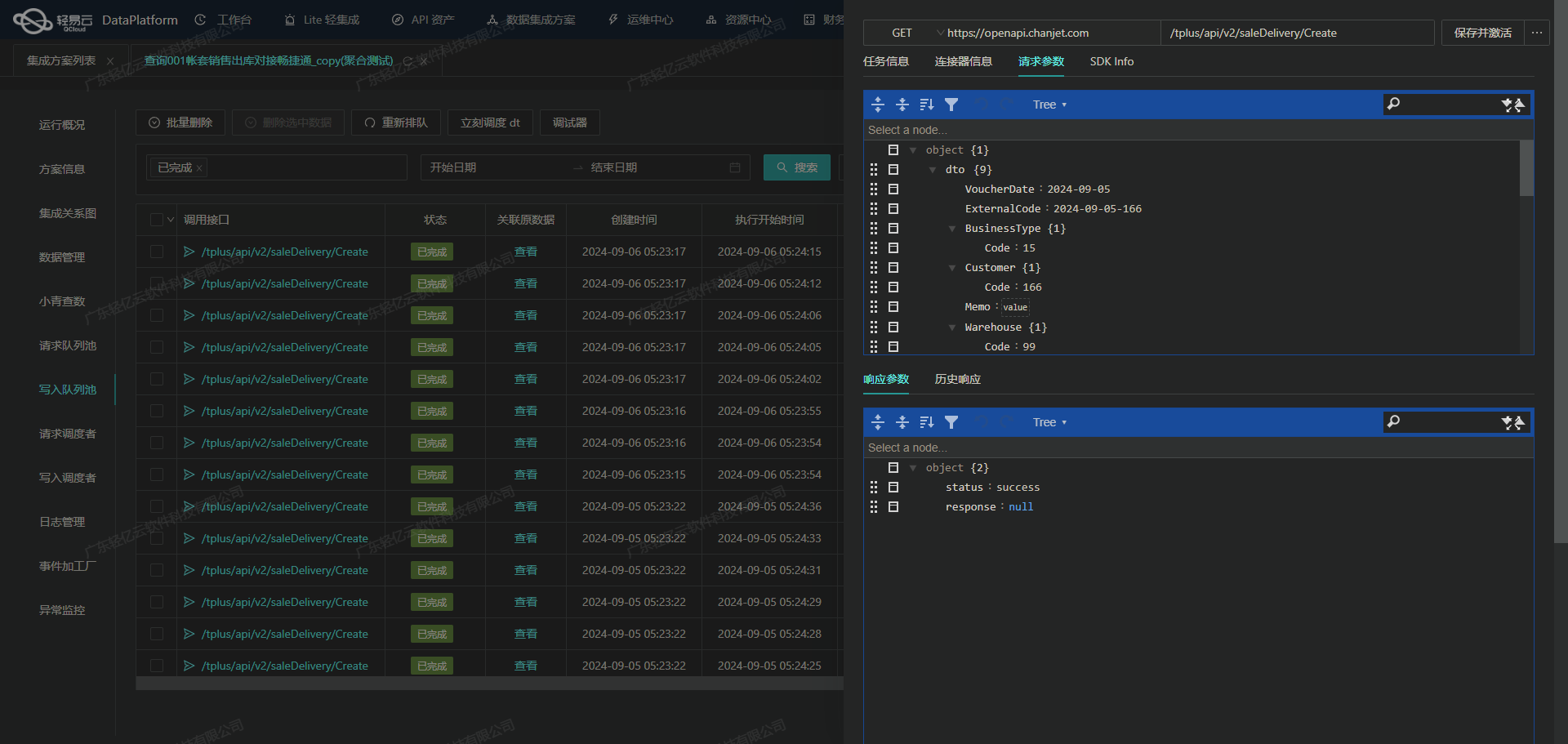

在数据传输过程中,轻易云平台提供了集中监控和告警系统,实时跟踪每个数据集成任务的状态和性能。一旦出现异常情况,如网络波动或接口响应超时,系统能够及时发出告警,并通过错误重试机制进行自动修复,从而保证整个流程的稳定性。

当数据成功获取后,需要将其批量写入到MySQL数据库中。此时,我们利用batchexecute API接口,实现大量数据的快速写入。在这一过程中,自定义的数据转换逻辑可以帮助我们适应不同业务需求和数据结构,确保两端系统之间的数据格式一致。此外,为了进一步优化资源利用率,我们还通过统一视图和控制台全面掌握API资产的使用情况。

最后,在MySQL端进行定制化的数据映射对接,使得最终存储的数据能够满足业务应用需求。同时,通过实时监控与日志记录功能,可以随时查看并分析每一步操作,为后续优化提供有力支持。

综上所述,本次集成方案充分利用了轻易云平台的多项特性,实现了从SQL Server到MySQL的数据无缝对接,为企业高效管理采购明细单表提供了坚实保障。

调用SQL Server接口select获取并加工数据

在轻易云数据集成平台的生命周期中,调用源系统SQL Server接口select获取并加工数据是至关重要的一步。本文将详细探讨如何通过配置元数据来实现这一过程,并确保数据的高效、准确集成。

元数据配置解析

首先,我们需要理解元数据配置中的各个关键字段及其作用:

api: 表示使用的API类型,这里为select。effect: 定义操作类型,这里为QUERY,即查询操作。method: 指定方法类型,这里为SQL。number,id: 用于标识记录的唯一ID字段,这里均为DetailId。request: 包含请求参数的定义,包括分页参数和时间范围参数。otherRequest: 包含主查询语句,用于从SQL Server中获取采购明细单表的数据。

请求参数详解

在请求参数部分,我们定义了一个名为main_params的对象,其中包含以下子参数:

offset: 分页偏移量,用于控制查询结果的起始位置。fetch: 每次查询获取的数据条数,默认值为5000。CreateDateBegin,CreateDateEnd: 时间范围参数,用于限定查询的数据记录日期区间。这两个参数分别使用了模板变量{{LAST_SYNC_TIME|datetime}}和{{CURRENT_TIME|datetime}},以动态生成时间戳。

这些请求参数确保了我们能够按需分页抓取大批量的数据,同时限定了时间范围,以避免重复或遗漏数据。

主查询语句解析

主查询语句如下:

select DetailId, CreateDate, PurchaseOrderId, ProductId, ProductCode, ProductName, SkuId, SkuCode, SkuName, Color, Size, BarCode, PurchaseQty, OriginalPrice, CurrentPrice, NoticeQty, InStockQty, Remark,

Attr1, Attr2, Attr3, Attr4, Attr5, ArrivalDate,

ReturnQuantity from PurchaseOrderDetail where CreateDate>=:CreateDateBegin and CreateDate<=:CreateDateEnd order by DetailId offset :offset rows fetch next :fetch rows only这条SQL语句从采购明细单表(PurchaseOrderDetail)中选择所需字段,并根据创建日期(CreateDate)进行筛选。同时,通过分页机制(offset 和 fetch)控制每次返回的数据量,以提高查询效率和系统性能。

数据加工与处理

在获取到原始数据后,需要对其进行必要的清洗和转换,以适应目标系统MySQL的数据结构和业务需求。轻易云平台提供自定义数据转换逻辑功能,可以根据具体需求编写转换规则。例如,将日期格式统一、对特定字段进行计算或合并等。

此外,为确保集成过程中不漏单,可以设置定时任务定期抓取SQL Server接口数据,并结合实时监控与日志记录功能,及时发现并处理异常情况。这样可以保证每一条采购明细单都被准确无误地集成到目标系统中。

实时监控与告警

为了进一步提升数据集成过程的可靠性,轻易云平台还提供集中监控和告警系统。通过实时跟踪每个任务的状态和性能指标,可以快速响应潜在问题。例如,当某次抓取任务失败时,可以触发告警通知相关人员,并自动执行错误重试机制,以最大限度减少因网络波动或其他原因导致的数据丢失风险。

综上所述,通过合理配置元数据并利用轻易云平台提供的各种特性,我们可以高效、安全地实现从SQL Server到MySQL的数据集成。在这个过程中,调用源系统接口select获取并加工处理数据是关键的一步,它直接影响到整个生命周期内后续步骤的顺利进行。

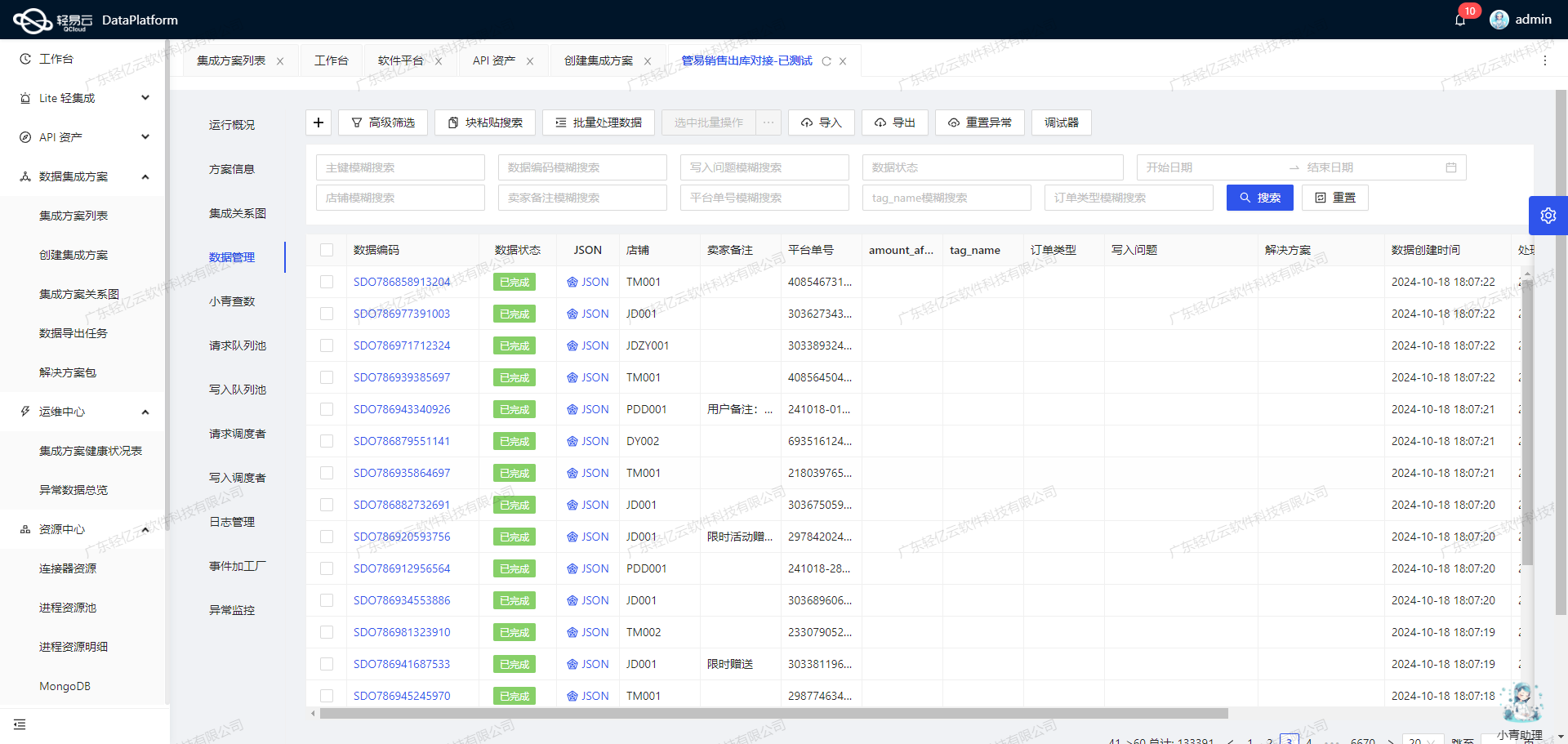

数据ETL转换与MySQLAPI接口集成实践

在数据集成生命周期的第二步,我们需要将源平台的数据进行ETL转换,使其符合目标平台MySQLAPI接口的要求,并最终写入目标平台。这一过程涉及数据的提取、清洗、转换和加载(ETL),确保数据能够无缝对接并高效写入MySQL数据库。

数据提取与清洗

首先,从源平台巨益OMS中提取采购明细单表的数据。为了保证数据的一致性和完整性,需要对提取的数据进行必要的清洗操作。例如,处理缺失值、去除重复记录以及标准化数据格式。

在元数据配置中,request字段定义了各个需要提取的字段及其类型。例如:

{

"field": "DetailId",

"label": "DetailId",

"type": "string",

"value": "{DetailId}"

}这里定义了DetailId字段为字符串类型,并从源数据中提取相应的值。类似地,其他字段如CreateDate、PurchaseOrderId等也按照相应的配置进行提取和清洗。

数据转换

在完成数据清洗后,需要将这些数据转换为目标平台MySQLAPI接口所能接收的格式。这个过程中,需特别注意数据类型的匹配和格式的一致性。例如,日期类型字段需要确保符合MySQL的日期格式要求。

元数据配置中的otherRequest字段定义了主语句和批量处理限制:

{

"field": "main_sql",

"label": "主语句",

"type": "string",

"describe": "111",

"value": "REPLACE INTO purchaseorderdetail_z (DetailId,CreateDate,PurchaseOrderId,ProductId,ProductCode,ProductName,SkuId,SkuCode,SkuName,Color,Size,BarCode,PurchaseQty,OriginalPrice,CurrentPrice,NoticeQty,InStockQty,Remark,Attr1,Attr2,Attr3,Attr4,Attr5,ArrivalDate,ReturnQuantity) VALUES"

},

{

"field": "limit",

"label": "limit",

"type": "string",

"value": "1000"

}上述主语句定义了一个REPLACE INTO操作,将转换后的数据插入到目标表purchaseorderdetail_z中,并设置批量处理限制为1000条记录。

数据加载

最后一步是将转换后的数据通过MySQLAPI接口写入到目标平台。为了保证高效的数据写入,可以利用批量操作和高吞吐量特性。通过设置合理的批次大小,可以显著提升写入效率,同时减少网络延迟对性能的影响。

在实际操作中,还需考虑异常处理与错误重试机制。通过实时监控和日志记录,可以及时发现并处理数据写入过程中的问题。例如,当出现网络故障或数据库连接超时时,可以自动进行重试操作,确保数据完整性和一致性。

实践案例:调用MySQLAPI接口实现批量写入

以下是一个简化的示例,通过调用MySQLAPI接口实现批量写入采购明细单表的数据:

-

构建请求体: 根据元数据配置构建请求体,包括所有需要插入的字段和值。

-

发送请求: 通过HTTP POST方法发送请求到MySQLAPI接口,执行批量插入操作。

-

处理响应: 检查响应状态码和返回信息,根据结果判断是否需要进行错误重试或其他处理。

通过上述步骤,可以高效地将源平台的数据转换并加载到目标平台,实现不同系统间的数据无缝对接。实时监控与告警系统则提供了强有力的保障,确保整个流程透明可控。