CRM-金蝶客户同步-修改:从金蝶云星空到MySQL的数据集成方案

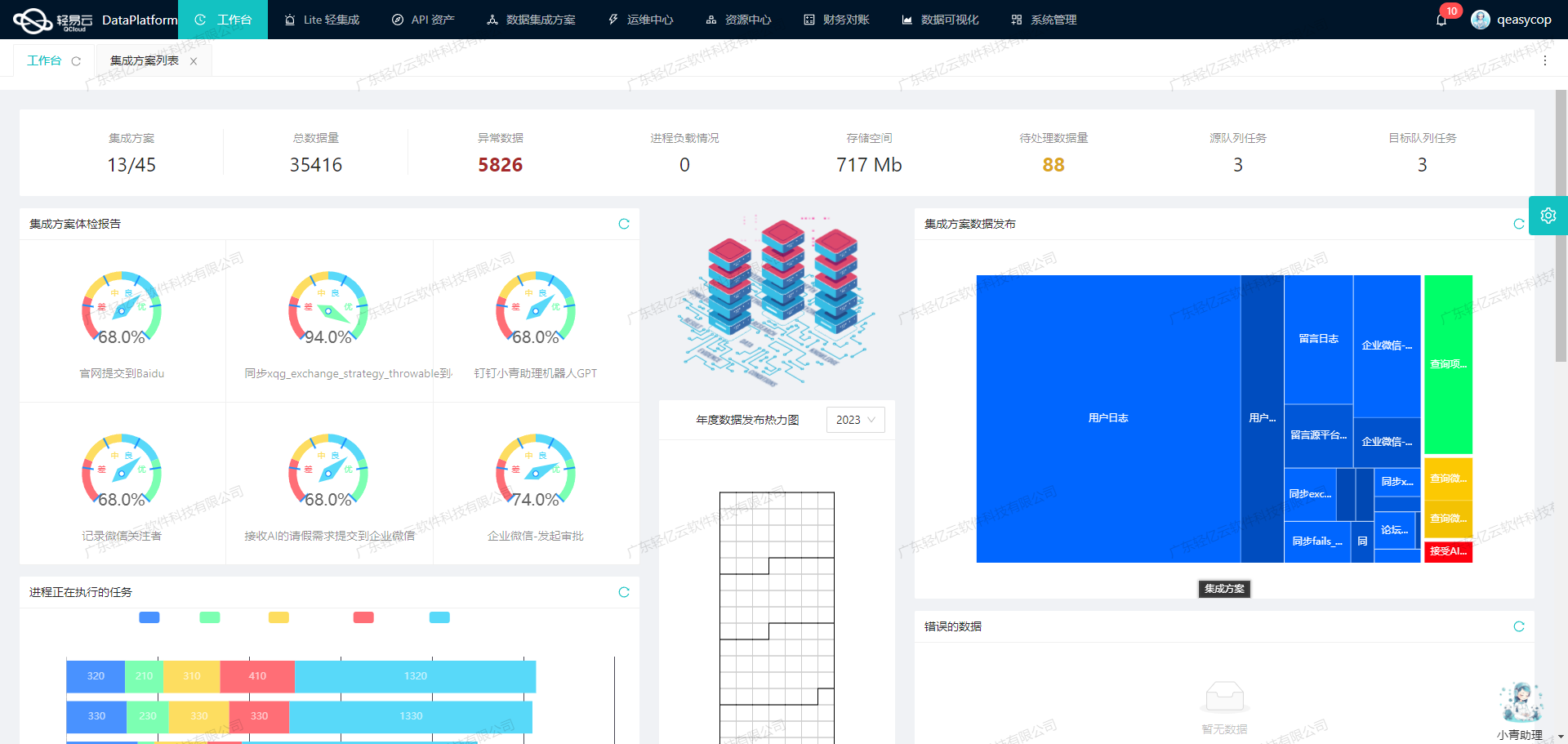

在企业信息化系统中,数据的高效流转和精准同步是确保业务顺畅运行的关键。本文将分享一个具体的技术案例——如何通过轻易云数据集成平台,将金蝶云星空中的客户数据同步到MySQL数据库。此次集成方案命名为“CRM-金蝶客户同步-修改”,旨在实现对客户数据的实时、可靠、高效管理。

数据获取与接口调用

首先,我们需要从金蝶云星空中获取客户数据。这一过程主要依赖于其提供的API接口executeBillQuery。该接口支持定时抓取和批量处理,确保我们能够及时获取最新的数据,同时避免漏单现象。为了应对分页和限流问题,我们设计了相应的逻辑来处理大规模数据请求,确保每次调用都能成功返回所需的数据。

数据写入与性能优化

接收到来自金蝶云星空的数据后,下一步就是将这些数据快速写入到MySQL数据库中。通过使用MySQL的execute API,我们能够实现高吞吐量的数据写入能力,大幅提升了数据处理的时效性。此外,为了保证数据的一致性和完整性,我们还设计了异常处理与错误重试机制,以应对可能出现的网络波动或其他不可预见的问题。

数据转换与格式适配

在实际操作过程中,不同系统之间的数据格式差异是一个常见挑战。为了解决这一问题,我们利用轻易云平台提供的自定义数据转换逻辑,对从金蝶云星空获取的数据进行必要的格式调整,使其符合MySQL数据库的要求。这不仅提高了数据集成效率,也减少了人工干预带来的误差。

实时监控与告警系统

为了确保整个集成过程透明可控,我们引入了一套集中监控和告警系统。该系统能够实时跟踪每个数据集成任务的状态和性能,一旦发现异常情况,会立即触发告警通知相关人员进行处理。这种实时监控机制极大地提升了业务透明度和响应速度,有助于企业更好地掌握整体运营状况。

以上便是本次“CRM-金蝶客户同步-修改”方案开头部分的重要技术要点。在接下来的章节中,我们将详细探讨具体实施步骤及更多技术细节,包括如何调用API、处理分页限流、以及实现定制化的数据映射等内容。

调用金蝶云星空接口executeBillQuery获取并加工数据

在轻易云数据集成平台中,调用源系统金蝶云星空接口executeBillQuery是数据集成生命周期的第一步。此步骤至关重要,因为它决定了后续数据处理和写入的基础。以下将详细探讨如何通过该接口获取并加工数据。

1. 接口配置与请求参数

首先,需要配置金蝶云星空接口executeBillQuery的请求参数。这些参数定义了我们需要从金蝶系统中提取的数据字段及其格式。以下是主要的请求参数:

- FormId: 业务对象表单ID,例如客户信息表单ID为

BD_Customer。 - FieldKeys: 需查询的字段key集合,通过逗号分隔,例如:

FCUSTID,FNumber,FName,... - FilterString: 过滤条件,用于筛选特定的数据记录。例如:

FUseOrgId.Fnumber='T00' and (FModifyDate>='{{LAST_SYNC_TIME|datetime}}' or FForbidDate>='{{LAST_SYNC_TIME|datetime}}') - Limit: 最大行数,用于分页查询。

- StartRow: 开始行索引,用于分页查询。

这些参数确保了我们能够精准地获取所需的数据,并能有效处理分页和限流问题。

2. 数据清洗与转换

在成功调用接口并获取原始数据后,下一步是对数据进行清洗和转换。这一步骤包括以下几个方面:

数据格式转换

由于不同系统之间的数据格式可能存在差异,需要对从金蝶云星空获取的数据进行格式转换。例如,将日期格式从YYYY-MM-DD转换为标准时间戳,或者将字符串类型的数字转换为整数类型。

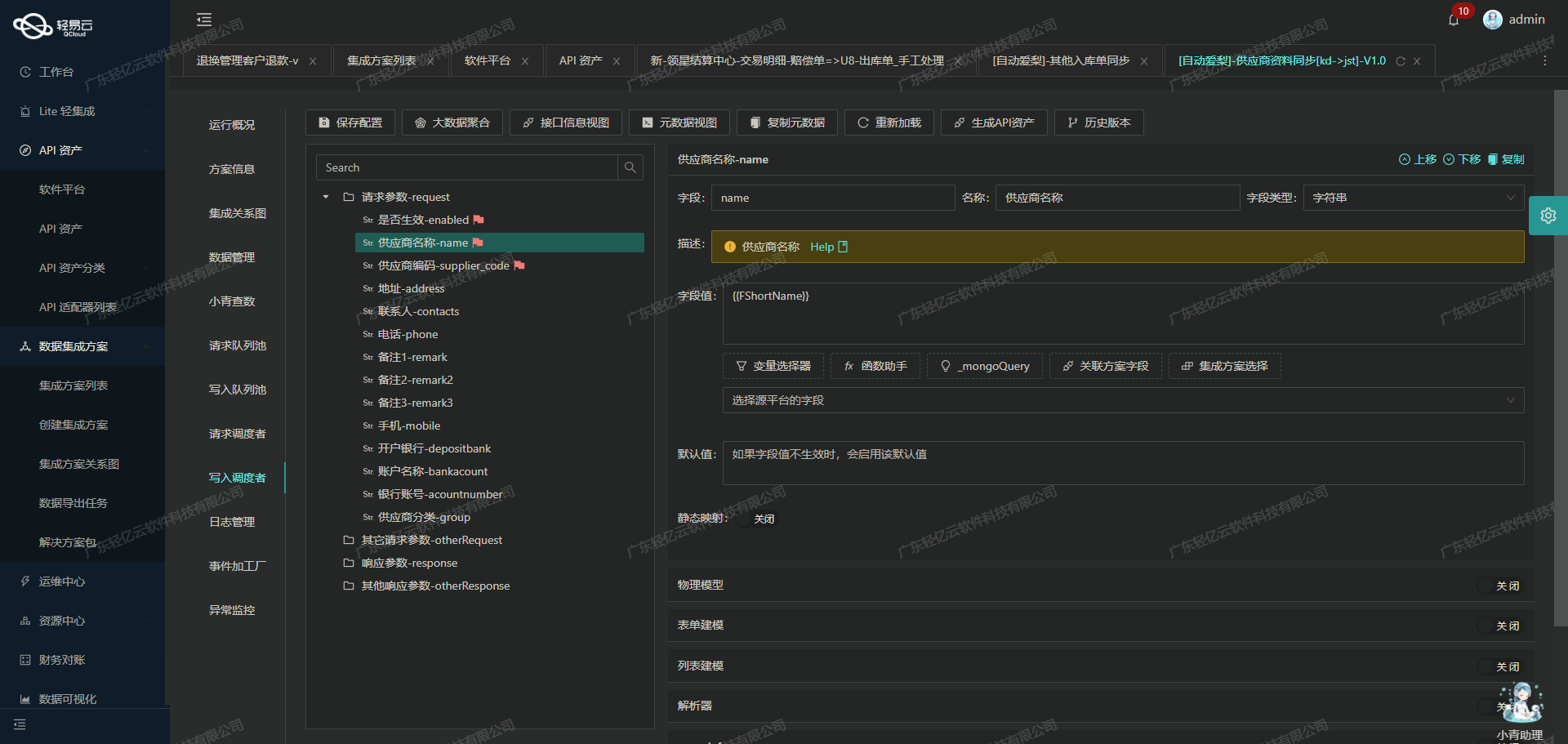

字段映射

根据业务需求,将金蝶系统中的字段映射到目标系统中的对应字段。例如,将金蝶中的客户编码(FNumber)映射到CRM系统中的客户ID(CustomerID)。

{

"FCUSTID": "CustomerID",

"FNumber": "CustomerCode",

"FName": "CustomerName",

...

}数据质量监控

在数据清洗过程中,还需要进行数据质量监控,及时发现并处理异常数据。例如,检查必填字段是否为空,数值型字段是否符合预期范围等。

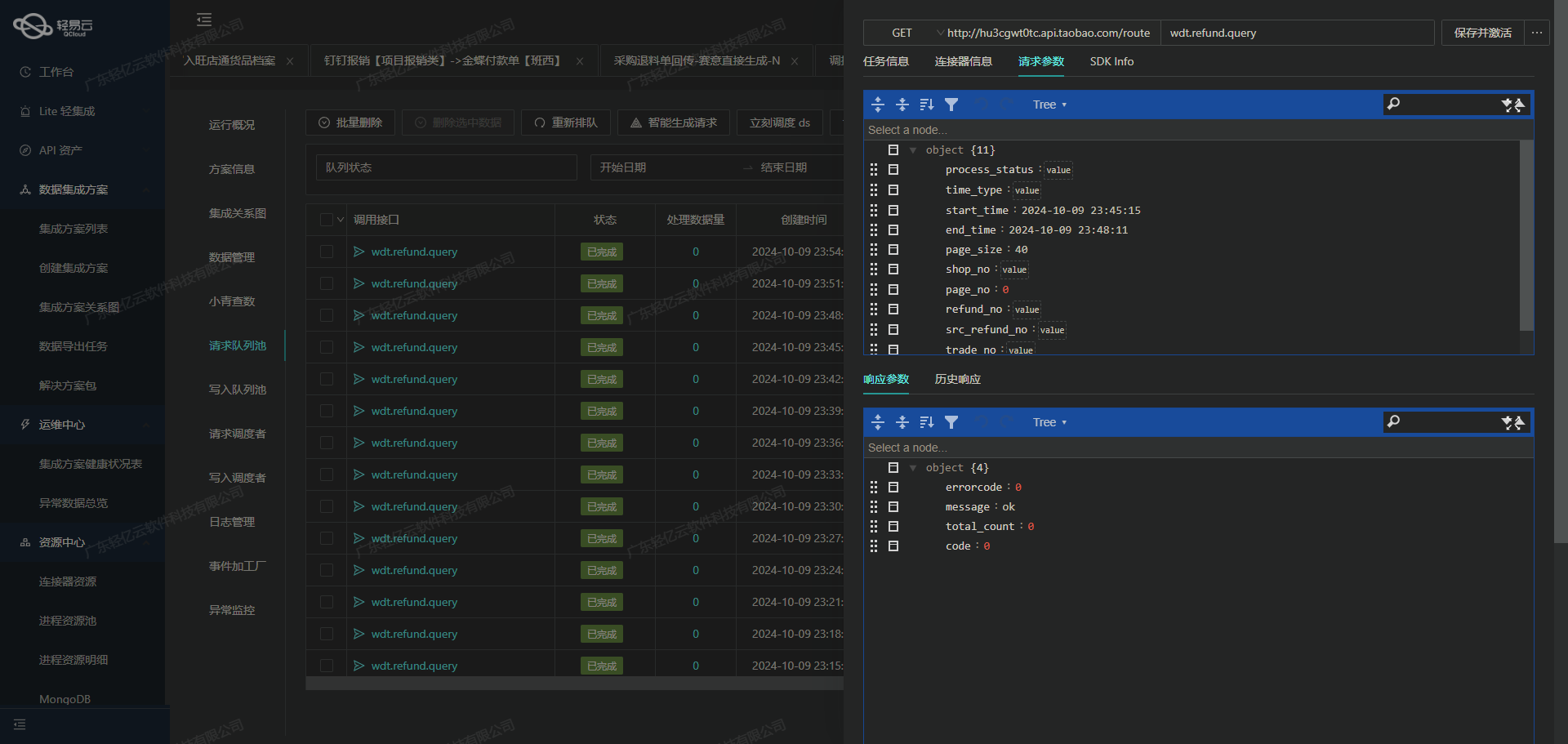

3. 异常处理与重试机制

在调用接口和处理数据时,不可避免地会遇到各种异常情况,如网络超时、API限流等。因此,需要设计一套完善的异常处理与重试机制,以确保数据集成过程的可靠性。

网络超时重试

设置合理的重试策略,当网络超时时自动重新发起请求。例如,可以设置每次重试间隔5秒,总共重试3次。

API限流处理

当遇到API限流错误时,可以采用指数退避算法逐渐增加重试间隔时间,以减轻服务器压力,同时保证最终能成功获取数据。

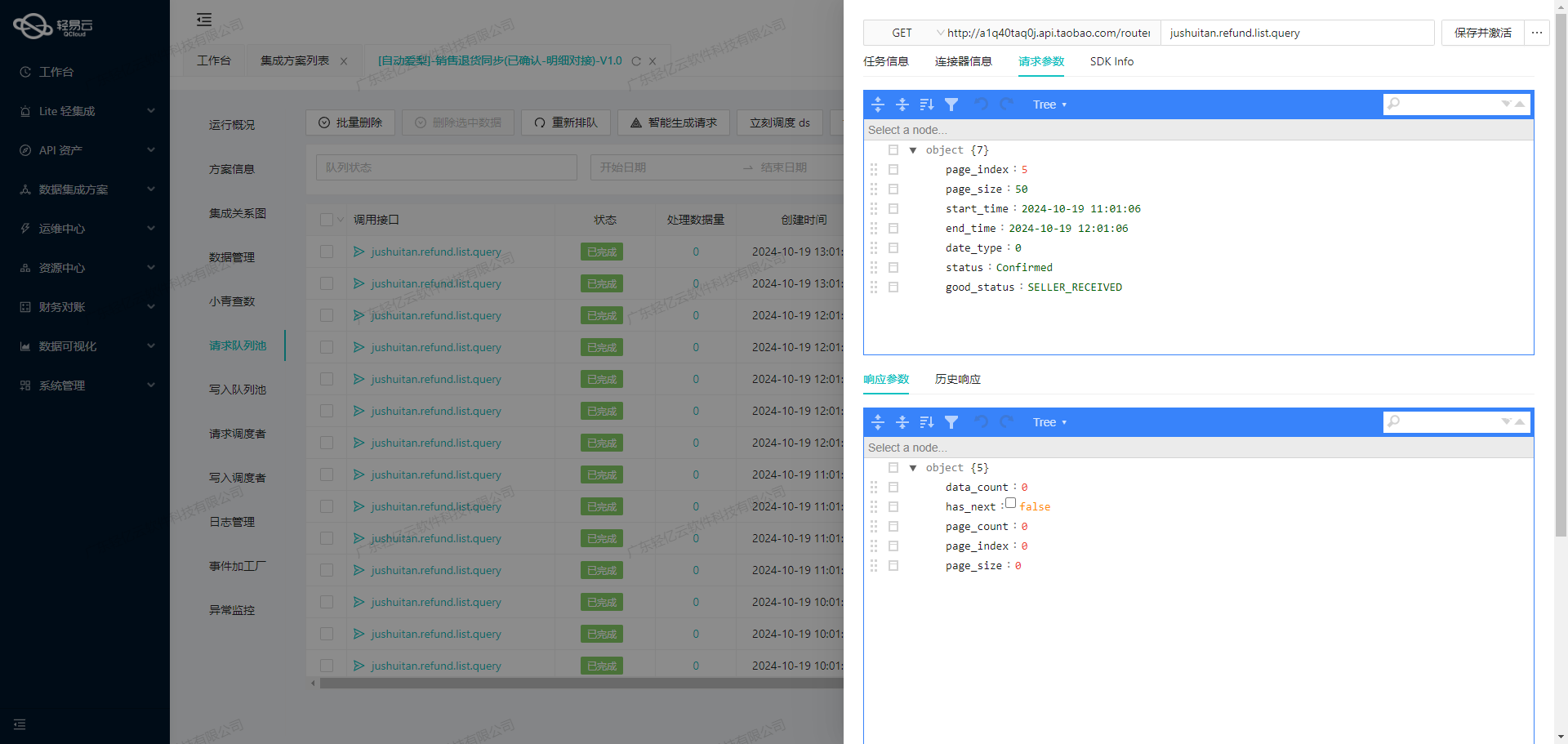

4. 实时监控与日志记录

为了确保整个过程透明可控,需要实时监控每个步骤的执行状态,并记录详细日志。这样可以方便地追踪问题来源,并及时采取措施解决。

集中监控平台

利用轻易云提供的集中监控平台,可以实时查看各个任务的执行状态,包括成功率、失败次数、平均响应时间等关键指标。

日志记录

详细记录每次API调用及其响应结果,包括请求参数、返回值、错误信息等。这样可以方便地进行故障排查和性能优化。

2023-10-01 12:00:00 INFO - 调用executeBillQuery, 请求参数: { ... }

2023-10-01 12:00:01 INFO - 接口响应成功, 返回值: { ... }

2023-10-01 12:05:00 ERROR - 调用executeBillQuery失败, 错误信息: { ... }通过以上步骤,我们可以高效、安全地从金蝶云星空系统中提取所需的数据,并进行必要的清洗和转换,为后续的数据写入和业务应用打下坚实基础。在实际操作中,根据具体业务需求调整相关配置和逻辑,以达到最佳效果。

ETL转换与MySQLAPI接口数据写入

在数据集成的过程中,ETL(提取、转换、加载)是至关重要的一步。本文将重点探讨如何将已经集成的源平台数据进行ETL转换,并转为目标平台MySQLAPI接口所能够接收的格式,最终写入目标平台。

数据提取与清洗

首先,我们需要从源平台(例如CRM系统)提取数据。在这个过程中,需要特别注意数据清洗,确保数据的完整性和准确性。通过轻易云数据集成平台,可以实现高效的数据抓取和清洗。例如,定时可靠地抓取金蝶云星空接口数据,并处理分页和限流问题,以确保不漏单。

数据转换逻辑

在提取到源数据后,需要进行复杂的数据转换,以适应目标平台的需求。这里,我们使用元数据配置来定义转换规则。例如,以下是一个典型的元数据配置:

{

"api": "execute",

"effect": "EXECUTE",

"method": "SQL",

"number": "id",

"id": "id",

"name": "id",

"idCheck": true,

...

}这个配置定义了如何将源数据字段映射到目标数据库中的字段。通过这些配置,可以灵活地处理字段名称、类型和值的转换。例如,将FCUSTID映射为data_id,将FName映射为customer_name等。

MySQLAPI接口的数据写入

在完成数据转换后,需要将其写入到目标平台MySQL中。这一步骤需要特别注意以下几点:

- 高吞吐量的数据写入能力:确保大量数据能够快速被集成到MySQL中,提升了数据处理的时效性。

- 批量集成:通过批量操作,可以大幅提升写入效率。

- 异常处理与错误重试机制:在写入过程中,如果出现异常情况,需要有完善的错误重试机制,以确保数据最终能够成功写入。

- 定制化数据映射对接:根据业务需求,对特定字段进行定制化映射。例如,将注册资本字段

FRegisterFund映射为registered_capital。

以下是一个示例SQL语句,用于将转换后的数据写入MySQL:

update wk_wodtop_customer

set customer_name=:customer_name,

creating_org=:creating_org,

using_org=:using_org,

...

where data_id=:data_id这条语句通过参数化查询,将各个字段的数据插入或更新到目标表中。

实时监控与日志记录

为了确保整个ETL过程的顺利进行,实时监控和日志记录是必不可少的。通过轻易云提供的集中的监控和告警系统,可以实时跟踪数据集成任务的状态和性能,及时发现并处理异常情况。此外,还可以利用日志记录功能,对每次操作进行详细记录,以便后续审计和问题排查。

数据质量监控与异常检测

在整个ETL过程中,需要持续监控数据质量,并及时检测异常情况。例如,通过设置合理的数据校验规则,可以自动检测并处理不符合要求的数据,确保最终写入的数据质量。

总结

通过以上步骤,我们可以有效地将已经集成的源平台数据进行ETL转换,并转为目标平台MySQLAPI接口所能够接收的格式,最终成功写入目标平台。在这个过程中,需要特别关注高效的数据提取与清洗、灵活的数据转换逻辑、高效的数据写入能力、实时监控与日志记录以及严格的数据质量监控与异常检测等方面。