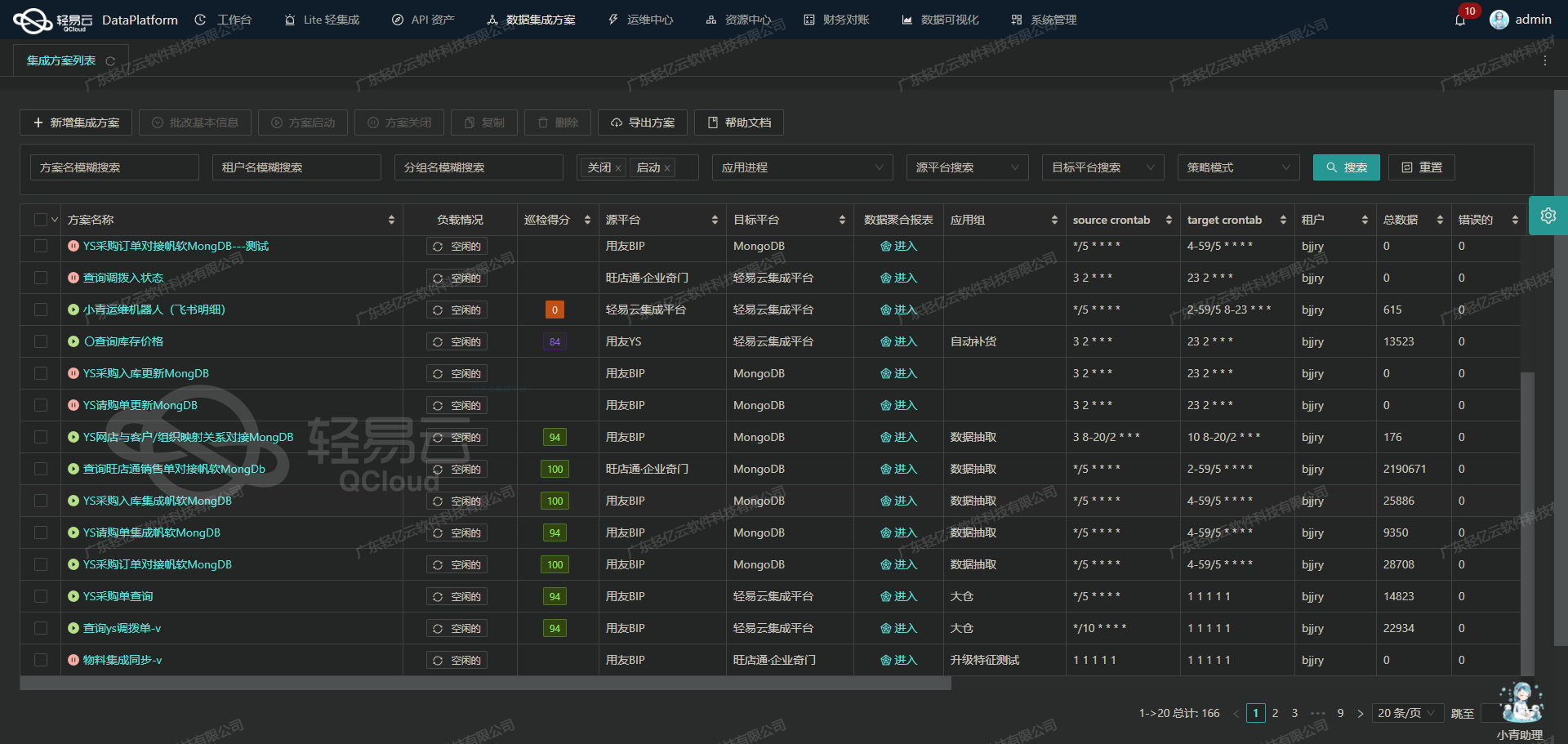

吉客云数据集成到轻易云集成平台——吉客云组装拆卸出库查询案例分享

在现代企业的数字化转型过程中,高效的数据对接和集成成为保障业务流程顺畅运行的重要一环。本次技术案例将深入探讨如何通过轻易云数据集成平台,对接和处理来自吉客云的数据,具体方案为“吉客云组装拆卸出库查询”。

首先,针对客户需求,我们选择了使用吉客云API接口 erp.storage.goodsdocout 来获取相关的库存出库数据。这一步至关重要,需要确保从源头抓取的数据准确无误,并能及时写入到轻易云集成平台。为了实现这一点,我们采用了定时任务机制,以保证能够实时、可靠地从吉客云接口批量获取所需数据。

考虑到实际应用中的海量数据处理需求,我们特别关注以下几个重点技术特性:

- 大量数据快速写入:基于轻易云提供的高效写入API,通过合理设计流水线,实现大规模数据流动而不堵塞。

- 分页与限流控制:利用适当的算法和策略处理分页问题,确保不会因一次性请求过多导致限流封锁。

- 异常处理与重试机制:面对可能出现的数据异常或者网络波动情况,引入健壮的错误重试机制以提高系统稳定性。

- 定制化映射对接:充分利用轻易云灵活的数据映射功能,将不同格式的数据进行有效转换,从而更好地符合业务逻辑要求。

此外,针对两端系统之间增删改查等操作上的差异,还需特别注意把控字段名称、类型及约束条件的一致性。在这个过程中,不仅需要精确调用并解析来自 erp.storage.goodsdocout 的JSON响应,同时还要保障每条记录都能正确写入到目标数据库中。

作为一个系统集成顾问,本次案例不仅展示了全面覆盖各个细节维度的解决方案,同时也强调了一体化管理工具在复杂场景下的重要作用。尤其是在应对例如实时监控或日志记录等方面的问题上,也提供了一些值得借鉴的方法论。

接下来,让我们详细剖析具体实施步骤以及代码实现部分。

调用吉客云接口erp.storage.goodsdocout获取并加工数据

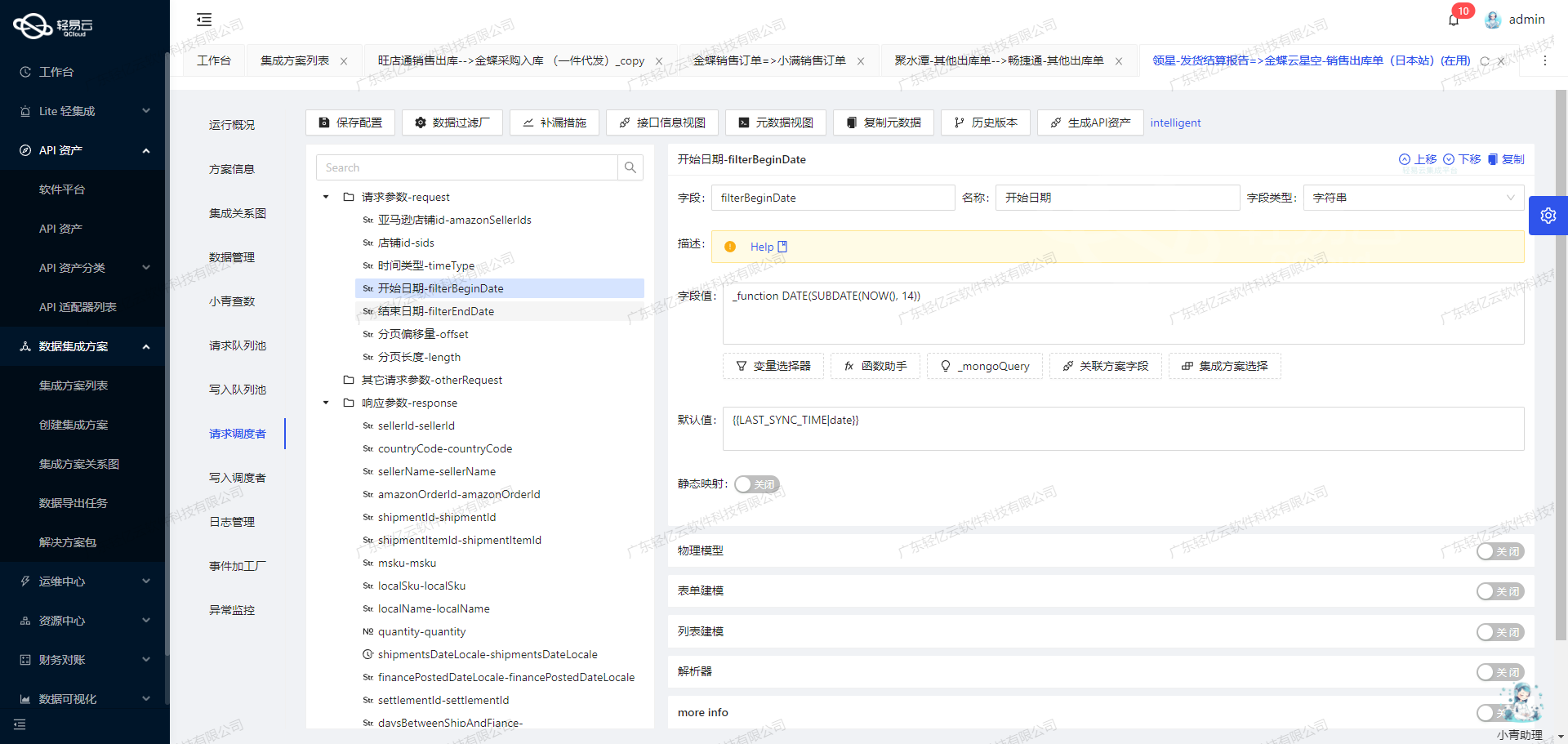

在数据集成的生命周期中,调用源系统接口是至关重要的第一步。本文将深入探讨如何通过轻易云数据集成平台调用吉客云接口erp.storage.goodsdocout,并对获取的数据进行初步加工。

接口调用配置

首先,我们需要配置元数据以便正确调用吉客云的接口。以下是元数据配置的关键部分:

{

"api": "erp.storage.goodsdocout",

"method": "POST",

"number": "goodsdocNo",

"id": "recId",

"pagination": {

"pageSize": 50

},

"beatFlat": ["goodsDocDetailList"],

"request": [

{"field":"pageIndex","label":"分页页码","type":"string"},

{"field":"pageSize","label":"分页页数","type":"string","value":"50"},

{"field":"goodsDocNo","label":"出库单号","type":"string"},

{"field":"startDate","label":"创建时间的起始时间","type":"datetime"},

{"field":"endDate","label":"创建时间的结束时间","type":"datetime"},

{"field":"inouttype","label":"类型","type":"string","describe":"201-销售出库 202调拨出库 203 = 盘亏出库 204-其他出库 205采购退货 206生产领料 207组装拆卸出库 208翻新出库 209报废出库 210残次品出库 211倒冲出库 212 包材出库 215维修还厂 231成本调整出库","value":"207"},

{"field":"sourceBillNo","label":"来源单号","type":"string"},

{"field":"warehouseCode","label":"仓库编号","type":"string"},

{"field":"vendCode","label":"供应商编号(往来单位)","type":"string"},

{"field":"billNo","label":"上游单据号(关联单号)","type":"string"},

{"field":"userName","label":"创建人名称","type":"string"},

{"field":"gmtModifiedStart","label":"主表更新时间起始","type":"datetime", "value": "_function DATE_FORMAT(DATE_ADD(NOW(),INTERVAL -3 DAY),'%Y-%m-%d 00:00:00')"},

{"field":"gmtModifiedEnd","label": "主表更新时间截至", "type": "datetime", "value": "{{CURRENT_TIME|datetime}}"}

]

}请求参数解析

-

分页参数:

pageIndex: 分页页码,字符串类型。pageSize: 分页页数,固定值为50。

-

过滤条件:

goodsDocNo: 出库单号。startDate和endDate: 创建时间的起始和结束时间。inouttype: 类型,固定值为207(组装拆卸出库)。sourceBillNo,warehouseCode,vendCode,billNo,userName: 各种过滤条件,如来源单号、仓库编号、供应商编号、上游单据号和创建人名称。gmtModifiedStart和gmtModifiedEnd: 主表更新时间起始和截至时间。

数据请求与清洗

在配置好元数据后,我们可以通过轻易云平台发起POST请求,从吉客云获取所需的数据。以下是一个示例请求体:

{

"pageIndex": "1",

"pageSize": "50",

"startDate": "2023-01-01T00:00:00",

"endDate": "2023-01-31T23:59:59",

"inouttype": "207"

}请求返回的数据可能包含多个字段,其中包括嵌套的goodsDocDetailList。为了便于后续处理,我们需要将这些嵌套的数据拍平(beatFlat)。

数据转换与写入

在完成数据请求和初步清洗后,我们需要对数据进行转换,以便写入目标系统。这一步通常包括以下操作:

- 字段映射:将源系统中的字段映射到目标系统中的相应字段。例如,将

goodsDocNo映射到目标系统中的订单编号字段。 - 数据格式转换:根据目标系统的要求,对日期、数值等字段进行格式转换。

- 去重与合并:如果从多个请求中获取的数据存在重复,需要进行去重和合并操作。

实际案例分析

假设我们需要将组装拆卸出库的数据导入到另一个ERP系统中,我们可以按照以下步骤进行:

-

调用接口获取数据:

{ "pageIndex": "1", "pageSize": "50", ... } -

拍平嵌套数据: 将返回结果中的

goodsDocDetailList拍平,生成一维数组。 -

字段映射与转换:

{ "orderNumber": "{{goodsdocNo}}", ... } -

写入目标系统: 将处理后的数据通过API或数据库连接写入到目标ERP系统中。

通过上述步骤,我们可以高效地完成从吉客云获取组装拆卸出库数据,并将其集成到其他业务系统中。

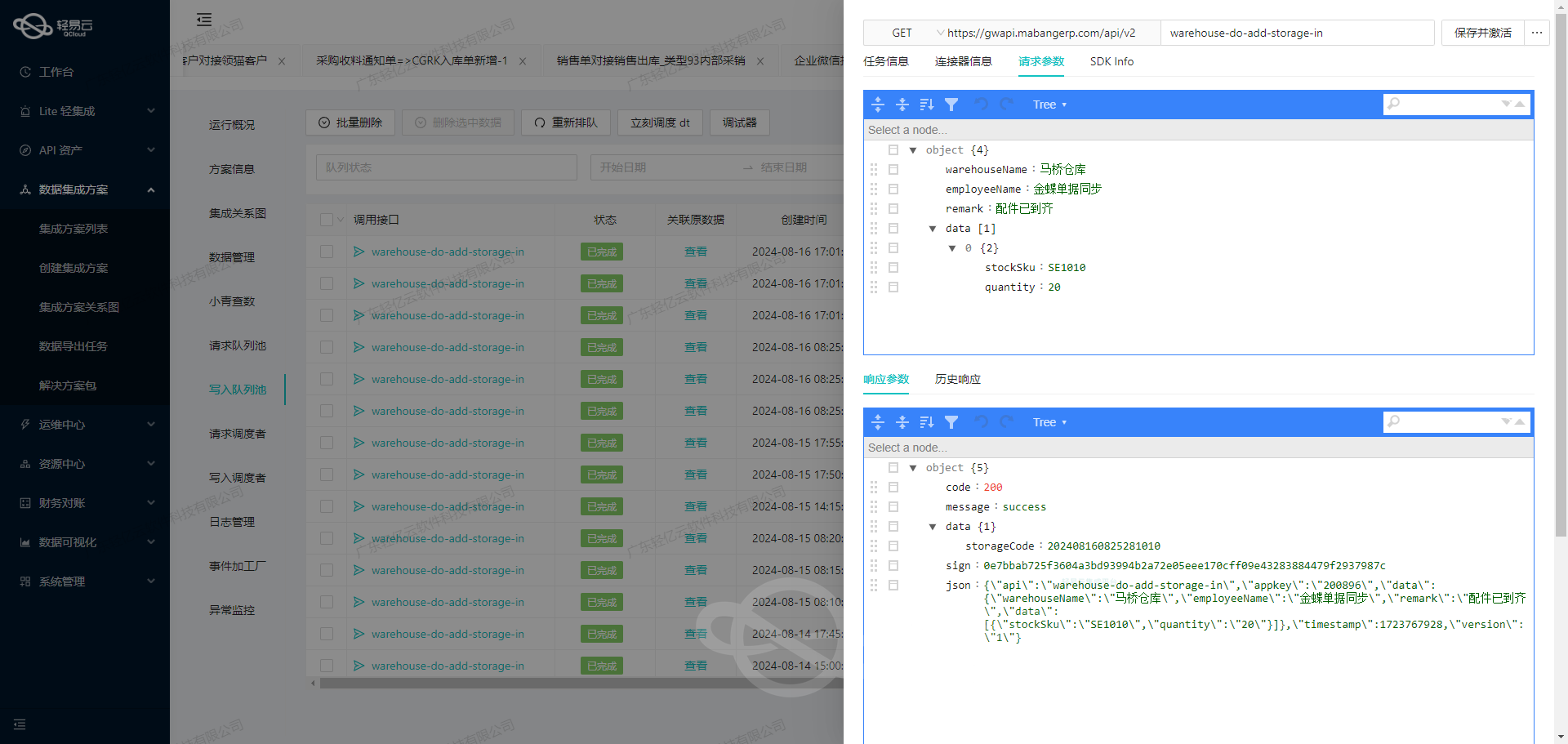

使用轻易云数据集成平台进行ETL转换与数据写入

在数据集成的生命周期中,ETL(Extract, Transform, Load)转换是一个至关重要的环节。本文将详细探讨如何将已经集成的源平台数据通过ETL转换为目标平台——轻易云集成平台API接口所能接收的格式,并最终写入目标平台。

数据请求与清洗

在进行ETL转换之前,首先需要从源系统获取数据并进行初步清洗。假设我们从吉客云获取组装拆卸出库查询的数据,这些数据可能包含冗余信息或格式不一致的问题。在这一阶段,我们需要确保数据的完整性和一致性,为后续的转换和写入做好准备。

数据转换

数据清洗完成后,进入ETL流程的核心部分——数据转换。为了使数据能够被轻易云集成平台API接口接收,我们需要根据目标平台的元数据配置对数据进行适当的转换。

元数据配置如下:

{

"api": "写入空操作",

"method": "POST",

"idCheck": true

}这个配置表明,我们需要使用POST方法调用“写入空操作”API,并且在调用前需要进行ID校验。以下是具体的技术实现步骤:

-

ID校验:首先检查源数据中的每一条记录是否包含有效的ID。如果缺少ID或者ID无效,需要进行补全或修正。这一步骤可以通过编写一个简单的Python脚本来实现:

def validate_and_correct_ids(data): for record in data: if 'id' not in record or not record['id']: record['id'] = generate_unique_id() return data def generate_unique_id(): # 实现生成唯一ID的逻辑 pass -

格式转换:根据目标API接口要求,将源数据转换为目标格式。例如,如果源数据包含多个字段,而目标API只接受特定字段,则需要提取并重组这些字段:

def transform_data_for_api(data): transformed_data = [] for record in data: transformed_record = { "id": record["id"], "field1": record["source_field1"], "field2": record["source_field2"] # 添加其他必要字段 } transformed_data.append(transformed_record) return transformed_data -

调用API接口:利用Python中的requests库,通过POST方法将转换后的数据发送到轻易云集成平台:

import requests def post_data_to_api(data): url = "https://api.qingyiyun.com/operation" headers = {"Content-Type": "application/json"} response = requests.post(url, json=data, headers=headers) if response.status_code == 200: print("Data successfully posted to API") else: print(f"Failed to post data: {response.status_code}") # 示例调用 cleaned_data = validate_and_correct_ids(source_data) transformed_data = transform_data_for_api(cleaned_data) post_data_to_api(transformed_data)

数据写入

最后一步是将经过转换的数据写入目标平台。通过上述步骤,我们已经将源平台的数据成功转换为轻易云集成平台API接口所能接收的格式,并通过POST方法提交到目标API。此时,轻易云集成平台会根据其内部机制对接收到的数据进行处理和存储。

以上便是使用轻易云数据集成平台进行ETL转换与数据写入的详细技术案例。通过这种方式,可以确保不同系统间的数据无缝对接,提高业务流程的效率和透明度。