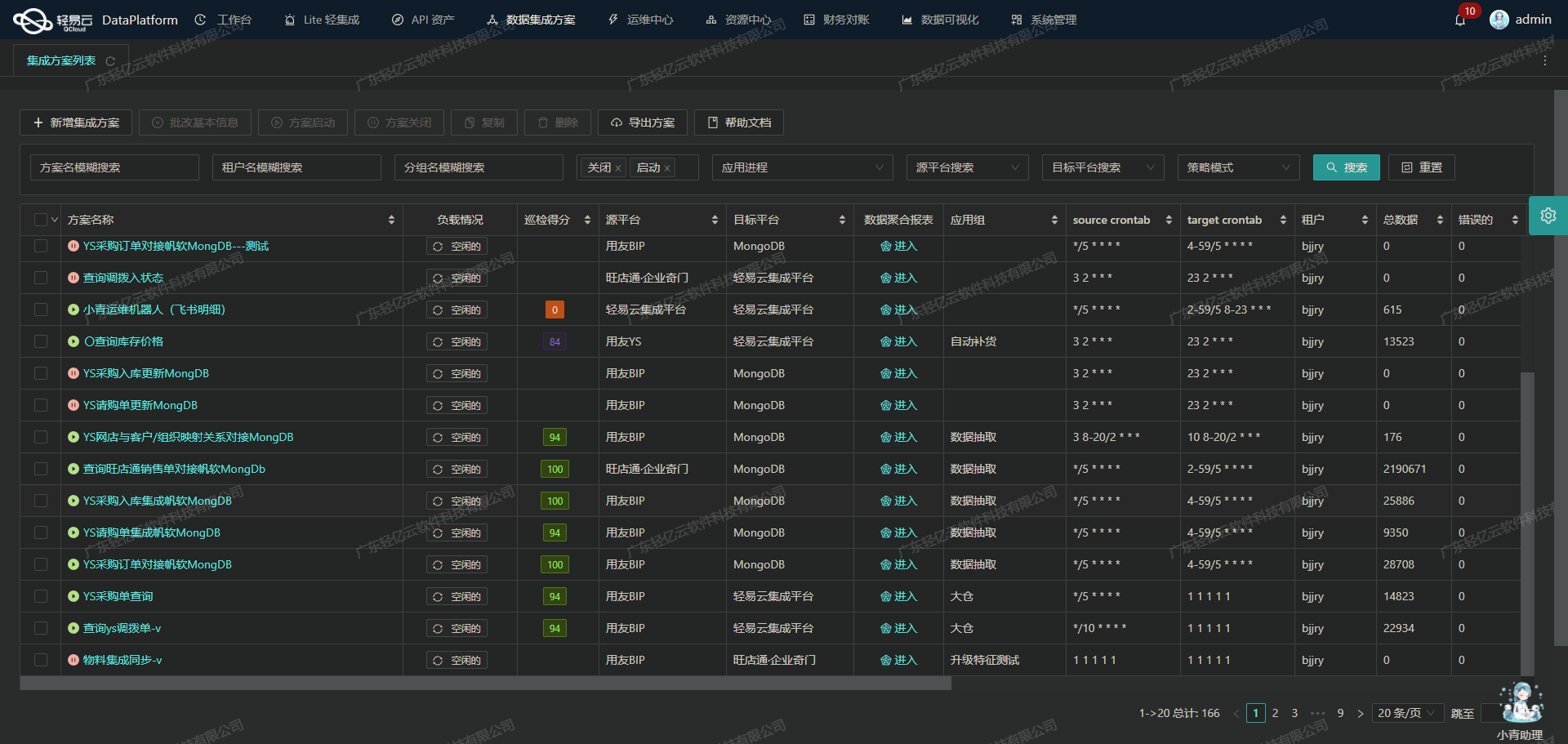

吉客云·奇门数据集成到MySQL:销售订单(OMS)方案

在现代企业的运营中,数据的高效流动和处理至关重要。本文将分享一个实际案例,展示如何通过轻易云数据集成平台,将吉客云·奇门系统中的销售订单(OMS)数据无缝对接到MySQL数据库中。

高吞吐量的数据写入能力

为了确保大量销售订单数据能够快速且准确地从吉客云·奇门系统转移到MySQL,我们利用了平台的高吞吐量数据写入能力。这一特性使得我们能够在短时间内处理大量订单信息,极大提升了数据处理的时效性。

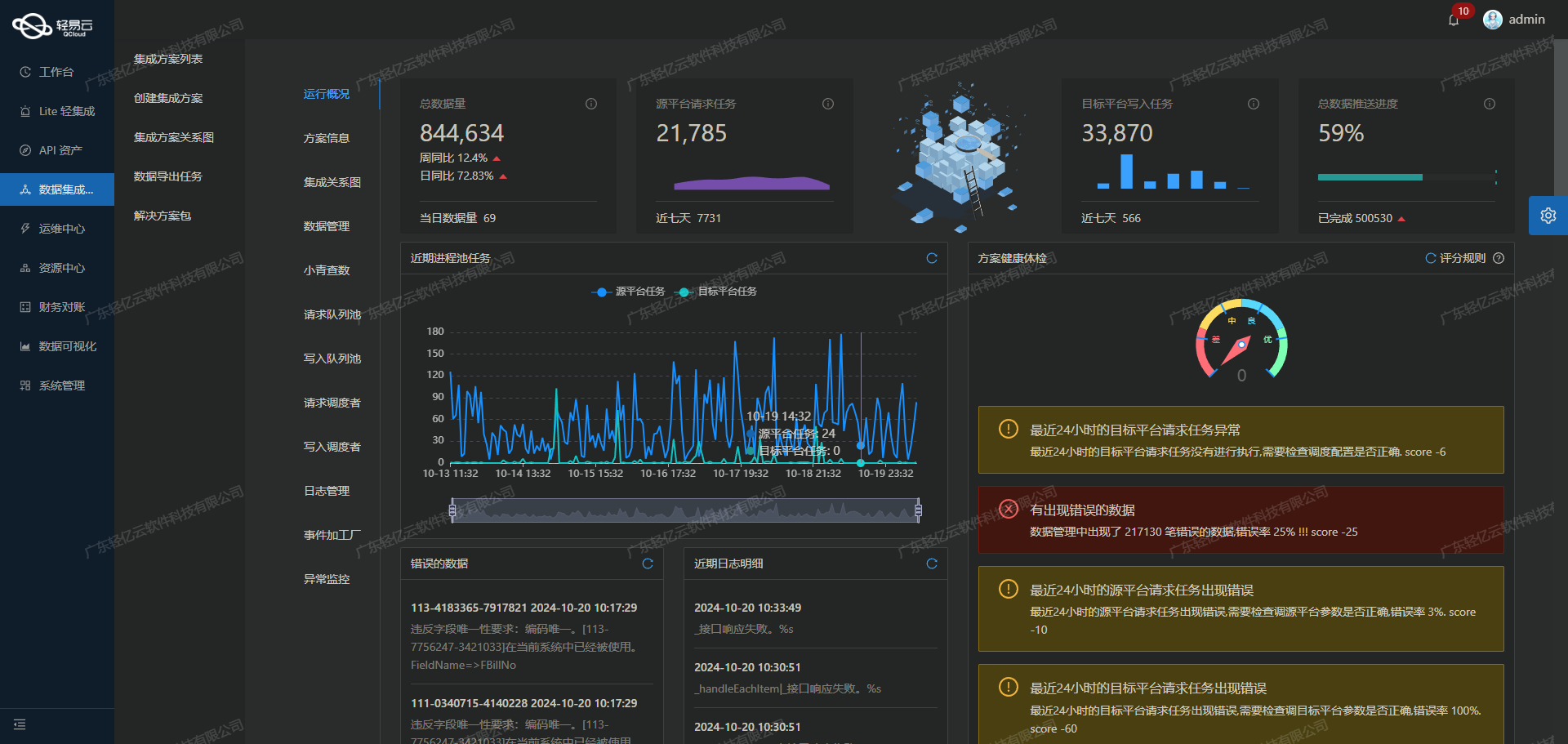

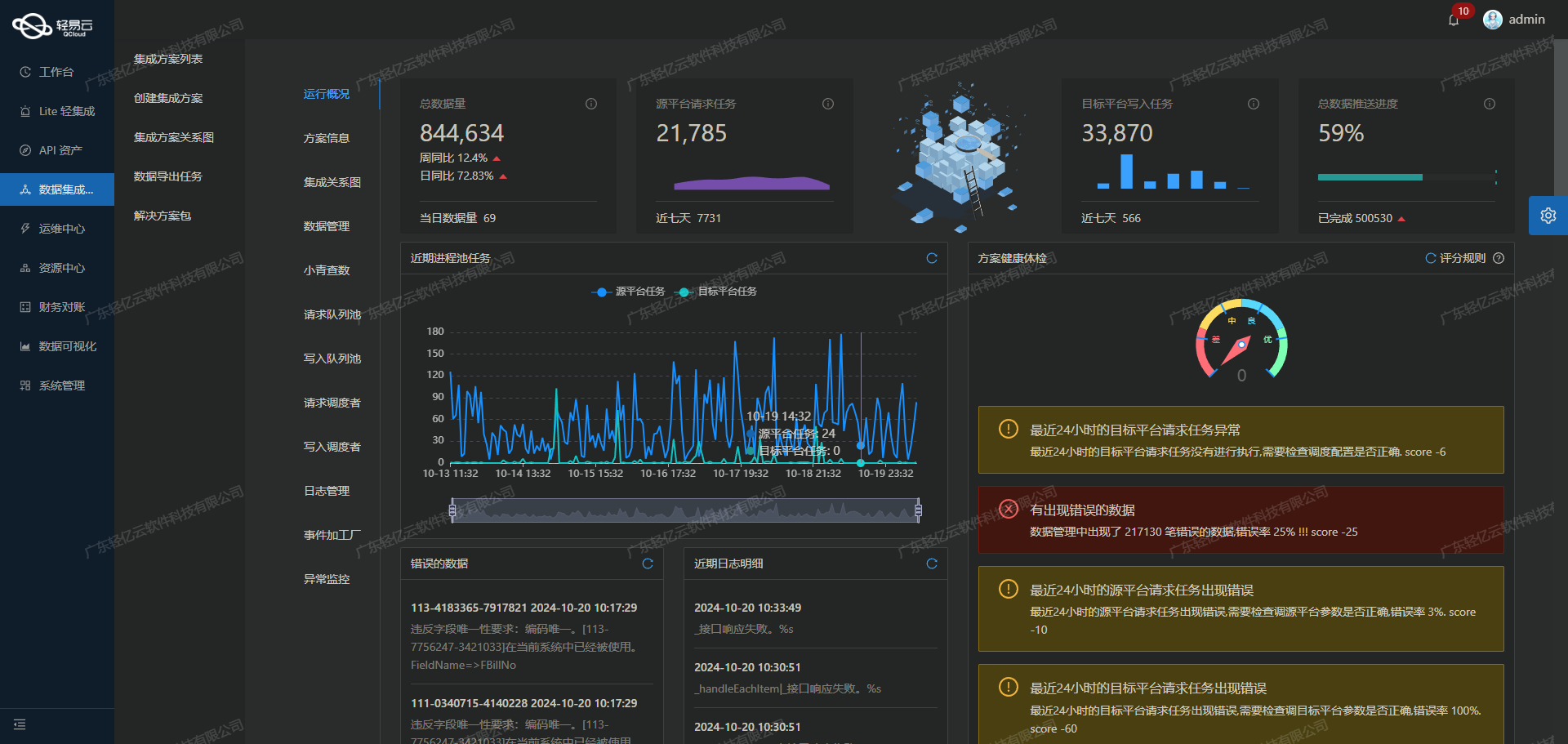

集中的监控和告警系统

在整个集成过程中,实时监控和告警系统发挥了关键作用。通过集中化的监控,我们可以随时跟踪每个数据集成任务的状态和性能。一旦出现异常情况,系统会立即发出告警通知,使我们能够迅速采取措施,确保数据传输过程不受影响。

数据质量监控与异常检测

为了保证集成过程中数据的准确性,我们引入了严格的数据质量监控和异常检测机制。这些机制帮助我们及时发现并处理可能存在的数据问题,从而避免因错误数据导致业务决策失误。

自定义数据转换逻辑

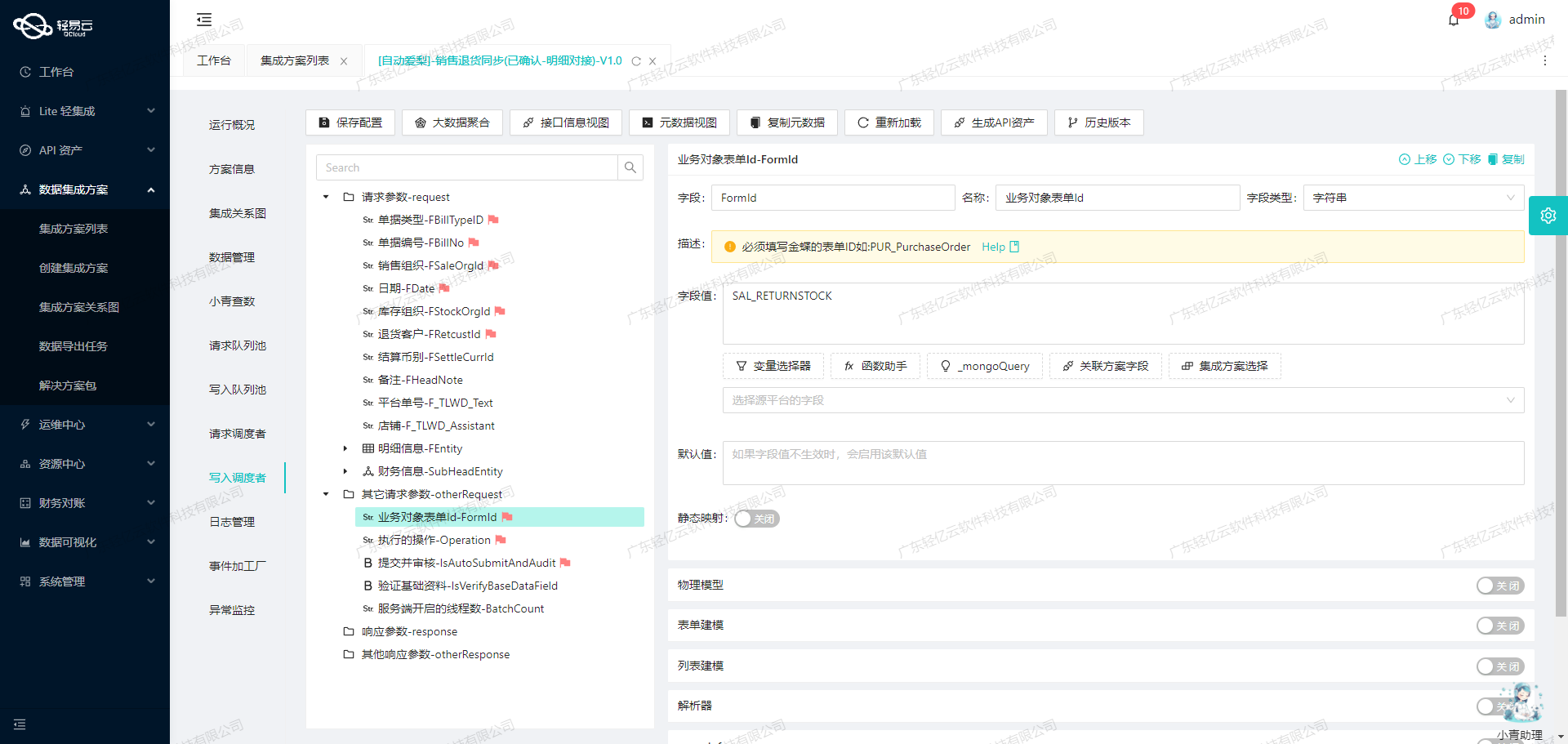

由于吉客云·奇门与MySQL之间的数据结构存在差异,我们设计了一套自定义的数据转换逻辑,以适应具体业务需求。通过这一灵活配置,我们能够确保每条订单信息都能正确映射到目标数据库中。

可视化的数据流设计工具

使用轻易云提供的可视化数据流设计工具,我们直观地构建了整个集成流程。从API调用、数据转换到最终写入MySQL,每一步操作都清晰可见,这不仅简化了管理,还提高了整体效率。

以上是本次技术案例的一些关键点。在接下来的章节中,我们将详细介绍如何调用吉客云·奇门接口jackyun.tradenotsensitiveinfos.list.get获取销售订单信息,并通过API executeReturn 将其批量写入到MySQL数据库。同时,还会探讨分页、限流以及异常处理等技术细节。

调用吉客云·奇门接口jackyun.tradenotsensitiveinfos.list.get获取并加工数据

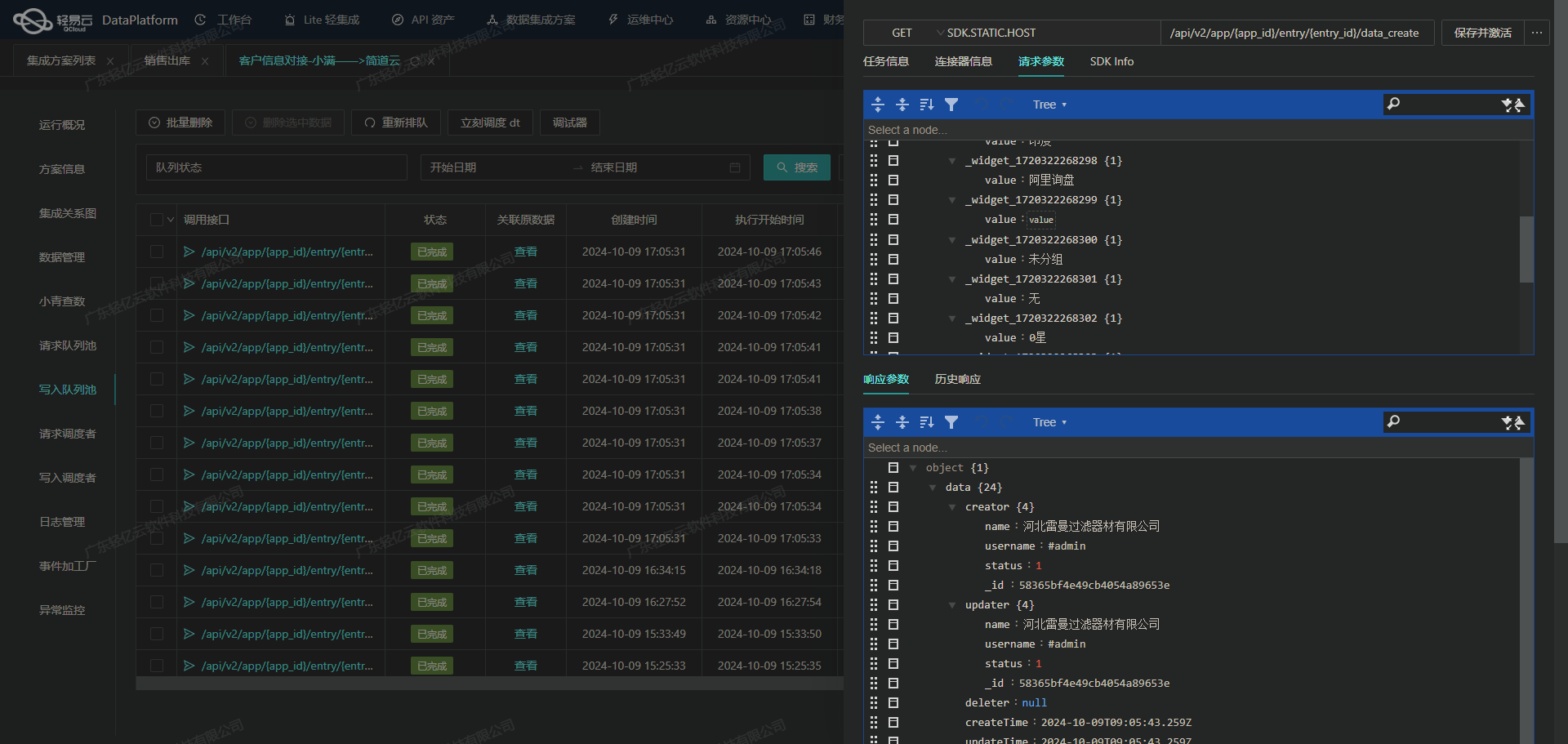

在数据集成过程中,调用源系统的API接口是至关重要的一步。本文将详细探讨如何通过轻易云数据集成平台调用吉客云·奇门接口jackyun.tradenotsensitiveinfos.list.get,并对获取的数据进行加工处理。

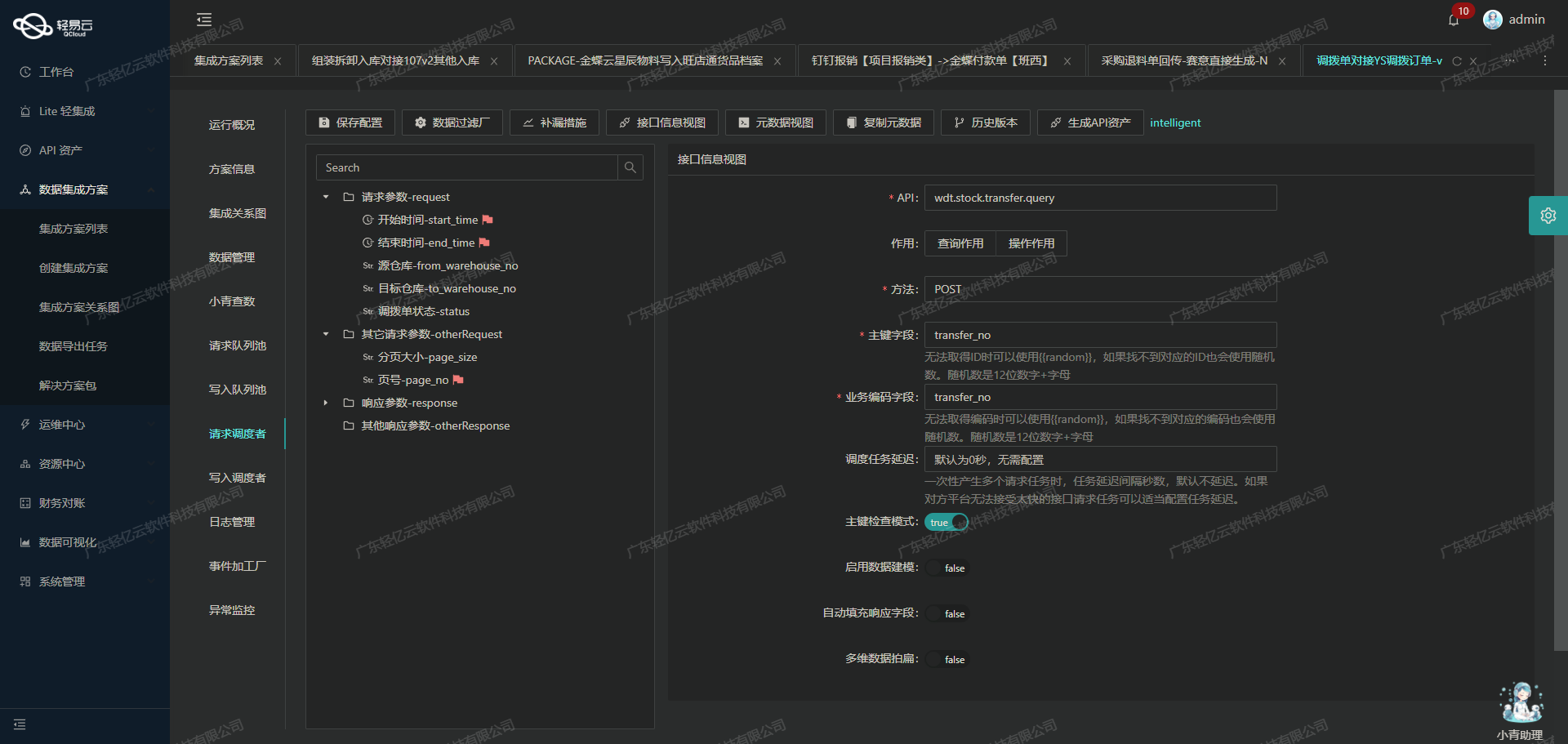

接口调用配置

首先,我们需要配置元数据以便正确调用吉客云·奇门的API接口。以下是关键的元数据配置项:

- api:

jackyun.tradenotsensitiveinfos.list.get - method:

POST - pagination: 支持分页,每页记录数为20

- formatResponse: 对返回的数据进行格式化,例如将

consignTime字段转换为新的日期格式字段consignTime_new - omissionRemedy: 定时任务配置,用于补救遗漏的数据请求

- idCheck: 启用ID检查,确保数据唯一性和完整性

- condition: 数据过滤条件,例如订单状态大于等于6000

这些配置项确保了我们能够高效、准确地从吉客云·奇门系统中获取所需的销售订单信息。

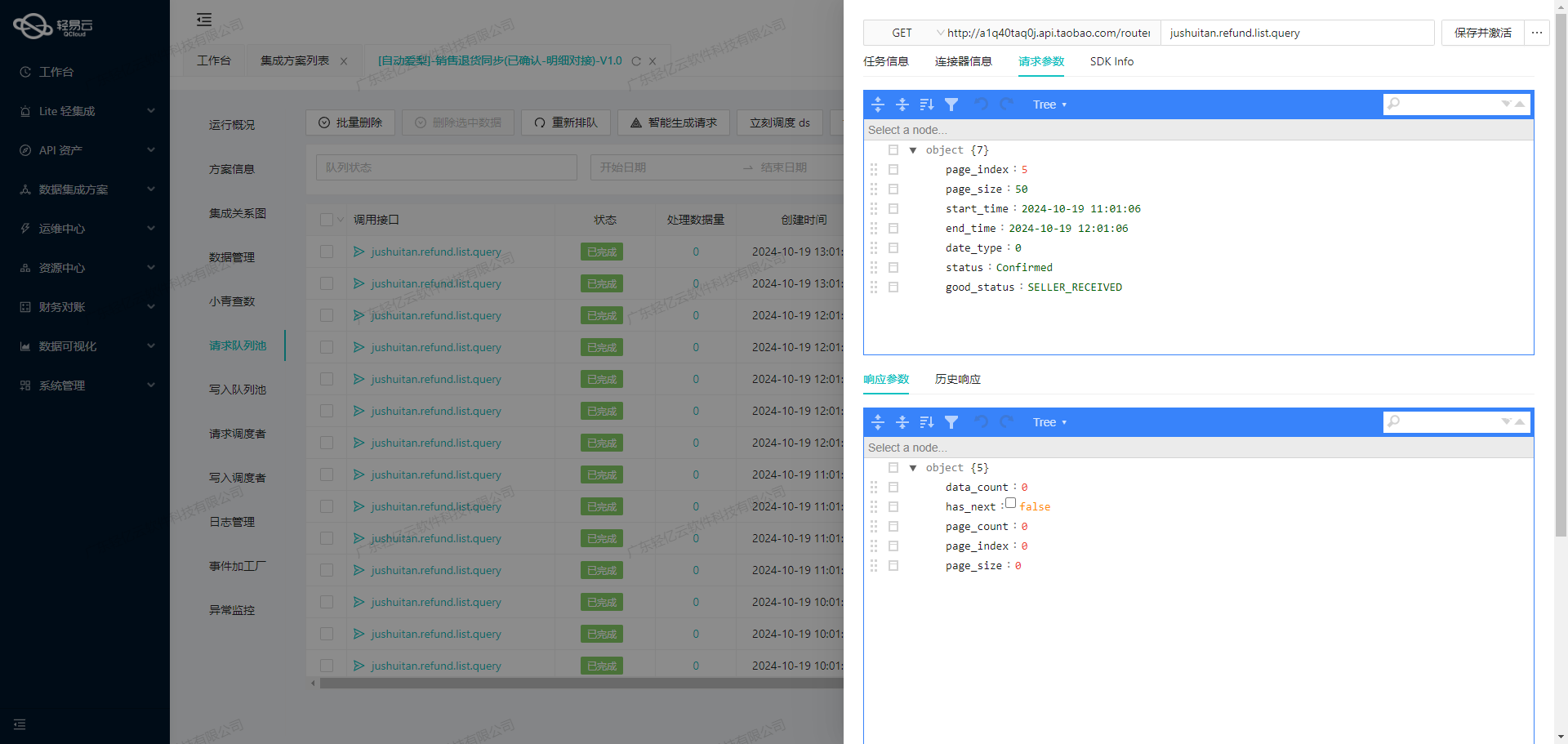

数据请求与清洗

在实际操作中,我们需要构建一个HTTP POST请求来调用该API接口,并传递必要的参数。例如:

{

"modified_begin": "2023-10-01T00:00:00Z",

"modified_end": "2023-10-07T23:59:59Z",

"pageSize": 20,

"pageIndex": 1,

"hasTotal": 1,

...

}上述请求参数包括起始时间和结束时间,用于限定查询范围。此外,通过分页参数控制每次请求的数据量,以避免超出系统限制。

数据转换与写入

在接收到API响应后,需要对返回的数据进行清洗和转换。例如,将原始字段consignTime转换为新的日期格式字段consignTime_new。这一步可以通过轻易云平台提供的自定义数据转换逻辑来实现。

{

"old": "consignTime",

"new": "consignTime_new",

"format": "date"

}这种方式不仅提高了数据的一致性,还能满足特定业务需求。在完成数据清洗和转换后,可以将处理后的数据批量写入到目标数据库(如MySQL)中。

异常处理与重试机制

在实际操作中,可能会遇到网络波动或其他异常情况导致API调用失败。为了保证数据集成过程的可靠性,需要设计异常处理与重试机制。例如,当检测到API调用失败时,可以自动触发重试逻辑,并记录错误日志以便后续分析和排查问题。

实时监控与告警

轻易云平台提供了强大的实时监控和告警功能,可以实时跟踪每个数据集成任务的状态和性能。一旦发现异常情况,如长时间未响应或返回错误码,即可及时发出告警通知相关人员进行处理。这种集中化的监控体系极大提升了系统运行的稳定性和可靠性。

总结

通过以上步骤,我们成功实现了从吉客云·奇门系统获取销售订单信息,并对其进行了有效的清洗和加工。在整个过程中,利用轻易云平台提供的各种工具和功能,不仅简化了操作流程,还显著提升了工作效率。这种全生命周期管理的方法,为企业实现高效、可靠的数据集成奠定了坚实基础。

使用轻易云数据集成平台进行销售订单(OMS)数据的ETL转换与MySQL写入

在数据集成生命周期的第二步,我们将重点关注如何将已经集成的源平台数据通过ETL转换,转为目标平台 MySQLAPI 接口所能够接收的格式,并最终写入目标平台。以下是具体的技术实现步骤和注意事项。

数据清洗与转换

首先,需要对源平台的数据进行清洗和转换,以确保其符合目标 MySQLAPI 接口的格式要求。元数据配置中详细定义了所需字段及其对应关系,例如:

trade_no对应订单编码trade_type对应销售单类型trade_status对应单据状态

这些字段需要从源数据中提取并映射到目标数据库表中的相应字段。此过程可以通过轻易云的数据转换工具实现,利用其提供的自定义逻辑和函数,确保每个字段的数据都能正确转换。例如:

case when {{goodsDetail.sellCount}} <> 0 then {{goodsDetail.shareFavourableAfterFee}} / {{goodsDetail.sellCount}} else 0 end上述表达式用于计算单价,确保在商品数量不为零时正确分摊优惠后的费用。

数据写入MySQL

在数据清洗和转换完成后,需要将处理好的数据写入MySQL数据库。元数据配置中定义了主表和扩展表的插入语句:

INSERT INTO `lehua`.`oms_sale_order`

(`trade_no`, `trade_type`, `trade_status`, ...)

VALUES

(<{trade_no: }>, <{trade_type: }>, <{trade_status: }>, ...);该语句将销售订单的主要信息插入到oms_sale_order表中。类似地,扩展表oms_sale_order_detail也有相应的插入语句,用于存储订单详情。

处理分页与限流问题

在调用吉客云·奇门接口时,可能会遇到分页和限流的问题。为了确保所有数据都能被完整抓取,可以采用以下策略:

- 分页处理:通过设置分页参数,逐页请求数据,并将每页的数据进行ETL处理后写入MySQL。

- 限流处理:根据接口文档设置合理的请求频率,避免触发限流机制。如果遇到限流,可以实现重试机制,在一定时间间隔后重新请求。

数据质量监控与异常处理

为了确保数据集成过程中的高质量,需要实时监控数据质量并及时处理异常情况。轻易云提供了集中监控和告警系统,可以跟踪每个数据集成任务的状态和性能。一旦检测到异常,如数据格式错误或网络问题,可以自动触发告警并执行预定义的重试机制。

例如,如果在写入MySQL时发生错误,可以捕获异常并记录日志,同时根据错误类型决定是否重试或终止操作。

自定义数据映射与逻辑

根据业务需求,自定义数据映射和转换逻辑也是必不可少的一环。例如,对于特定业务场景,需要将某些字段进行特殊处理,如日期格式转换、字符串拼接等。这些操作可以通过轻易云的平台工具实现,以满足不同业务场景下的数据需求。

实现高效批量写入

为了提高大批量数据写入MySQL的效率,可以使用批量插入技术,将多条记录一次性插入数据库,而不是逐条执行插入操作。这不仅减少了数据库连接次数,还能显著提升写入速度。

综上所述,通过轻易云的数据集成平台,我们能够高效地完成销售订单(OMS)数据从源平台到目标 MySQLAPI 接口的ETL转换和写入工作。在此过程中,需要特别关注数据清洗与转换、分页与限流处理、数据质量监控与异常处理、自定义映射逻辑以及批量写入技术,以确保整个流程顺畅高效。