钉钉数据集成到MySQL的技术案例分享

在企业数据管理中,如何高效、准确地将钉钉平台的数据集成到MySQL数据库,是一个常见且关键的问题。本文将聚焦于“品类即时贡献报表集成方案-推广费更新”这一具体案例,详细探讨其技术实现过程。

首先,我们需要解决的是如何确保从钉钉获取的数据不漏单,并能定时可靠地抓取接口数据。通过调用钉钉提供的API v1.0/yida/forms/instances/ids/{appType}/{formUuid},我们能够实时获取所需的业务数据。在此过程中,处理分页和限流问题是关键一环。为此,我们设计了一套高效的分页策略和限流机制,以确保数据抓取的完整性和稳定性。

其次,在大量数据快速写入到MySQL时,高吞吐量的数据写入能力显得尤为重要。通过使用MySQL的execute API,我们能够批量、高效地将从钉钉获取的数据写入数据库。同时,为了应对可能出现的数据格式差异,我们支持自定义数据转换逻辑,以适应特定业务需求和数据结构。这不仅提高了数据处理效率,也保证了数据的一致性和准确性。

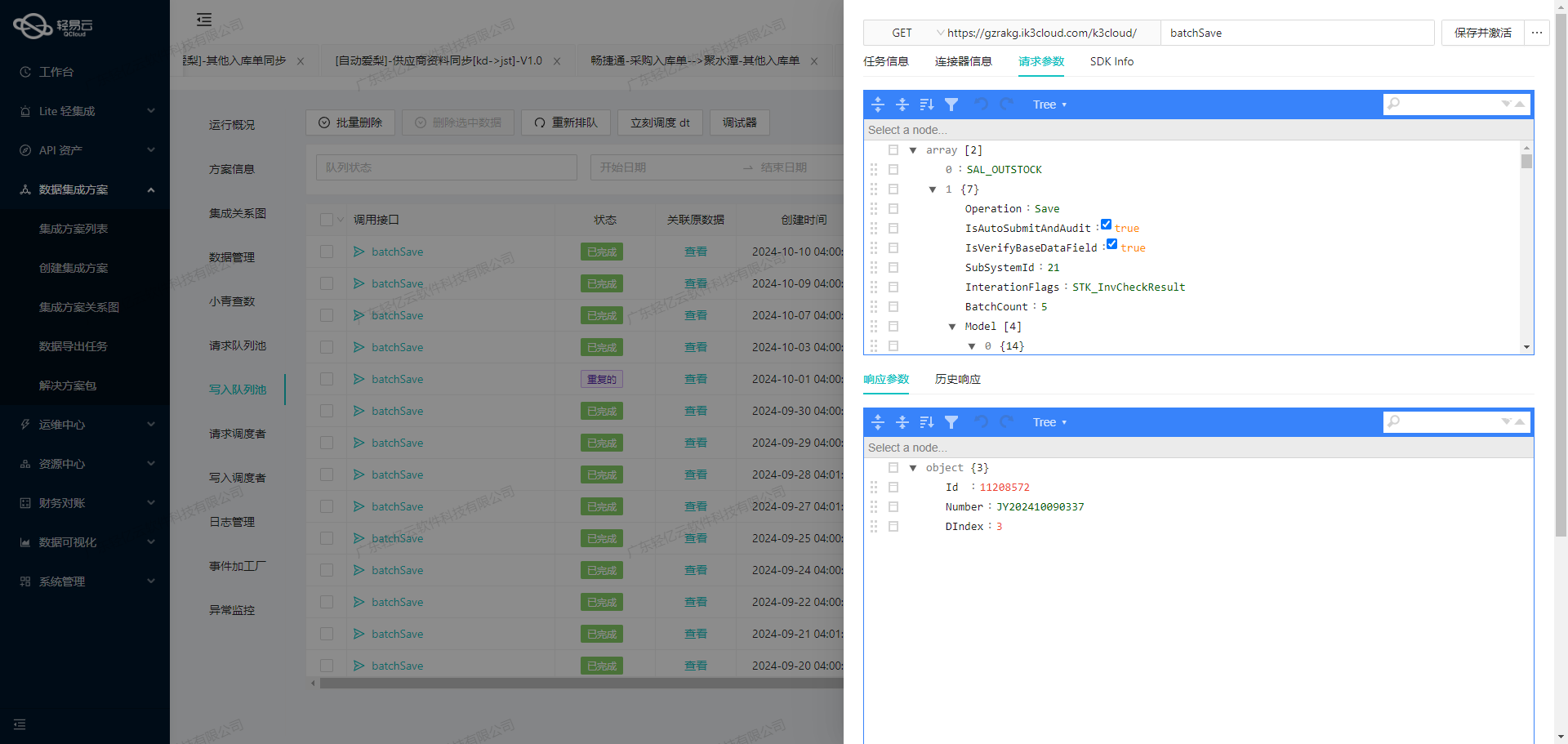

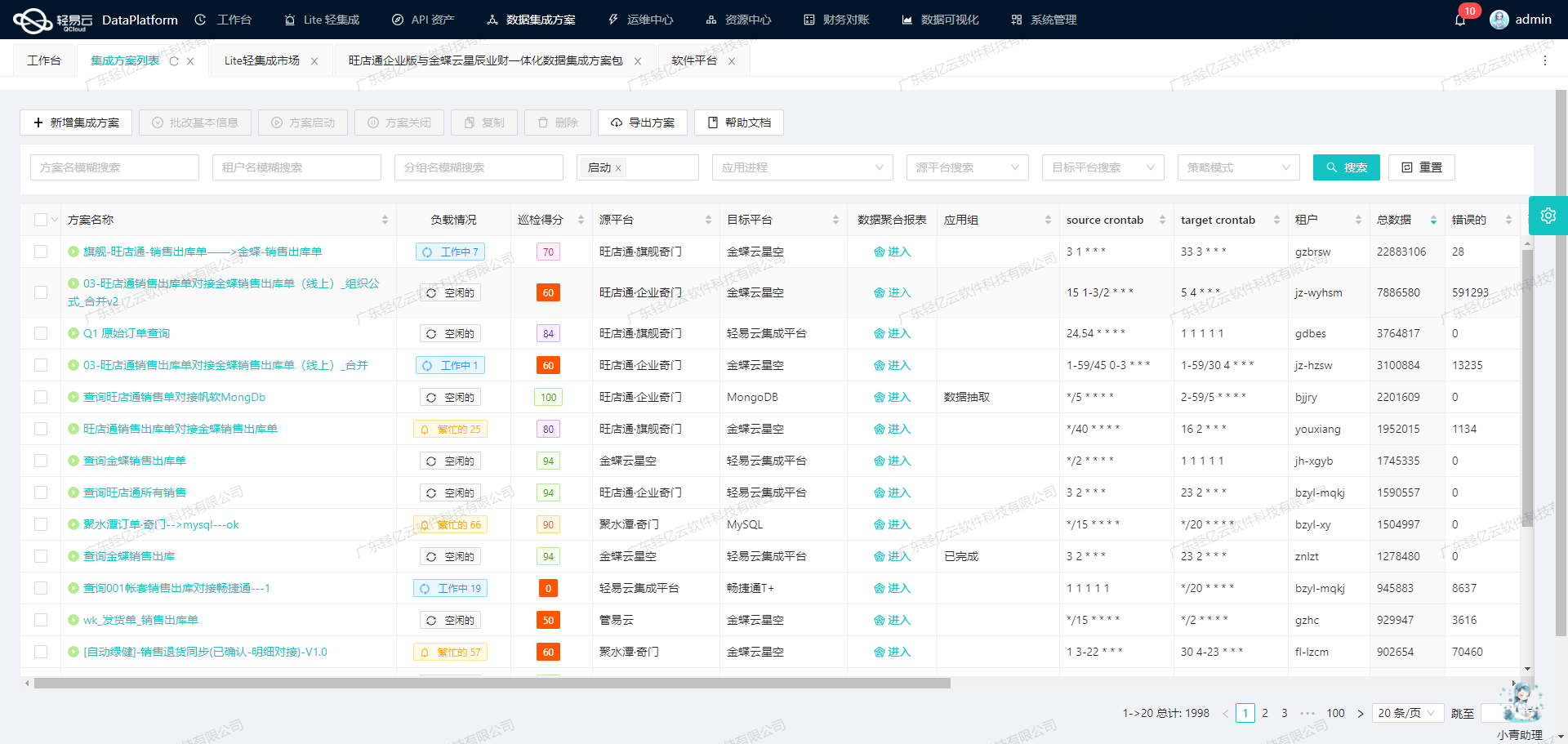

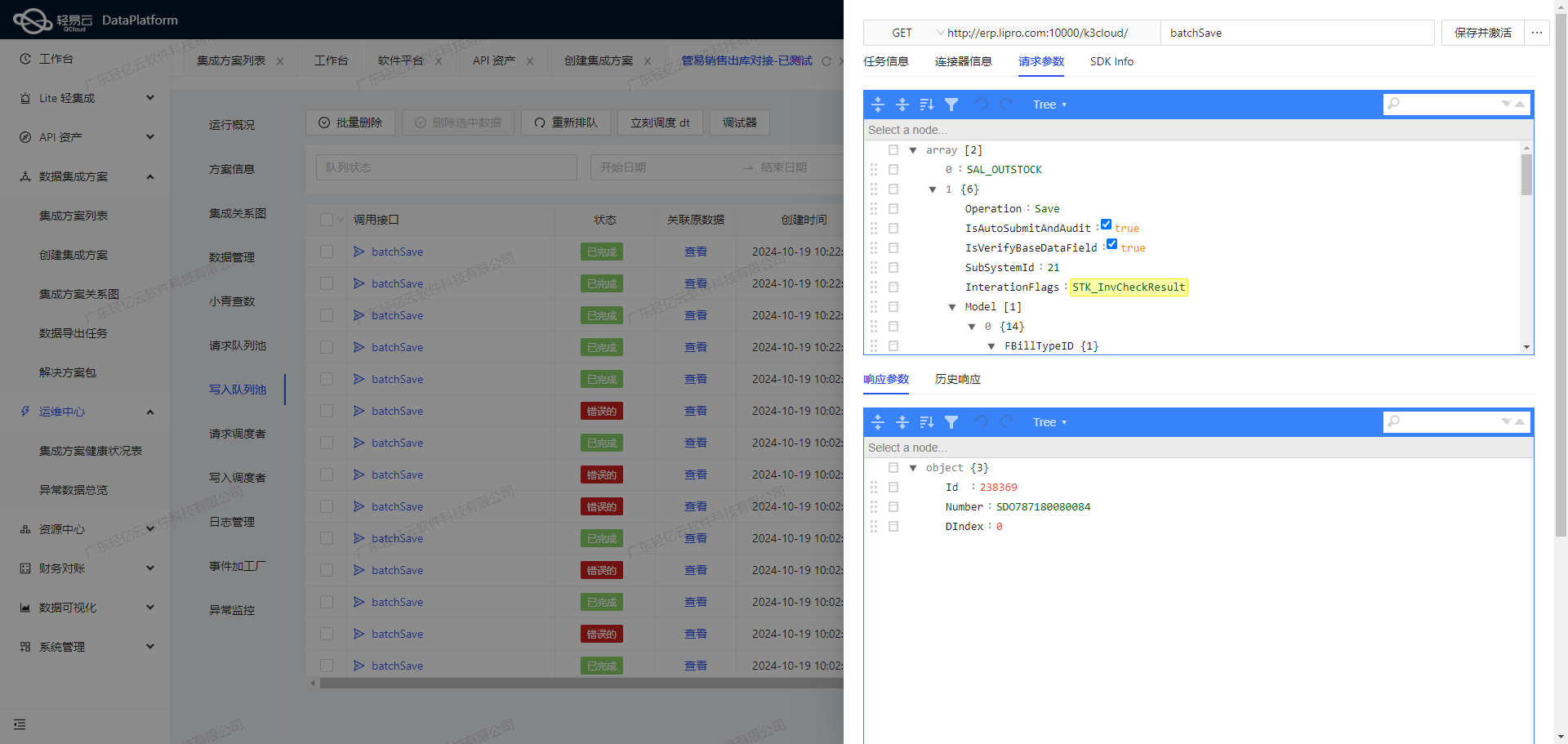

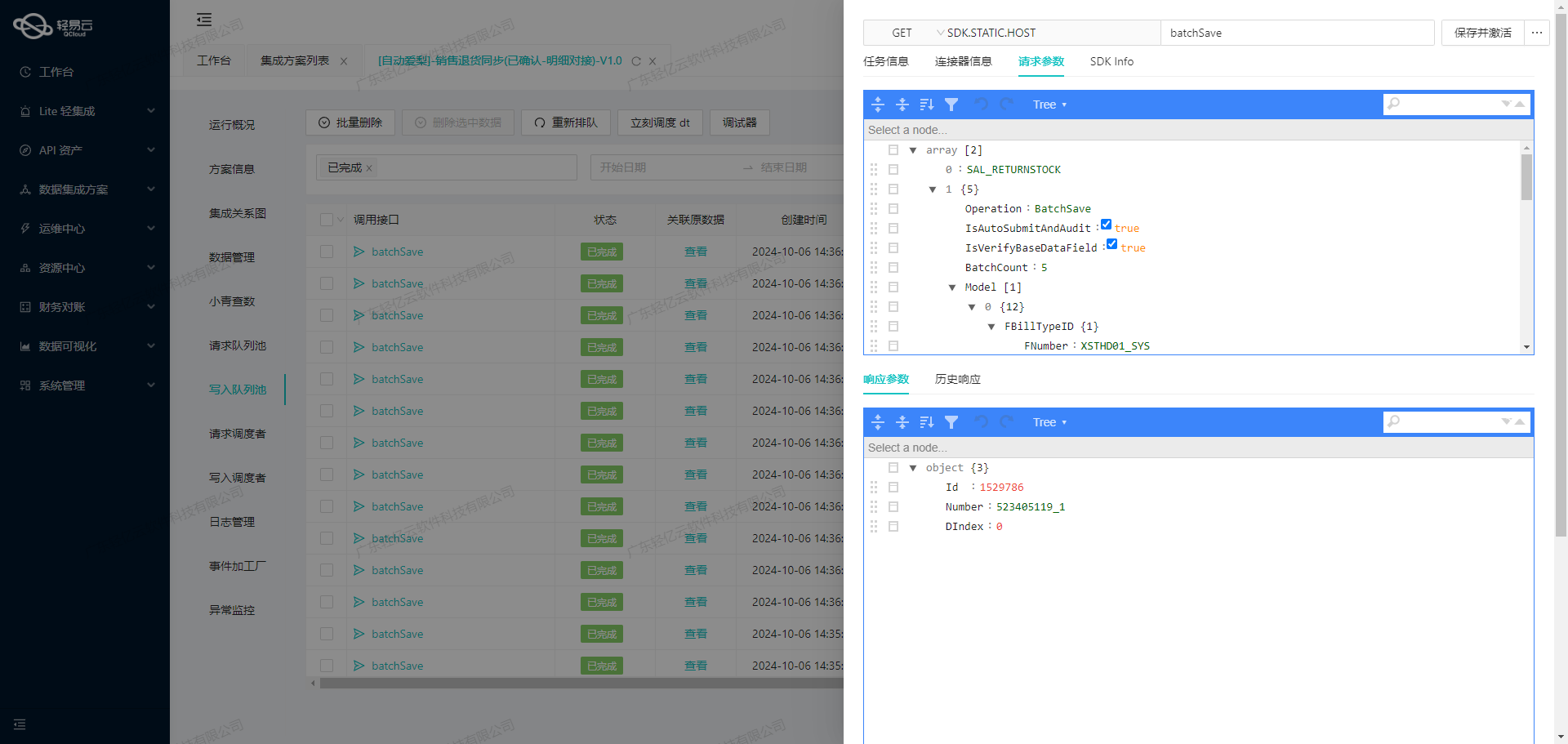

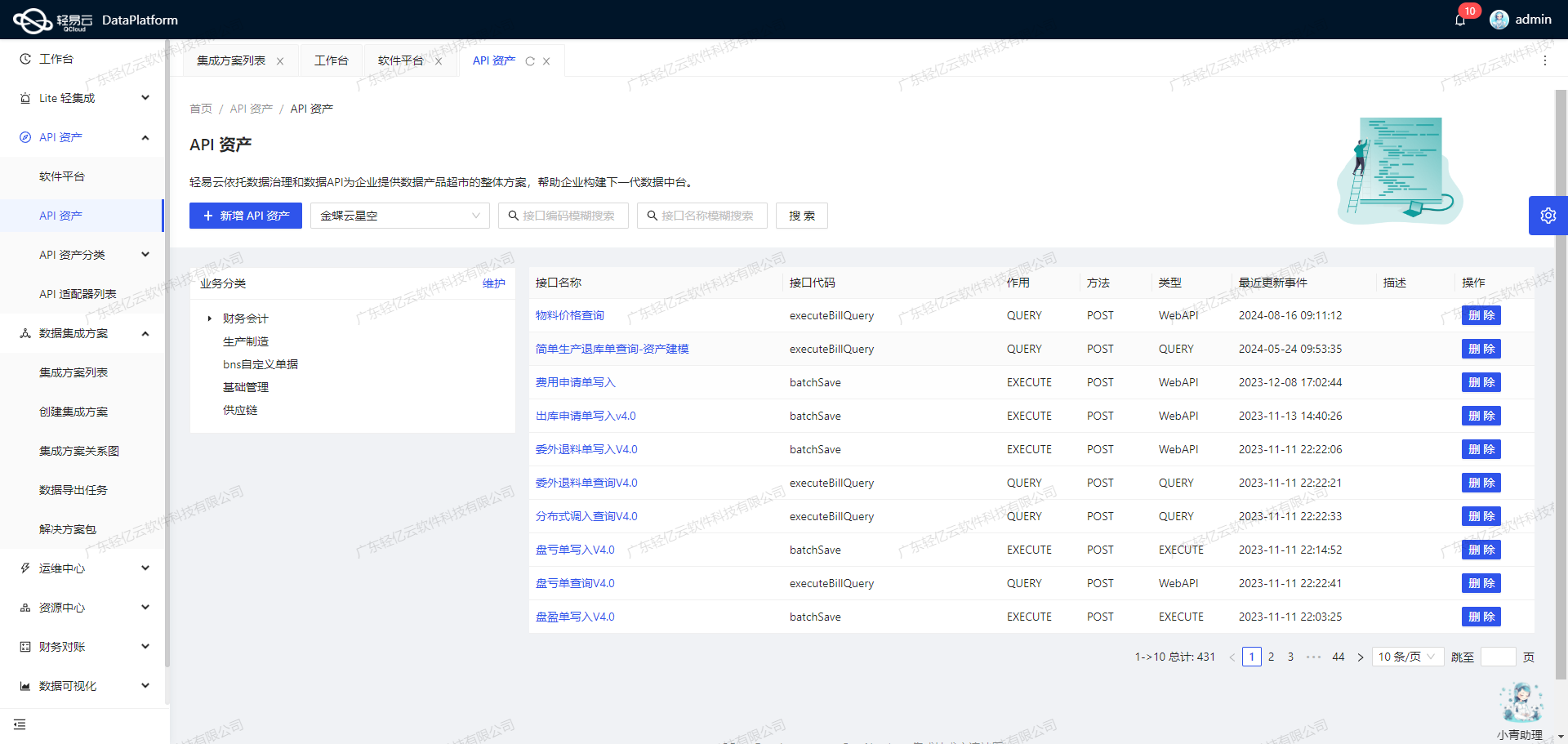

此外,为了全面掌握API资产的使用情况,实现资源的高效利用和优化配置,我们采用了集中监控和告警系统。该系统实时跟踪每个数据集成任务的状态和性能,一旦发现异常情况,能够及时发出告警并进行处理。这种全透明可视化操作界面,不仅提升了业务透明度,还极大地提高了运维效率。

最后,在整个集成过程中,异常处理与错误重试机制同样不可或缺。当遇到网络波动或接口响应异常时,该机制能够自动进行重试操作,从而保证任务执行的连续性与可靠性。同时,通过实时监控与日志记录功能,我们可以随时查看每个步骤的执行情况,为后续问题排查提供有力支持。

综上所述,本次“品类即时贡献报表集成方案-推广费更新”案例,通过一系列技术手段,实现了从钉钉到MySQL的数据无缝对接,为企业提供了一套高效、可靠的数据集成解决方案。

钉钉接口数据集成与加工处理技术详解

在轻易云数据集成平台的生命周期中,调用源系统钉钉接口获取并加工数据是至关重要的一步。本文将深入探讨如何通过调用钉钉接口v1.0/yida/forms/instances/ids/{appType}/{formUuid}来实现这一过程。

调用钉钉接口获取数据

首先,通过POST请求方式调用钉钉API。以下是关键的元数据配置:

- api:

v1.0/yida/forms/instances/ids/{appType}/{formUuid} - method:

POST - request参数:

appType: 应用编码formUuid: 表单IDpageNumber: 分页页码pageSize: 分页大小modifiedToTimeGMT: 修改时间终止值systemToken: 应用秘钥modifiedFromTimeGMT: 修改时间起始值language: 语言(默认中文)

这些参数确保了我们能够准确地从指定表单中提取所需的数据。

数据分页与限流处理

由于API返回的数据量可能较大,我们需要处理分页和限流问题。通过设置pageNumber和pageSize参数,可以有效控制每次请求的数据量。例如,每次请求50条记录,并逐页获取,直到没有更多数据为止。这种方式不仅能避免超时,还能确保高效的数据抓取。

{

"field": "pageNumber",

"value": "1"

},

{

"field": "pageSize",

"value": "50"

}数据清洗与转换

在获取到原始数据后,需要进行清洗和转换,以适应目标系统的需求。常见的操作包括:

- 字段映射:将源系统中的字段映射到目标系统中的相应字段。

- 格式转换:例如,将日期格式从GMT转换为本地时间。

- 异常处理:检测并处理异常值,如空值或格式错误的数据。

这些操作可以通过自定义脚本或内置的转换工具来实现,确保数据质量和一致性。

实时监控与日志记录

为了保证整个集成过程的可靠性,实时监控和日志记录是必不可少的。轻易云平台提供了集中监控和告警系统,可以实时跟踪每个任务的状态和性能。一旦出现异常情况,如网络故障或API响应错误,系统会立即发出告警,并自动执行重试机制,以最大程度减少对业务的影响。

{

"field": "systemToken",

"value": "KYC664C1WR9LODIIAI09I913S0HO2G3YGREWL43"

}数据写入MySQL

在完成数据清洗和转换后,将其批量写入MySQL数据库。轻易云平台支持高吞吐量的数据写入能力,使得大量数据能够快速被集成到MySQL中。同时,通过定制化的数据映射对接,可以灵活适应不同业务需求,实现精准的数据存储。

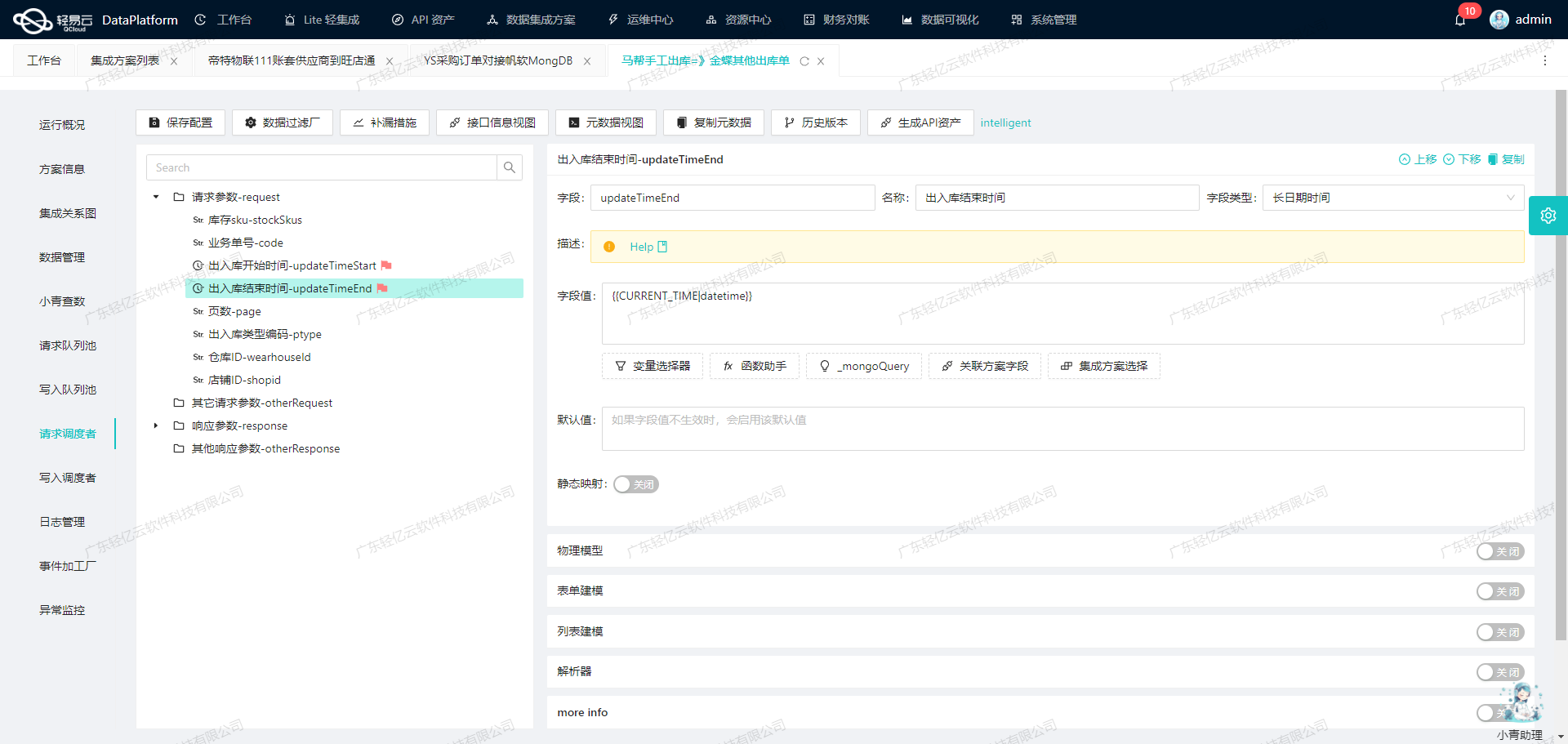

{

"field": "modifiedToTimeGMT",

"value": "{{CURRENT_TIME|datetime}}"

}异常处理与重试机制

在实际操作过程中,不可避免会遇到各种异常情况,如网络波动、API限流等。因此,需要设计健全的异常处理与重试机制。例如,当某次请求失败时,可以根据预设策略进行多次重试,并记录详细日志以便后续分析和优化。

综上所述,通过合理配置元数据、有效处理分页与限流、精细化的数据清洗与转换,以及完善的监控告警机制,我们可以高效、安全地实现钉钉接口数据集成,为企业提供可靠的数据支持。

集成方案:品类即时贡献报表集成方案-推广费更新

在数据集成生命周期的第二步,我们需要将已经从源平台获取的数据进行ETL转换,使其符合目标平台MySQLAPI接口的格式要求,并最终写入目标平台。这一过程涉及多个关键步骤,包括数据清洗、数据转换和数据写入。

数据清洗与转换

首先,我们需要对从源平台获取的数据进行清洗和转换。轻易云数据集成平台提供了丰富的功能来支持这一过程,通过自定义数据转换逻辑,可以满足特定业务需求和数据结构的要求。

元数据配置中定义了详细的字段映射关系,每个字段都有对应的类型、描述及其在SQL语句中的具体使用方式。例如:

{

"field": "date",

"label": "日期",

"type": "timestamp",

"value": "_function FROM_UNIXTIME( ( {dateField_lx4mftg2} \/ 1000 ) ,'%Y-%m-%d' )"

}在这个配置中,date字段需要从UNIX时间戳转换为标准日期格式,这通过FROM_UNIXTIME函数实现。此外,其他字段如expense(推广费用金额)也需要根据业务逻辑进行相应的处理。

数据写入MySQL

完成数据清洗和转换后,下一步是将这些处理后的数据写入MySQL数据库。轻易云平台支持高吞吐量的数据写入能力,使得大量数据能够快速被集成到目标平台中,从而提升了数据处理的时效性。

以下是主SQL语句的一个示例,该语句用于执行更新操作:

UPDATE `lehua`.`promotion_expenses`

SET

`platform` = <{platform: }>,

`date` = <{date: }>,

`shop_name` = <{shop_name: }>,

...

WHERE `form_instance_id` = <{form_instance_id: }>;此SQL语句中的占位符会被实际的数据值替换,从而完成最终的数据写入操作。

处理分页与限流问题

在处理钉钉接口时,经常会遇到分页和限流的问题。为确保数据不漏单并且高效地抓取所有必要的数据,需要设计合理的分页策略,并结合限流机制进行控制。例如,可以通过设置合适的分页大小和请求间隔时间,确保不会触发API调用限制。

异常处理与错误重试机制

为了保证数据写入过程的可靠性,必须实现异常处理与错误重试机制。当出现网络故障或数据库连接问题时,系统应能够自动检测并重新尝试执行失败的操作。此外,通过实时监控与日志记录,可以及时发现并解决潜在问题,确保整个ETL过程平稳运行。

自定义数据映射

针对不同业务需求,可能需要对某些字段进行定制化的数据映射。例如,根据不同推广费类型ID,将费用分配到站内或站外推广费字段:

{

"field": "instation_expense",

"label": "站内推广费",

"type": "float",

"value": "_function IF( (STRCMP('{textField_lx4mftgo}','type17')), {numberField_lx4mftgp} ,0)"

},

{

"field": "outstation_expense",

"label": "站外推广费",

"type": "float",

"value": "_function IF( (STRCMP('{textField_lx4mftgo}','type17')), 0,{numberField_lx4mftgp})"

}通过这种方式,可以灵活地调整不同类型费用的数据存储方式,从而更好地满足业务需求。

总结

通过以上步骤,我们可以高效地将源平台的数据经过ETL转换后写入MySQLAPI接口所能接收的格式,并最终存储到目标平台中。在这个过程中,合理利用轻易云提供的各种功能,如高吞吐量写入、自定义转换逻辑、异常处理等,可以显著提升整体集成效率和可靠性。